NVMe etabliert sich in High-End-Speichern

Lenovo rundet sein Storage-Portfolio mit der strategischen Partnerschaft mit Excelero und deren NVMesh-Technologie nach oben in den Bereich High-End-Storage ab. Die Software-Lösung ist flexibel einsetzbar und bündelt NVMe-Ressourcen über mehrere Systeme. Der Zugriff auf NVMe-Module in entfernten Systemen soll dabei nur unwesentlich langsamer sein, als lokal, und immer noch deutlich schneller, als der Zugriff auf HDDs.

Lenovo rundet sein Storage-Portfolio mit der strategischen Partnerschaft mit Excelero und deren NVMesh-Technologie nach oben in den Bereich High-End-Storage ab. Die Software-Lösung ist flexibel einsetzbar und bündelt NVMe-Ressourcen über mehrere Systeme. Der Zugriff auf NVMe-Module in entfernten Systemen soll dabei nur unwesentlich langsamer sein, als lokal, und immer noch deutlich schneller, als der Zugriff auf HDDs.Von Sven Nimmich, Lenovo

Lenovo ThinkSystem DMBereits seit Herbst 2018 macht Lenovo im Storage-Bereich gemeinsame Sache mit NetApp und kann damit All-Flash-Systeme anbieten. Die Lenovo ThinkSystem DE-Serie adressiert dabei den Einsteigermarkt mit leistungsfähigen aber nur begrenzt flexiblen All-Flash-Arrays. Die Dual-Controller-Systeme beherrschen ganz klassisch Fiber-Channel und iSCSI, und lassen sich in kleinem Umfang auch nach Bedarf erweitern. Einen deutlichen Schritt weiter geht da die ThinkSystem DM-Serie. Neben Fiber-Channel und iSCSI für Block-Storage können die in Active-/Active-Betrieb laufenden Controller auch NFS, pNFS und das für die Windows-Welt wichtige SMB ausliefern. Die »Unified Storage Arrays« laufen mit dem Datenmanagement-Betriebssystem ONTAP, mit der dazugehörigen Flexibilität. In den Hybrid- und All-Flash-Varianten sind herkömmliche SAS-SSDs verbaut. NVMe wird in diesen Systemen nur als Cache-Layer für automatisches Multi-Tiering genutzt, kann aber nicht als explizites Volume von außen angesprochen werden.

Lenovo ThinkSystem DMBereits seit Herbst 2018 macht Lenovo im Storage-Bereich gemeinsame Sache mit NetApp und kann damit All-Flash-Systeme anbieten. Die Lenovo ThinkSystem DE-Serie adressiert dabei den Einsteigermarkt mit leistungsfähigen aber nur begrenzt flexiblen All-Flash-Arrays. Die Dual-Controller-Systeme beherrschen ganz klassisch Fiber-Channel und iSCSI, und lassen sich in kleinem Umfang auch nach Bedarf erweitern. Einen deutlichen Schritt weiter geht da die ThinkSystem DM-Serie. Neben Fiber-Channel und iSCSI für Block-Storage können die in Active-/Active-Betrieb laufenden Controller auch NFS, pNFS und das für die Windows-Welt wichtige SMB ausliefern. Die »Unified Storage Arrays« laufen mit dem Datenmanagement-Betriebssystem ONTAP, mit der dazugehörigen Flexibilität. In den Hybrid- und All-Flash-Varianten sind herkömmliche SAS-SSDs verbaut. NVMe wird in diesen Systemen nur als Cache-Layer für automatisches Multi-Tiering genutzt, kann aber nicht als explizites Volume von außen angesprochen werden.

Mit NVMe wird alles besser?

Der allzu naive Einsatz von NVMe birgt verschiedene Herausforderungen, die von NVMe versprochene Geschwindigkeits-Verbesserung bleibt dabei oft genug auf der Strecke oder ist nicht so umfangreich, wie einem Werbung suggeriert. Bislang wird NVMe überwiegend in einem einzelnen Host als Steckkarte oder Steckmodul genutzt. Software wird hier zum limitierenden Faktor und kann das NVMe-Storage häufig gar nicht so schnell bedienen, wie es die Theorie zulässt. Wäre es nicht im Sinne des Investitionsschutzes, wenn brachliegende NVMe-Kapazität beispielsweise von anderen Hosts mit genutzt werden könnte?

Im NVMe-Protokoll war es anfangs nicht vorgesehen, dass mehrere Hosts auf ein NVMe-Volume zugreifen. Bei herkömmlichen Storage-Systemen ist Multi-Hosting dagegen üblich und wird bei externen Storage-Systemen auch häufig genutzt. Die Erweiterung des NVMe-Protokolls auf »NVMe over Fabrics« (NVMe-oF) war also nur eine Frage der Zeit. Die erste Version des NVMe-oF-Standards wurde im Sommer 2016 veröffentlicht. Bereits mit der ersten Version des Standards war vorgesehen, die Fabric-Erweiterung NVMe-oF für Infiniband, Ethernet oder Fiber-Channel als Transportschicht zu spezifizieren.

NVMesh: Jetzt auch mit Turbolader

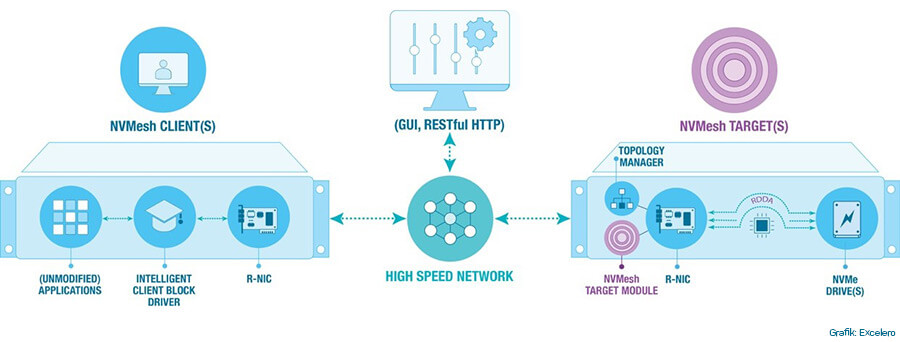

Im Frühjahr 2019 erweiterte Lenovo sein Storage-Portfolio mit der Software-Lösung NVMesh des strategischen Partners Excelero. Die Software kann auf verschiedene Arten betrieben werden, Ziel ist dabei immer, dass maximal mögliche an Performance und Auslastung aus NVMe-Flash heraus zu holen. NVMesh fasst einzelne NVMe-Module zu einem großen Storage zusammen, aus dem einzelne Volumes exportiert werden. Ganz so, wie man das auch von RAID-Systemen kennt. Die Software installiert clientseitig einen »Intelligent Client Block Driver« und auf der Gegenseite ein »NVMesh Target Module« sowie einen »Topology Manager«. Alle drei Komponenten können auch gemeinsam auf einem System laufen. Die Kommunikation zwischen Client und Target erfolgt über ein schnelles, latenzarmes Netzwerk. Derzeit möglich sind Infiniband oder Ethernet.

NVMesh-Architektur (Grafik: Excelero)

NVMesh-Architektur (Grafik: Excelero)

Für eine Server-Farm mit lauter gleichberechtigten Knoten bietet sich an, NVMesh »converged« zu betreiben: Alle NVMe-Module in den einzelnen Servern werden dazu per Software zu einem einzigen, großen Pool zusammen geschaltet, aus dem sich wiederum alle Server bedienen können. So erreicht man ein Ressourcen-Sharing, und alle NVMe-Module können gleichmäßig ausgelastet werden. In einer »disaggregated« Betriebsart gibt es dediziertes, zentralisiertes NVMe-Storage im eigenen Chassis. Alle Knoten im Rack beziehen ihre NVMe-Volumes von diesem zentralisierten Storage. In beiden Fällen ist ein schnelles und latenzarmes Netzwerk zwischen den Knoten entscheidend für die Gesamt-Performance des Systems.

Ein praxisnaher Messaufbau mit einem einzelnen NVMesh-Target (Betriebsart Disaggregated) mit insgesamt acht Intel P4610-SSDs in einem Lenovo SR630 (Intel Xeon) liefert bis zu 4,89 Mio. IOPS (4k Blocksize, 100% read), was einer Bandbreite von 23 GByte/s entspricht. Die Latenz innerhalb des Systems wird dabei nie höher als 82µs.

Mit der aktuellen Gerätegeneration Lenovo ThinkSystem SR655 in Kombination mit Mellanox ConnectX-6-Netzwerkkarten werden sich diese Werte deutlich verbessern: Die Server auf Basis AMD EPYC 7002-CPU unterstützen PCIe 4.0 und können Daten damit doppelt so schnell transportieren, als Intel-basierte Server mit PCIe 3.0. Auch die ConnectX-6 bietet mit 200 Gbit/s jetzt doppelte Bandbreite gegenüber dem Vorgängermodell.

NVMesh-Betriebsart »Converged« und »Disaggregated« (Grafik: Excelero)

NVMesh-Betriebsart »Converged« und »Disaggregated« (Grafik: Excelero)

Im Aufbau mit vier Lenovo x3650 M5-Servern, ausgestattet mit je zwei Mellanox-ConnectX-4-Karten (davon je 2x 40 Gbit/s genutzt) und zwei Intel P3700 1,6-TByte-NVMe-Drives erreichte das NVMesh über alle acht NVMe-Module eine Bandbreite von zirka 6,6 GByte/s bei durchschnittlich gerade mal 200µs Latenz (4k Blocksize, read/write 70/30). Die Latenz ist dabei weit unterhalb der von RAID-Systemen im SAN. In Einzelmessungen ist die Latenz bei Zugriffen auf entfernte NVMe-Module in der gleichen Größenordnung, als erfolgte der Zugriff auf den lokalen Knoten. Eine ausführliche Beschreibung der Referenzarchitektur, das Messverfahren sowie eine detaillierte Darstellung der Messwerte sind im White-Paper zur Referenzarchitektur nachzulesen.

Lenovo SR655-Server mit AMD EPYC-CPUs (Bild: Lenovo)

Lenovo SR655-Server mit AMD EPYC-CPUs (Bild: Lenovo)

Und warum will man das?

Als Dateiablage für Office-Dokumente wäre ein solches Storage sicherlich übertrieben und zu kostspielig. Insbesondere dort aber, wo viel gerechnet wird, und Zwischenergebnisse schnell auf Platte weg geschrieben werden müssen, ist NVMesh sinnvoll eingesetzt. Ebenso überall dort, wo eine CPU oder GPU in schneller Folge neues Futter braucht, um nicht leer zu laufen. Im HPC wird man NVMe-Storage also vorwiegend als sogenannte Burst-Buffer einsetzen. Lange laufende Berechnungen können so beispielweise Checkpoints schnell auf Platte weg schreiben. Solche Checkpoints bei dieser Art von Berechnungen wichtig, um zum Beispiel einen abgestürzten Rechnungslauf schnell am Checkpoint zu restarten und weiter laufen zu lassen. Berechnungen, die einen Supercomputer mehrere Tage beschäftigen, möchte man nur ungerne bei jedem Fehler wieder von vorne starten müssen.

Im derzeit schnell wachsenden Bereich des Machine-Learning braucht man insbesondere bei der Trainingsphase von neuronalen Netzwerken hohe Bandbreiten für den Datennachschub: Um solche Netze anzutrainieren, werden eine große Menge Musterdaten durch ein solches Netz geschoben und Rückkopplungen ausgewertet. Ein neuronales Netz wird umso besser, je mehr Daten es zum Anlernen hatte. Schneller Speicher kann die Lernphasen von neuronalen Netzen drastisch verkürzen helfen.

Große CAD- oder CAE-Modelle erfordern häufig viel Rechenleistung und gleichzeitig auch schnelles Storage. Hier hilft der Converged-Betrieb von NVMesh, die in einem Rechen-Cluster verfügbare NVMe-Kapazität zu bündeln und allen Rechenknoten als schnelles Storage zur Verfügung zu stellen.

Mit der ThinkSystem DE Series für Einsteiger, der ThinkSystem DM Series für flexible Anforderungen und der NVMesh-Technologie für hochperformantes Storage bietet Lenovo einen vollständigen Storage-Stack aus einer Hand.

Lenovo/Excelero: Hochskalierbarer Shared-Storage für Highend-Anwendungen

Lenovo Global Technology Germany GmbH

Data Center Group

Meitnerstr. 9, 70563 Stuttgart

Tel. 08 00/723 42 06 (Kostenlos, Mo-Fr 08:00 – 16:30)