Speicherarchitekturen im Überblick

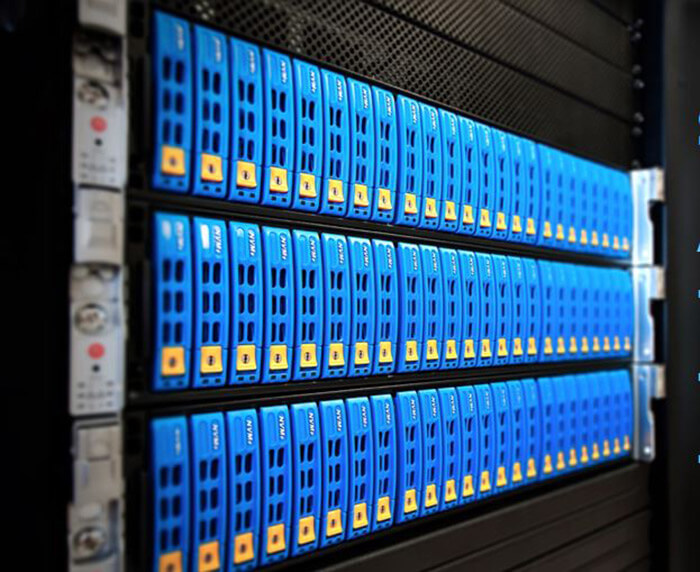

Die Speicherarchitektur bestimmt die Performance, das Management und die Data-Protection eines Rechenzentrums (Foto: Micron).Die heutige Speicherindustrie bietet zahlreiche Möglichkeiten, eine Speicherlandschaft zu gestalten. Dabei muss man unterscheiden, welche rein architektonischen Optionen es gibt und welche Technologien diese unterstützen können. Bei der Wahl stehen Kriterien wie der Datenbestand, das Datenwachstum, regulatorische Vorgaben für Backups und Speicherstandorte sowie geplante Workloads und Datenverschiebungen (Data Lifecycle Management) im Mittelpunkt. Dabei kann die Majorität der Administratoren nicht einfach auf der grünen Wiese starten. Vielmehr müssen sich existierende Architekturen und Technologien optimal einbinden lassen.

Die Speicherarchitektur bestimmt die Performance, das Management und die Data-Protection eines Rechenzentrums (Foto: Micron).Die heutige Speicherindustrie bietet zahlreiche Möglichkeiten, eine Speicherlandschaft zu gestalten. Dabei muss man unterscheiden, welche rein architektonischen Optionen es gibt und welche Technologien diese unterstützen können. Bei der Wahl stehen Kriterien wie der Datenbestand, das Datenwachstum, regulatorische Vorgaben für Backups und Speicherstandorte sowie geplante Workloads und Datenverschiebungen (Data Lifecycle Management) im Mittelpunkt. Dabei kann die Majorität der Administratoren nicht einfach auf der grünen Wiese starten. Vielmehr müssen sich existierende Architekturen und Technologien optimal einbinden lassen.

Bei der Planung und Gestaltung der Storage-Umgebung gilt es zunächst, die zugrundeliegende Architektur zu bestimmen, bevor dann spezifische Technologien in Erwägung gezogen werden.

Die Storage-Struktur der Moderne ist hybrid

Unabhängig für welche Art der Speicherarchitektur sich ein IT-Team entscheidet, es wird in den meisten Fällen keine homogene Umgebung sein, sondern verschiedene Ansätze vereinen. Die derzeit wichtigsten sind dabei wohl aktuell Multi-Cloud und hybride Cloud bzw. hybride Architekturen gepaart mit Multi-Tier-Optionen. Darüber hinaus entscheiden die Skalierbarkeitsanforderungen, welche Art der Storage-Architektur das Unternehmen wählt.

Die Cloud ist aus den IT-Strukturen nicht mehr wegzudenken. Obwohl sicher noch nicht jedes Unternehmen in die Cloud eingestiegen ist, ist dieser Trend nicht aufzuhalten. Gab es zuvor noch Verfechter für entweder die reine Private-Cloud (Cloud-ähnliche Verteilung der Ressourcen am lokalen Standort) oder die Public-Cloud (Nutzung öffentlich zugänglicher Cloud-Dienste), so zeigt die Erfahrung der letzten Jahre, dass sich hybride Strukturen deutlich durchsetzen.

So gibt, es bis auf wenige Ausnahmen, wohl kaum Unternehmen, die alle ihre Daten (oder eben auch produktive Workloads) in die Public-Cloud auslagern. Umgekehrt sind es auch nur wenige Firmen, die Services in der Public-Cloud vollständig auslassen. Die derzeitige Norm sieht eher so aus, dass Unternehmen beispielsweise kritische Daten, die für eine Wiederherstellung und die Business-Continuity essentiell sind, On-Premises bzw. in der lokalen Cloud ablegen.

Je nach Umfang und Nutzwert werden Archivdaten entweder nur lokal oder eben in der Public-Cloud abgelegt, letzteres vor allem dann, wenn viele Anwender problemlos darauf zugreifen müssen. Die altbewährte 3-2-1-Backup-Regel kommt unabhängig davon noch immer zum Tragen und die Cloud macht deren Umsetzung leichter: Drei Kopien werden auf zwei Speichertechnologien gehalten und darüber hinaus eine Kopie ausgelagert. Die Cloud eignet sich dabei sowohl für Schritt zwei als auch drei.

Multi-Tier-Storage in hybriden Umgebungen

Auch Multi-Tier-Storage lässt sich in hybriden Umgebungen umsetzen, natürlich mit den entsprechenden Management-Tools. Hier können Unternehmen zum Beispiel die »heißen«, oft genutzten Speicherdaten, auf schnellen und lokalen Flash-Systemen sichern, werden die Daten älter und »kälter« können sie in einen Cloud-Dienst verlagert werden, beispielsweise in Azure Blob. Sind die Daten nach einem bestimmten Zeitraum nur noch bedingt relevant, müssen aber per Compliance vorgehalten werden, so lassen sie sich auf Band ablegen und diese dann auslagern.

Egal, welche Cloud- oder hybride Architektur Firmen wählen, wichtig ist, dass alle Komponenten miteinander kommunizieren und sich Data-Movement-Prozesse automatisieren lassen. Anwender sollten hier auf die APIs und die jeweiligen Management-Fähigkeiten der Speicher-Software achten. Für die Cloud-Integration ist hier das S3-API ein De-facto-Standard geworden, während der SNIA-Standard CDMI nicht ganz so verbreitet ist.

Die klassischen Architekturen wie DAS, SAN oder NAS sind zwar nicht aus der Mode gekommen, sie kommen überwiegend nur an lokalen Standorten zum Einsatz und können rasch zu ungewollten Silos werden. Hier sollten Administratoren prüfen, inwieweit eine Integration möglich oder eine Veränderung der Architektur notwendig ist.

Technologische Optionen innerhalb der Storage-Architektur

Die Speicherstruktur ist nur ein Baustein einer allumfassenden Storage-Umgebung. Spezifische Technologien innerhalb der Struktur sorgen für die Performance, die Skalierbarkeit und die Verwaltbarkeit der Speicherarchitektur.

Die derzeit wichtigsten technologischen Optionen sind NVMe, NVM-oF, Flash-Speicher, Object-Storage sowie konvergente Systeme und Storage-Class-Memory. Der Trend zu diesen Technologien wird klar getrieben durch die Anforderungen der wachsenden Datenmengen und bestimmter Applikationen, deren Daten gesichert werden müssen – zum Beispiel von Containern oder von Apps virtueller Maschinen.

Mit NVMe gegen den Flaschenhals

Aufgrund der steigenden Datenbestände müssen Informationen heute schneller ins Backup geschrieben werden als zuvor. Der Speicher bildet hier oft einen Flaschenhals. Flash-Speicher kann hier im ersten Schritt Abhilfe schaffen. Dabei steht mit der QLC-Technologie (Quad-Level-Cell) mittlerweile eine Lösung zur Verfügung, die relativ hohe Performance zu einem guten Preis bietet und in All-Flash-Systemen eingesetzt werden kann. Die Lücke zwischen Flash-Laufwerken und Memory-Performance ist noch immer relativ groß, soll nun mit NVMe bzw. NVMe-over-Fabrics (NVMe-oF) geschlossen werden. Es handelt sich hierbei um eine Protokoll-Schnittstelle, die einen schnelleren Datentransfer und niedrige Latenzen zulässt und zudem persistent ist (Non-Volatile Memory Express bzw. Non-Volatile Memory Express over Fabrics). Die Version »-oF« setzt dabei auf bestehende Technologien wie Fibre-Channel und Ethernet und soll die Implementierung erleichtern. Die Technologie ist noch verhältnismäßig neu und noch nicht bei allen Lösungen gleich gut integriert. Admins tun gut daran, die derzeitigen Marktangebote zu vergleichen.

Weg mit den Einschränkungen aus dem HDD-Zeitalter: Per Software werden in NVMe-Speichern Funktionen wie Garbage-Collection, Allocation, I/O-Optimierung oder Fehlerkorrektur direkt innerhalb der SSD ausgeführt (Foto: Pure Storage).

Weg mit den Einschränkungen aus dem HDD-Zeitalter: Per Software werden in NVMe-Speichern Funktionen wie Garbage-Collection, Allocation, I/O-Optimierung oder Fehlerkorrektur direkt innerhalb der SSD ausgeführt (Foto: Pure Storage).

Objekt-Speicher sorgen für hohe Skalierung

Object-Storage ist nicht nur die Basis für jede Cloud-Lösung, sondern auch optimal für jede Form von Scale-Out-Architektur geeignet (Foto: Eurostor/Ambedded).Unternehmen, die viele Daten in der Cloud (Private, Hybrid oder Public) nutzen wollen und zudem eine hohe Skalierbarkeit benötigen, sollten sich dem Object-Storage zuwenden. Diese Art der Sicherung erlaubt eine Indexierung über umfassende Metadaten, was eine gute Verwaltbarkeit und Skalierbarkeit garantieren soll. Bislang kamen die meist SDS-Lösungen hier im Bereich der Performance schnell an ihre Grenzen, mit dem Aufkommen von NVMe könnte sich dies schnell ändern.

Object-Storage ist nicht nur die Basis für jede Cloud-Lösung, sondern auch optimal für jede Form von Scale-Out-Architektur geeignet (Foto: Eurostor/Ambedded).Unternehmen, die viele Daten in der Cloud (Private, Hybrid oder Public) nutzen wollen und zudem eine hohe Skalierbarkeit benötigen, sollten sich dem Object-Storage zuwenden. Diese Art der Sicherung erlaubt eine Indexierung über umfassende Metadaten, was eine gute Verwaltbarkeit und Skalierbarkeit garantieren soll. Bislang kamen die meist SDS-Lösungen hier im Bereich der Performance schnell an ihre Grenzen, mit dem Aufkommen von NVMe könnte sich dies schnell ändern.

SCM rückt Flash näher in Richtung RAM-Leistung

Eine weitere leistungsstarke Technologie ist Storage-Class-Memory (SCM), die ebenso näher an die Leistungen von RAM reichen soll. Zu den technologischen Optionen zählen derzeit:

- 3D XPoint (Intel and Micron)

- Intel Memory Drive Technology (DRAM + Optane + ScaleMP)

- ME 200 NAND SSD + ScaleMP SW MMU (Western Digital)

- Z-SSD (Samsung)

- MRAM, PCM, NRAM and STT-RAM

Intelligente SSDs: Enterprise-Modelle müssen nicht mehr ausgetauscht werden, weil einer von mehreren hundert NAND-Chips einen Fehler aufweist. Dieser wird intern erkannt und ausgegliedert (Foto: Samsung).Diese Lösungen können hardware- wie softwarebasiert sein. Auch hier steht die Technologie noch am Anfang ihrer Marktkarriere und ist mit Optane und 3D XPoint am weitesten entwickelt. Admins müssen bei Interesse Leistungskurven, Support, Integrationsoptionen und Preispunkt genau vergleichen.

Intelligente SSDs: Enterprise-Modelle müssen nicht mehr ausgetauscht werden, weil einer von mehreren hundert NAND-Chips einen Fehler aufweist. Dieser wird intern erkannt und ausgegliedert (Foto: Samsung).Diese Lösungen können hardware- wie softwarebasiert sein. Auch hier steht die Technologie noch am Anfang ihrer Marktkarriere und ist mit Optane und 3D XPoint am weitesten entwickelt. Admins müssen bei Interesse Leistungskurven, Support, Integrationsoptionen und Preispunkt genau vergleichen.

Darüber hinaus lassen sich konvergente Systeme für die Speicherarchitektur einbinden, die aus verschiedenen Komponenten bestehen können (Storage+Compute, Storage+Compute+Netzwerk, Storage+Compute+Netzwerk+Software) und modular skalierbar sind. Diese Systeme eignen sich vor allem, wenn die Integration relativ einfach umsetzbar sein soll und eine rasche und individuelle Skalierung nach dem Scale-out-Prinzip gefragt ist.

Prädiktive Analysen und Monitoring für Storage-Optimierung

Nicht zuletzt ist auch die Management-Software entscheidend für die Storage-Architektur. Dabei vernachlässigen wir an dieser Stelle einmal die klassische Backup-Software, die ohne Fragen stets die Anforderungen nach RPO, RTO sowie Automatisierung und Recovery erfüllen sollte. Vielmehr gewinnen Software-Lösungen für prädiktive Analysen und tiefgreifendes Monitoring an Bedeutung. Mit einer Überwachung verschiedener Storage-Komponenten und Anwendungen lassen sich dann vorausschauend Rückschlüsse ziehen, auf deren Basis man Engpässe, drohende Ausfälle und notwendige Wartungen und Erweiterungen besser planen und umsetzen kann, ohne Systemausfälle oder Datenverluste befürchten zu müssen.

- Mehr zu Strategien, Trends und Lösungen in den Bereichen Datenspeicherung und Storage-Infrastrukturen im

Storage-Magazin »Einkaufsführer Storage 2020« - eMagazine: Cloud & Managed-Services

- eMagazine: Storage für den Mittelstand