Mythen rund um Hyper-Konvergenz

Das Spannende an hyper-konvergenten Lösungen ist vor allem die Möglichkeit, Vorhandenes intelligent zusammenzusetzen und effektiv anzuwenden. Mit den Zielen Vereinfachung und Kostenreduktion werden dabei auch kontraproduktive Ansätze propagiert, die mittelfristig wirtschaftliche Risiken bergen und sich dennoch diffus im Gerede rund um den »Hyper Converged«-Rummel halten. Ein guter Grund, mit einigen Irrtümern aufzuräumen.

von Robert Thurnhofer, Datacore

Mythos I: Hyper-Converged ist Hardware-getrieben

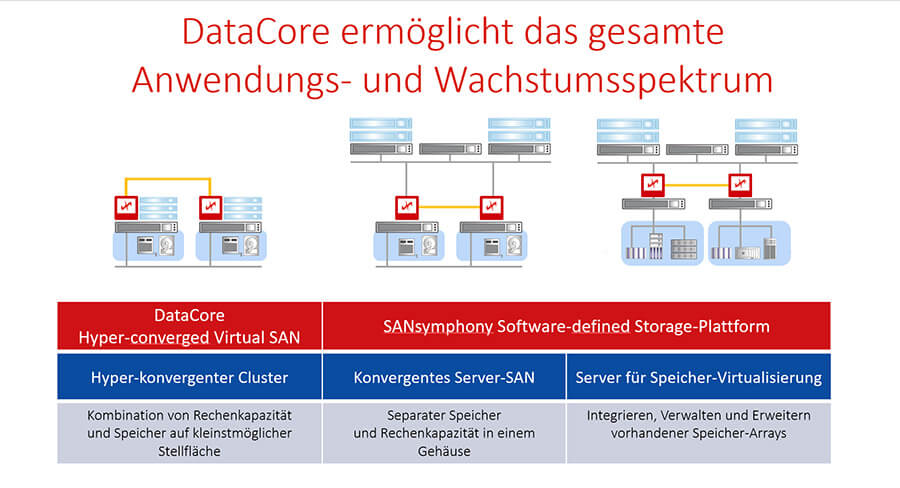

Datacore deckt Software-basiert das komplette Anwendungsspektrum moderner Speicherarchitekturen ab.Die Bündelung der Hardware-Ressourcen in einem Gerät ist eine kompakte und effiziente Rechenzentrumslösung, die besonders für Abteilungen, Remote-Standorte oder bestimmte Systemumgebungen geeignet ist. Diese Reduktion und Zentralisierung geht einher mit bekannten Vorteilen: weniger Hardware-Investition, übersichtliches Geräte-Management, geringere Rechenzentrumsfläche, vereinfachte Wartung usw. Das Konzept einer »Infrastruktur in a Box« führt jedoch nicht selten zu dem Missverständnis, dass hyper-konvergente Lösungen »Geräte« aus der Hand eines Anbieters sein müssten.

Datacore deckt Software-basiert das komplette Anwendungsspektrum moderner Speicherarchitekturen ab.Die Bündelung der Hardware-Ressourcen in einem Gerät ist eine kompakte und effiziente Rechenzentrumslösung, die besonders für Abteilungen, Remote-Standorte oder bestimmte Systemumgebungen geeignet ist. Diese Reduktion und Zentralisierung geht einher mit bekannten Vorteilen: weniger Hardware-Investition, übersichtliches Geräte-Management, geringere Rechenzentrumsfläche, vereinfachte Wartung usw. Das Konzept einer »Infrastruktur in a Box« führt jedoch nicht selten zu dem Missverständnis, dass hyper-konvergente Lösungen »Geräte« aus der Hand eines Anbieters sein müssten.

Nach Definition von Gartner integrieren Hyper-Converged-Systeme die Hardware für Computing, Netzwerk und Storage und machen damit ein herkömmliches Storage-Area-Network obsolet. Entscheidend dafür, so die Marktanalysten, ist, dass die Storage-Management-Funktionen (Backup, Recovery, Replikation, Deduplikation, Komprimierung) aus der Hardware gelöst und auf einer übergeordneten Software-Ebene angesiedelt werden. Diese Definition entspricht der Definition von Software-defined Storage (SDS), wie sie unter anderem von

DataCore in der Praxis umsetzt wird. Im Zusammenspiel der Virtualisierungs-Software für Server und Storage liegt der Schlüssel für effektive Hyper-Konvergenz.

Mythos II: Geschlossene Systeme aus einer Hand

Abgeleitet vom Hardware-orientierten Box-Denken, das Vereinfachung suggeriert, werden hyper-konvergente Lösungen oftmals als geschlossene, schlüsselfertige Appliances verstanden und vermarktet. Doch meist wird der Schlüssel nicht mitgeliefert. Technisch wie wirtschaftlich macht das wenig Sinn, werden doch die Vorteile der Virtualisierung (Software), für die diese Lösungen konzipiert sind und zu deren Errungenschaften Hardwareunabhängigkeit sowie die Nutzung von austauschbaren Standardkomponenten gehören, ad absurdum geführt.

Richtig verstandene Hyperkonvergenz sollte deshalb eine Fortführung der Entwicklung von proprietärer Hardware hin zu einer flexiblen Auswahl an Server-, Netzwerk- und Storage-Komponenten sein. Hyperkonvergenz ist demnach nicht zwangsläufig an eine Hardware-Appliance oder -hersteller gebunden. Aufbauend auf Software-definierten Dateninfrastrukturen können »Silo«-Lösungen vermieden werden.

Mythos III: Limits bei der Skalierung

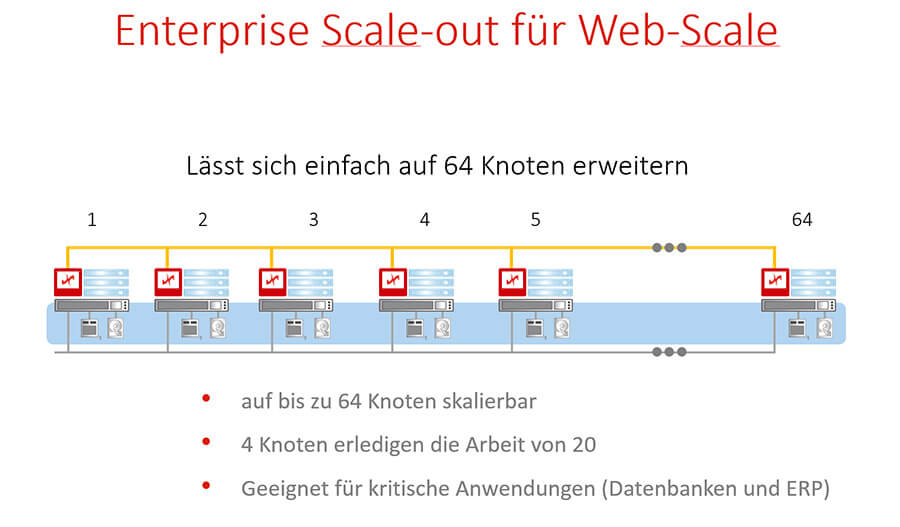

Das Datacore Virtual SAN lässt sich auf bis zu 64 Knoten und damit Enterprise-Level skalieren.Genau diese Silo-Lösungen führen aufgrund der Probleme bei der Skalierung solcher Ansätze zwangläufig in eine Sackgasse. Unternehmen, die die Einführung hyper-konvergenter Lösungen erwägen, sollten sich deshalb von Beginn an mit den Skalierungskonzepten der jeweiligen Anbieter auseinandersetzen.

Das Datacore Virtual SAN lässt sich auf bis zu 64 Knoten und damit Enterprise-Level skalieren.Genau diese Silo-Lösungen führen aufgrund der Probleme bei der Skalierung solcher Ansätze zwangläufig in eine Sackgasse. Unternehmen, die die Einführung hyper-konvergenter Lösungen erwägen, sollten sich deshalb von Beginn an mit den Skalierungskonzepten der jeweiligen Anbieter auseinandersetzen.

Ein hyper-konvergenter Knoten kann mit Server- und Storage-Hardware und der notwendigen Software-Lizenzen leicht Kosten um die 20.000 Euro verursachen. In manchen Fällen werden drei, in anderen nur zwei Knoten benötigt, um eine elementare, aber unerlässliche Hochverfügbarkeit herzustellen. Dies macht für die viel zitierten kleinen Unternehmen oder Abteilungen bereits einen erheblichen Unterschied bei der Anfangsinvestition. Mittlere und große Unternehmen mit verteilten Standorten und Plattformen müssen überlegen, ob eine hyper-konvergente Architektur vorhandene Infrastrukturen und Plattformen integrieren kann und ob sie bei Erweiterungen auf Jahre hinaus jeweils auf identische Boxen aus der Hand eines Herstellers setzen wollen.

Funktioniert die HC-Lösung also mit heterogener Hardware? Werden diverse Hypervisor-Plattformen unterstützt? Können auch nicht-virtualisierte Applikationen wie Echtzeit-Datenbanken integriert werden? Auf Basis einer Software-definierten Infrastruktur können diese Fragen mit »Ja« beantwortet werden und die (Selbst-)Beschränkungen bei der Skalierung vermieden werden. Weitere Knoten (Scale-out) können ebenso flexibel gewählt werden wie Komponenten zur Optimierung der vorhandenen (Scale-up).

Mythos IV: Hyper-Converged baut auf Flash-Integration

Richtig ist: Neben der Kapazitätsverwaltung sollte eine hyper-konvergente Lösung auch ein effizientes, das heißt, unabhängiges und flexibles Performance-Management ermöglichen. Flash-Speicher ist dabei nur eine der möglichen Komponenten, die in Betracht zu ziehen sind. Hyper-konvergente Ansätze sind mit ein Grund, warum sich Flash im Rechenzentrum etabliert und die Preise drückt. Damit einher geht aber auch die rasante Weiterentwicklung und Diversifizierung des Marktes, die fest verbaute SSDs nicht erstrebenswert machen.

Hyperkonvergenz auf Basis Software-definierter Architekturen lässt hier nicht nur Spielraum für die Wahl und Zusammenstellung der Komponenten, sie macht sie teilweise sogar obsolet. Speicherseitig kann die Performance einer hyper-konvergenten Infrastruktur auch anderweitig skaliert werden. Die meisten hyper-konvergenten Systeme benötigen Flash für das Caching der I/O-Verarbeitung. Bei ausgereiften Software-definierten Lösungen wie etwa dem Virtual SAN von Datacore bleibt Flash dagegen eine Option für Tier-1-Speicheranforderungen. Für das Caching dagegen wird der performantere DRAM-Arbeitsspeicher genutzt, der in einer virtualisierten Umgebung in der Regel ohnehin üppig konzipiert ist.

Im Vergleich zu Flash ist DRAM um ein Vielfaches schneller, insbesondere bei Schreibprozessen. Das Datacore Virtual SAN nutzt diese Server-Ressource für intelligente Caching-Algorithmen, um Lese- und Schreibzugriffe auf den darunterliegenden Storage zu beschleunigen. Da die Speicher-Virtualisierung auf Datenblockebene erfolgt, können diese zudem zu einer optimalen Schreibgröße gebündelt werden, was die Zahl der Schreibprozesse in den Primärspeicher mindert und bei SSD zu einer höheren Haltbarkeit führt. Datacore nennt diese Eigenentwicklung Random Write Accelerator.

Eine weitere spektakuläre Neuerung bei der hyper-konvergenten Performance ist die Einführung der Parallel I/O-Technologie mit der Virtual-SAN-Software des genannten Herstellers. Die Technologie ermöglicht erstmals eine adaptive, parallele I/O-Verarbeitung in Mehrkernprozessoren. Vor allem lastenintensive Datenverarbeitungsprozesse bei OLTP-, Echtzeitanalyse-, Business Intelligence- bzw. Data Warehouse-Systemen sowie SQL-, SAP- und Oracle-Datenbanken profitieren von einer Performance-Vervielfachung. Gleichzeitig können virtuelle Maschinen auf hyper-konvergenten Systemen dichter gepackt und damit Einsparpotenziale auf bislang unerreichtem Niveau erzielt werden – ganz ohne SSD oder Flash.

Mythos V: Hyper-Converged ist das SAN zweiter Klasse

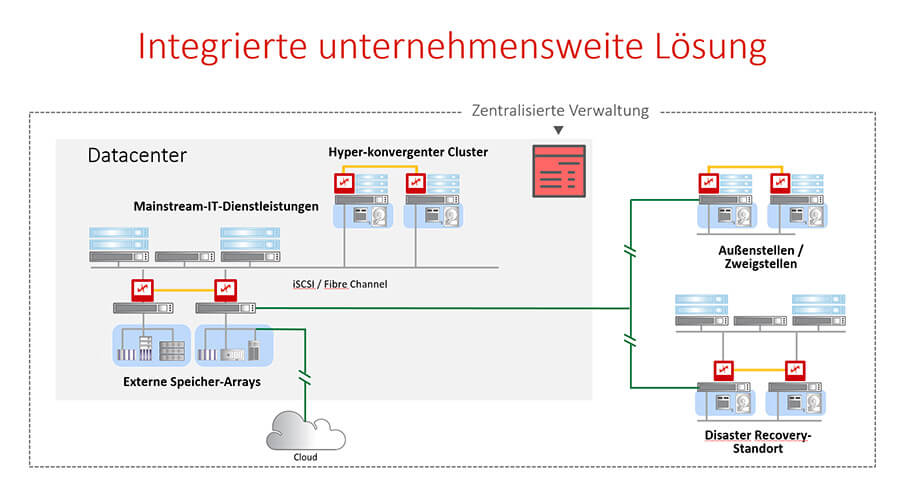

Datacores SDS-Plattform integriert hyper-konvergente, konvergente und herkömmliche SAN-Infrastrukturen.Das Beispiel zeigt auch, dass hyper-konvergente Lösungen nicht ohne tief ausgereifte Storage-Technologie aus dem Software-defined-Storage-Umfeld auskommen. Der Einsatz von SSDs basiert auf einem ausgeklügelten, block-basierten Auto-Tiering. Damit migriert die Storage-Software Datenblöcke von langsamerer auf schnellere Hardware wie SSD oder Flash automatisch. So können Performance-Steigerungen von bis zu 500 Prozent bei unternehmenskritischen Applikationen wie Datenbanken erzielt werden.

Datacores SDS-Plattform integriert hyper-konvergente, konvergente und herkömmliche SAN-Infrastrukturen.Das Beispiel zeigt auch, dass hyper-konvergente Lösungen nicht ohne tief ausgereifte Storage-Technologie aus dem Software-defined-Storage-Umfeld auskommen. Der Einsatz von SSDs basiert auf einem ausgeklügelten, block-basierten Auto-Tiering. Damit migriert die Storage-Software Datenblöcke von langsamerer auf schnellere Hardware wie SSD oder Flash automatisch. So können Performance-Steigerungen von bis zu 500 Prozent bei unternehmenskritischen Applikationen wie Datenbanken erzielt werden.

Darüber hinaus ist ein gewisses Maß an Ausfallsicherheit noch nicht gleichbedeutend mit einer im SAN-Umfeld gereiften Hochverfügbarkeitstechnologie, mit hardware- und plattformübergreifenden Automatismen für die Datensicherung mit Failover und Failback. Erst dann kann man von einer transparenten Hochverfügbarkeit sprechen. Darüber hinaus sollte die Virtual SAN-Plattform als Teil der hyperkonvergenten Lösungen das gesamte Feature-Set einer SAN-Software aufbieten können: elastische Speicherbereitstellung für alle Plattformen, Migrationsunterstützung (»in and out«), Snapshots, Thin-Provisioning, Multi-Site-Replikation mit Deduplizierung und Komprimierung, CDP, vernünftiges Monitoring und Analyse der Speicherauslastung und vieles mehr. Die wenigsten hyper-konvergenten Anbieter verfügen jedoch über diese SAN-Expertise.

Zu guter Letzt steht wieder die Silo-Frage: Was passiert, wenn die wachsenden Anforderungen technisch oder wirtschaftlich nicht mehr mit herkömmlichen Hyper-Converged-Lösungen abzubilden sind? Auch dabei weist die Software-definierte Dateninfrastruktur den zukunftssicheren Weg: Datacore ist der einzige Hersteller, der hyper-konvergenten Speicher mit physischen SANs kombinieren und in einem Parallel-Betrieb effektiv zusammenführen kann.

Die eigentliche Frage ist deshalb nicht, ob Hyper-Converged, Converged oder herkömmliches SAN. Die Frage ist vielmehr, wie Unternehmen heutige RZ-Anforderungen umsetzen können und sich dabei gleichzeitig flexibel für die Zukunft aufstellen können. Der Schlüssel hierfür ist und bleibt die Software.

Datacore Software GmbH

Bahnhofstraße 18, D-85774 Unterföhring

Tel: +49 (0)89 - 46 13 57 00, Fax: +49 (0)89 - 461 35 70 90

E-Mail: infoGermany@datacore.com