Mit Service-Level-Agreements der Qualität auf der Spur

Beim Cloud-Computing sollten die Anwender umdenken: Der Dienstelieferant steht in der Pflicht, die Qualität des Dienstes nachzuweisen. Doch das genügt nicht, denn auch beim Anwender muss ein Überprüfen der vereinbarten Service-Level-Agreements (SLAs) erfolgen. Dazu eignen sich aktive Probes, die zudem noch über eine Simulation vorhersagen können, wie sich Änderungen in der Infrastruktur auswirken werden.

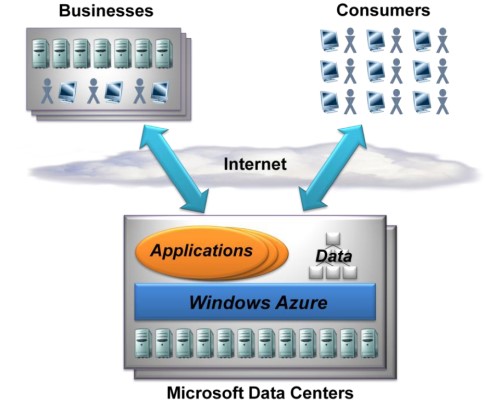

Wenn es heute in einem Unternehmen um die Frage geht, wie sich mit Hilfe von Ansätzen wie Cloud-Computing eine Reduzierung der Investitionskosten erreichen lässt, stößt dieser Ansatz auf großes Interesse. Allerdings hegen viele Nutzer die Befürchtung, dass sie nicht den Service bekommen, den sie benötigen. Vor allem wenn es darum geht, unternehmenskritische Anwendungen auszulagern, spielt die Qualität der Deinstleistung die dominierende Rolle. Die heutzutage übliche Konzentration auf die Verfügbarkeit als alleiniges Qualitätskriterium reicht nicht mehr aus.

»Der Geschäftserfolg steht bei Unternehmen im Vordergrund und da ist eine bloße Zusage, dass die Applikation verfügbar ist, definitiv zu wenig«, bringt es Lydia Krowka auf den Punkt. Die Geschäftsführerin der Datakom nennt andere wichtige Punkte: »Es kommt zum Beispiel auch auf die Schnelligkeit des Zugriffs an. Beim Web-Hosting oder einem Online-Shop etwa haben lange Antwortzeiten eine eindeutige Konsequenz: Die Interessenten gehen zum Mitbewerb und werden dort zu Kunden.«

Garantieaussagen reichen nicht aus

Allerdings reicht die Garantie des Diensteanbieters nicht. Es muss gemessen und dokumentiert werden, dass die gelieferte Qualität nicht unter den geforderten und garantierten Mindestwerten liegt. »Erst wenn ein Unternehmen die geeigneten Tools einführt und damit die Spezifikationen des gelieferten Dienstes genau und vor allem End-to-End überwacht, hat es die Sicherheit, dass die Leistungen stimmen. Allerdings muss man dann auch passende vertragliche Vorkehrungen treffen, wenn die Qualität den Anforderungen nicht entspricht«, gibt Karl Schuiki vor, technischer Leiter bei Datakom. Hier stellen sich Fragen wie:

Was passiert, wenn SLA unterschritten werden, welche Reaktionen sind dann erforderlich, in welchen Zeitrahmen muss das Problem bereinigt werden, welche Vertragsstrafen sind vorzusehen? »Diese Parameter lassen sich nicht verallgemeinern. Das ist von Unternehmen zu Unternehmen und oftmals sogar von Abteilung zu Abteilung und von Applikation zu Applikation verschieden«, erläutert Krowka. Und manche Unternehmen sind sich oftmals gar nicht im Klaren, was sie genau benötigen.

Daher empfiehlt sich in vielen Fällen der Einsatz von Dienstleistern bei einem Umstieg des IT-Bezugsmodells. Für eine aussagekräftige Analyse der Anforderung gehören die beteiligten Fachabteilungen mit ins Boot. »Sie müssen definieren, was sie haben wollen«, gibt Schuiki vor. Erst dann ist die IT-Abteilung gefordert, um daraus die Werte für die SLAs abzuleiten. Hierbei kommt es dann noch zu einem weiteren Abstimmungsbedarf, wenn etwa die für den Betrieb der Anwendungen zuständigen IT-Mitarbeiter sich mit den Verantwortlichen für Server, Speicher und Netzwerk absprechen müssen.

Wird ein externer Dienstleister in derartige Projekte einbezogen, empfiehlt sich eine Vorgehensweise, bei der zunächst der Ist-Zustand vermessen wird. Anhand dieser Ergebnisse wird dann in einem »interdisziplinären Team« der Stand der Dinge ermittelt. Eine derartige Analyse muss unbedingt auf der Applikationsebene ansetzen. »Angaben über die IP-Ebene sagen nichts mehr aus, das ist schon lange kein Thema mehr« gesteht Schuiki ein. »Nur wenn es anfängt zu haken, kommt der Drill-Down ins Spiel, dann wird es immer weiter in den Ebenen runtergehen um in die Fehlersuche einzusteigen.« Technologisch gesehen haben moderne Analysatoren mit dem Verstehen der Applikationen keine Probleme. Sie liefern alle Infos, was eine Applikation so alles anstellt. Diese Tools sind in der Lage, Applikationen auszuwerten.

Permanente Überwachung beim Bezieher des Dienstes

Ist die Analyse abgeschlossen und sind die Vorgaben in Form von SLAs mit dem Dienstleister definiert, sollten Unternehmen diese Dienste permanent überwachen. »Je kritischer ein Dienst für den Unternehmenserfolg ist, umso dringlicher gilt es regelmäßig und kontinuierlich nachzuweisen, dass die SLAs eingehalten werden«, gibt Krowka vor. Dabei ist aber der Diensteanbieter in der Nachweispflicht: »Jeder Dienstnehmer bezahlt für die vereinbarte Qualität. Somit kann er auch verlangen, dass der Lieferant nachweist, dass seine Dienstleistung in der vereinbarten Qualität ankommt.

Ein weiterer Faktor kommt in die Gleichung, wenn man die Sichtweise »End-to-End« einführt. »Wenn der Service beim Provider die Server in der vorgeschriebenen Qualität verlässt, bedeutet das noch nicht, dass diese Qualität auch beim Bezieher des Dienstes ankommt«, gibt Schuiki zu bedenken. »In der Regel liegen da viele Hops dazwischen und es geht über verschiedene Leitungen, die unterschiedlichen Carriern gehören.« Doch das Einbeziehen der eigentlichen Wolke bieten heute noch die wenigsten Carrier an. Viele sind froh, dass sie das noch nicht machen müssen.

Auch auf Grund dieser Problematik sieht Krowka den Bedarf, direkt beim Dienstebezieher die Qualität zu überwachen. Dazu gebe es die Möglichkeit, »passive Probes« einzusetzen, die zum Beispiel messen, wie eine Applikation wie etwa das SAP-System von den Antwortzeiten her läuft, und die das dann dokumentieren.

Aktive Probes ermitteln die Qualität von Diensten

Erfolgversprechender erweise sich dagegen der aktive Ansatz: In einem Netz beim Kunden werden virtuelle Clients verteilt – wie etwa Linux-PCs. Die führen dann Transaktionen aus, wie sie auch ein Endanwender machen würde. Anschließend werden diese Transaktionen vermessen und zugleich mitgeschrieben, wie gut beziehungsweise schlecht der Qualität einer Applikation ist.

Eine derartige Vorgehensweise sei immer dann angeraten, wenn ein neuer Dienst auf eine bestehende Infrastruktur kommt: »In einem derartigen Fall ist das ein Muss«, so Schuiki. Dieser Ansatz rangiert unter der Bezeichnung »Predeployment«. »Das hat sich in den letzten Jahren etabliert – und kam vor allem durch Echtzeitanwendungen wie etwa VOIP zum Einsatz.«

Wenn es um den Aufwand geht, um das Einhalten von SLAs zu überwachen, geben die gewünschten Applikationen und Infrastrukturen die Größenordnung vor. »Verwendet ein Unternehmen eine zentrale Einspeisestelle für den Service, kann die hier abgelegte Messinstanz alles mitbekommen und auch alles Gelieferte bewerten. Das ist die günstigste Variante«, so Krowka. Zudem sei der aktive Ansatz aus Anwendersicht günstiger. Es handelt sich bei den Tools in der Regel um Software-Produkte, die auf Standard-Hardware – wie etwa Linux- oder Windows-PCs – laufen, um kontinuierliche Stichproben zu nehmen.

Möchte ein Unternehmen zum Beispiel einen Exchange Server mit 500 Postfächern extern hosten lassen, dann reicht ein PC, der die Mails für die 500 User abruft. Das System misst Download- und Connect-Zeiten. Eine derartige Lösung liegt deutlich unter 10.000 Euro. Doch diese Lösung kann dann aber mehr als nur den Mail-Service überwachen. Meist sind bei den Probes weitere grundlegende Applikationen bereits enthalten.

Damit die IT-Infrastruktur dynamisch bleibt, empfiehlt Krowka eine möglichst flexible Vertragsgestaltung: »Man sollte unbedingt vorsehen, wie das Vertragsverhältnis aussieht, wenn ein Erweitern, Verändern oder gar Aussteigen aus dem Service nötig wird. Technische Aspekte sind für den Anwender eher hinten angestellt. Bei den SLA geht es meist um organisatorische Themen, um Prozessbeschreibung und um die Definitionen. Die Technik ist zwar ein Teil davon, doch wesentlich wichtiger sind die anderen Aspekte.«