Komprise Intelligent Data Management verwaltet kalte Daten

Rund 75 Prozent aller gespeicherten Daten sind »kalt«, sie liegen auf Sekundär-Storage und werden selten benötigt. Gleichzeitig ist die Verwaltung dieser, immer weiter anschwellenden, Datenmassen zeitaufwändig, fehleranfällig und teuer. Schon allein deshalb, weil oft viele Kopien derselben Datei vorgehalten werden, obwohl nur eine oder zwei nötig wären. Abhilfe soll die Datenverwaltungs-Software Komprise Intelligent Data Management schaffen, aktuell in der Version 2.9. Entwickelt wurde die software-basierte Lösung vom US-Hersteller Komprise, gegründet 2014. Sie soll mit vielen Pferdefüßen des Datenmanagements aufräumen und gleichzeitig, was die Speichertechnologien angeht, agnostisch sein.

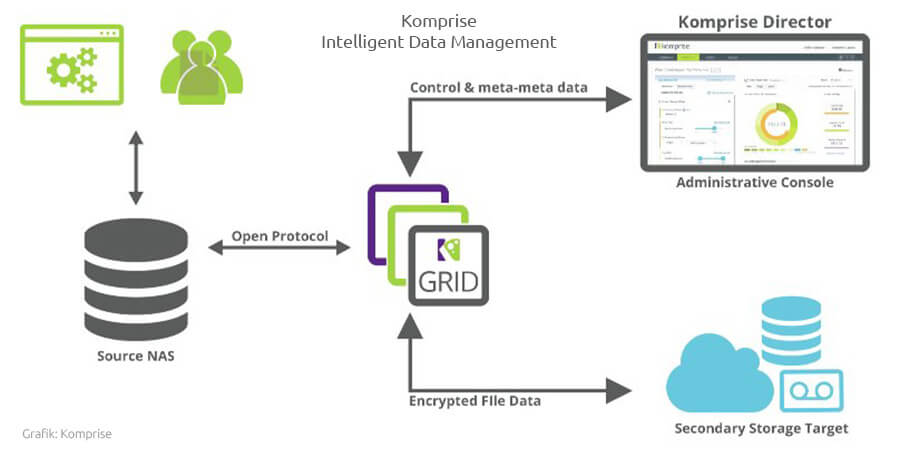

Die Idee: Man unterlege alle Speichersysteme, ob On-Premises oder in der Cloud, ob mit SSD oder Harddisks bestückt, mit einer Software-Schicht, die die wichtigsten Speicherprotokolle – namentlich NFS, SMB/CIFS und S3 respektive REST – verarbeiten sowie die Metadaten der gespeicherten Daten lesen und analysieren kann. Diese Analysen ermitteln unter anderem, welche Daten wie oft genutzt werden und wie schnell die Speicherkapazität wächst.

Laut Komprise dauert es nach der initialen Installation und der logischen Verbindung mit den vorhandenen Storage-Systemen nur 15 Minuten, bis die Software die aktuelle Datenverteilung und ihre Kosten analysiert hat. Anwender können über die Administrator-Benutzerschnittstelle, den Komprise Director, in Web-Optik ihre Ziele, beispielsweise Kostengrenzen, Redundanzen und anderes definieren.

Aufbau von Komprise Intelligent Data Management

Aufbau von Komprise Intelligent Data Management

Regelbasierte Kostensenkung bei Sekundär-Storage

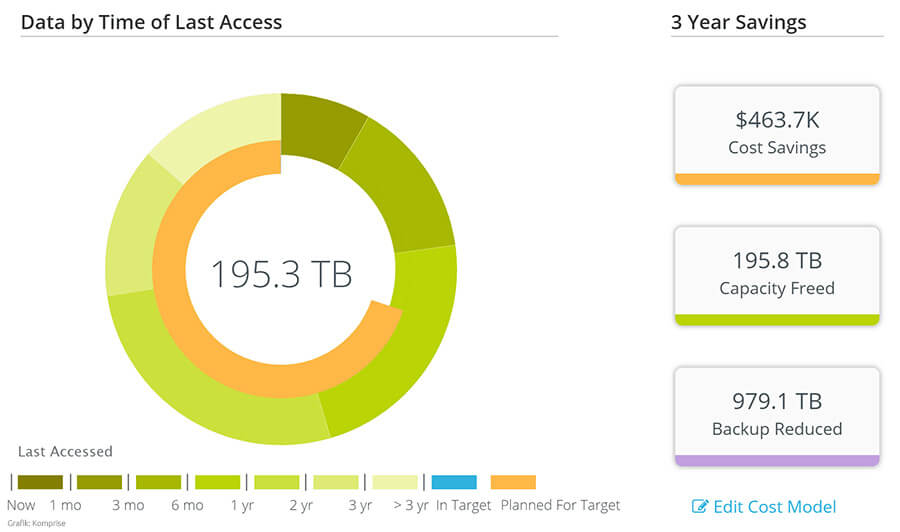

Einsparungsbeispiel durch Datenmanagement (Grafik: Komprise)Die Komprise-Lösung prüft bei der Analyse der Metadaten, wie sich das definierte Regelwerk real auf Kosten und Datenvolumen auswirken würde und ermittelt sogar den ROI für die jeweiligen Zieldefinitionen. Gibt der Anwender grünes Licht, legt die Software die Daten selbsttätig auf die am besten geeigneten Speicherschichten und beseitigt egal, ob die sich nun vor Ort oder in der Cloud befinden.

Einsparungsbeispiel durch Datenmanagement (Grafik: Komprise)Die Komprise-Lösung prüft bei der Analyse der Metadaten, wie sich das definierte Regelwerk real auf Kosten und Datenvolumen auswirken würde und ermittelt sogar den ROI für die jeweiligen Zieldefinitionen. Gibt der Anwender grünes Licht, legt die Software die Daten selbsttätig auf die am besten geeigneten Speicherschichten und beseitigt egal, ob die sich nun vor Ort oder in der Cloud befinden.

Komprise baut einen einheitlichen Namensraum über alle Speichersysteme hinweg. Gleichzeitig bleibt es möglich, die Daten, egal, wo sie liegen, mit den für die Source respektive die an sie gebundenen Applikationen üblichen Methoden, Namen und Syntaxelementen anzusprechen, selbst wenn der entsprechende File auf einen anderen Tier oder ein anderes Medium verlagert wurde. Dies gilt auch für die Public Cloud. Zugriffs- und andere Berechtigungsstrukturen werden auch beibehalten, wenn die Daten migriert wurden.

Die Preise für Komprise Intelligent Data Management 2.9 hängen von einigen Faktoren ab und werden in der Praxis meist als Projektpreis verrechnet. Dem Hamburger Systemintegrator Itiso zufolge, müssten für 100 TByte lizenzierte Primär-Storage rund 15.000 Euro kalkuliert werden.

Um das Einsparungspotential auszuloten bietet Komprise auf seiner Webseite einen TCO-Kalkulator an.

Komprise NAS Migration 1.0: NAS-Migration leicht gemacht

Auf verschobene Files kann vom Target aus aber auch als Objekt zugegriffen werden. Das ist wichtig, wenn Daten beispielsweise von einem unternehmensinternen Filer auf S3-Storage in der Public-Cloud verlagert werden, dort aber wie zuvor zugreifbar sein sollen.

Migrationen finden automatisch statt und ohne wichtigere Anwendungen zu behindern. Für letzteres sorgt die automatische Begrenzung der für die Applikation genutzten Bandbreite, sobald Wichtigeres auf dem Netz zu tun ist. Weil diese Funktion so gern genutzt wird, hat Komprise sie seit März als selbständiges Produkt, Komprise NAS Migration 1.0, verfügbar gemacht. Wer das Hauptprodukt nutzt, bekommt die Migrationsfunktion weiter kostenlos. Andere Kunden müssen 60 US-Dollar/TByte berappen. Eine Version, die ins Eigentum des Kunden übergeht, ist ebenfalls verfügbar.

Nahtlose Skalierung der Metadaten-Engine

Die Metadaten-Analyse besorgt der sogenannte Observer, eine Software, die auf eine virtuelle Maschine gelagert wird. Mehrere Observer-Instanzen, die jeweils eine VM als Basis benötigen, sind möglich und je nach Datenmenge auch erforderlich. Die virtuelle Maschine, auf der der Observer seine Arbeit tut, muss acht Cores haben und mindestens 16 GByte Cache, in dem später Metadaten landen. Es gibt keinen Master-Observer, weshalb das System laut Komprise nahtlos skaliert.

Auf dem Speichersystem müssen keine Agenten installiert werden, auch statische Stubs werden nicht benötigt. Komprise referenziert die Files mit dynamischen Links, wie dies bei Filern üblich ist. Welche Speicher-Hardware benutzt wird, ist zunächst einmal egal. Weder die Leistung der Storage noch die des Netzwerks wird beeinträchtigt.

Aktuell hat Komprise seine Lösung um Funktionen zur Generierung userspezifischer Regeln der Datenarchivierung erweitert. Damit können Anwender den geregelten Zugriff auf Ressourcen noch besser steuern als bisher.

Finanzierungsrunde unterstützt Komprise-Expansion

Im Februar des laufenden Jahres wurde die C-Serien-Finanzierungsrunde abgeschlossen. Komprise konnte 24 Millionen Dollar einsammeln, unter anderem von Western Digital Capital. Damit soll die globale Expansion weiter vorangetrieben werden. Damit erreicht die Gesamtfinanzierung das Volumen von 42 Millionen Dollar.

Wie die nächsten Expansionsschritte aussehen ist noch nicht klar. In Europa gibt es derzeit eine Zentrale in London, die unter der Leitung des europäischen Vertriebschefs Andy Hill steht. In Deutschland wurden bislang einige Vertriebspartner etabliert.

Datenmanagement für wichtige Sekundärdaten

Dass die Technologie von Komprise bei Anwendern einen Nerv trifft, zeigt nicht nur die Wachstumsrate des Umsatzes von 200 Prozent im Jahr 2018 im Quartalsvergleich zum Vorjahr. Die Kundenzahl hat sich eigenen Angaben zufolge im selben Zeitraum gar versechsfacht, auch in EMEA gibt es bereits eine Reihe von Kunden. In Deutschland nutzt beispielsweise die Film- und Fernsehproduktionsgesellschaft Studio Hamburg die Datenmanagement-Software. Geplant und umgesetzt hat das Projekt der Hamburger Systemintegrator Itiso.

Besonders attraktiv ist die Lösung naturgemäß für solche Branchen und Anwender, bei denen Sekundärdaten in riesigen Mengen eine wichtige Rolle spielen: der öffentliche Sektor, der seine Daten lange aufbewahrt und nutzt, der gesamte Gesundheitsbereich, wo Patientendokumentationen teilweise 30 Jahr aufgehoben werden müssen, aber auch daten- und forschungsintensive Bereiche wie die Genomik.

Viele Kooperationspartner von AWS bis Wasabi

Auch die Liste der Kooperationspartner kann sich sehen lassen. So ist die Lösung bei allen drei Hyperscalern erhältlich. IBM vertreibt trotz seines gigantischen Software-Portfolios Komprise als OEM-Produkt. Auch mit dem innovativen Cloud-Storage-Anbieter Wasabi arbeitet Komprise zusammen. Er hat eine Lösung zur Cloud-Speicherung entwickelt, die laut Anbieter 11 Neunen Verfügbarkeit besitzt, sechsmal schneller als AWS S3 ist und 80 Prozent weniger kostet. Weitere Partner sind der Grid-Storage-Anbieter Scality mit seiner Object-Storage-Plattform Ring und HPE. HPE hat mit Komprise eine spezielle Lösung für Medien und die Unterhaltungsindustrie aufgelegt. Diese Branche hat bekanntlich bei der Filmproduktion mit wahrlich gigantischen Filestrukturen und vielen Versionen zu tun.

Hersteller: Komprise, Inc.

1901 S. Bascom Ave

Tower 1, 4th Floor

Campbell, California 95008

Tel. +49 (0)3320/38 06 29

Fax +49 (0)89/14 30 51 00

E-Mail: info@komprise.com

Web: www.komprise.com

Direkter Link zum Produkt: Komprise Intelligent Data Management

Preis: ca. 86 Euro/TByte (Komprise Analyse und automatische NAS-Migration), ca. 65 US-Dollar/TByte (Komprise-Komplettlösung)

Funktionen

- Active-Archiving

- Replikation und Disaster Recovery in die Cloud

- Datenanalyse und interaktive ROI-Visualisierung

- Zugriffs- und andere Berechtigungsstrukturen

- Automatische und regelbasierte Daten-Migration

- keine Agenten

- keine Änderungen des Datenpfads

- Scale-Out-Funktionen

- Datenanalyse und ROI-Visualisierung

- Unterbrechungsfreier Offload auf eine günstigere Speicherschicht (On- oder Off-Premises)

- Direkter Datenzugriff am Target

- Scale-out-Architektur

- Automatische und regelbasierte Datenmigration

- Replikation & DR in die Cloud

- Deep-Analytics – virtual Data-Lake für KI/ML