Software transformiert das Rechenzentrum

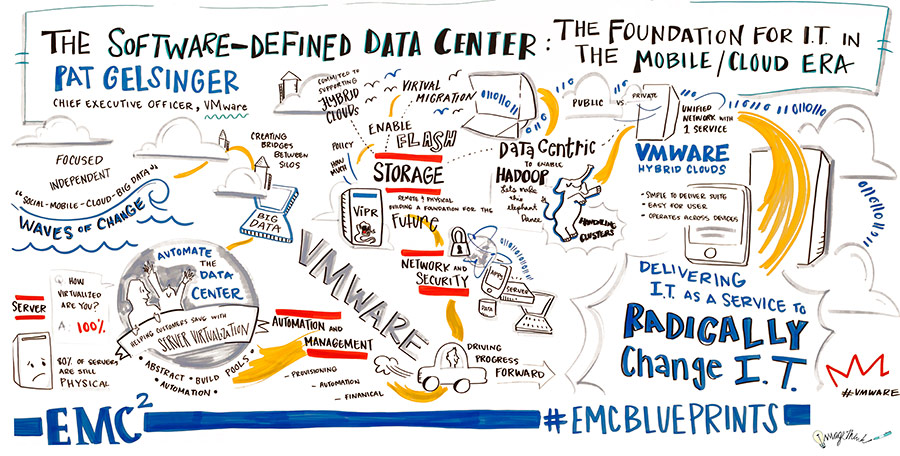

Software-definierte Lösungen stehen hoch im Kurs (Grafik: EMC).Rechnervirtualisierung allein definiert noch keine »Software Defined«-Umgebung. Allerdings wird in diesen Bereichen deutlich, was das Ziel zukünftiger IT-Architekturen ist, nämlich die Einsatzfähigkeit aller denkbaren Anwendungen unabhängig von physikalischen Gegebenheiten in allen Bereichen des Rechenzentrums und weit darüber hinaus. Vom Weg dorthin haben allerdings alle Beteiligten in diesem Bereich eine eigene Auffassung.

Software-definierte Lösungen stehen hoch im Kurs (Grafik: EMC).Rechnervirtualisierung allein definiert noch keine »Software Defined«-Umgebung. Allerdings wird in diesen Bereichen deutlich, was das Ziel zukünftiger IT-Architekturen ist, nämlich die Einsatzfähigkeit aller denkbaren Anwendungen unabhängig von physikalischen Gegebenheiten in allen Bereichen des Rechenzentrums und weit darüber hinaus. Vom Weg dorthin haben allerdings alle Beteiligten in diesem Bereich eine eigene Auffassung.

Umdenken und neue Prozesse sind gefragt

»Software Defined« ist grundsätzlich nichts anderes als die Verbreitung der Virtualisierungsidee über Rechner und Speichersysteme hinaus. Alle bislang physikalischen Dienste, also beispielsweise Sicherheitssysteme oder Netzwerk, sollen in möglichst plattformunabhängige Software umgewandelt werden. Dies wird auf längere Sicht die Infrastruktur, also Rechner-, Netzwerk- und Speichertechnik, zu Startplattformen für »Software Defined«-Dienste machen, womit der operative Betrieb vollständig vom Betrieb der Systeme abgekoppelt wäre. Diese Entwicklung wird den Gedanken der Fachabteilung, die Bildung von Dienstgruppen wie Backup, Netzwerk oder Speicherbetrieb im Rechenzentrum obsolet machen und für völlig neue, an den geschäftlichen Prozessen orientierte, Arbeitsweisen sorgen. Darüber hinaus ermöglicht erst diese Trennung die vollständige Automatisierung aller Systeme.

Durch die Unabhängigkeit der Anwendungen von der zugrundeliegenden Hardware, können neue Anwendungen, neue Prozesse oder ganze Prozeßketten wesentlich schneller und effizienter eingeführt werden. Diese Einführung lässt sich sogar soweit automatisieren, dass Selbstbedienungsportale die Installation und spätere Nutzung von Diensten bereitstellen. Dies erhöht nicht nur die Agilität einer Organisation, sondern fördert auch die Zufriedenheit der Nutzer durch Beteiligung am Erstellungsprozess. Das gesamte Unternehmen kann schneller auf interne oder noch wichtiger auf Marktanforderungen reagieren und hat damit ganz neue Möglichkeiten der Kunden- und Umsatzakquise. Neben diesen neuen Quellen bietet Software-definiert auch wesentlich bessere Übersichten über die Nutzung und die Effizienz der Systeme. Die Kosten werden transparent, die zukünftigen Bedarfe wesentlich besser planbar.

Vorteile flächendeckend im Rechenzentrum ausrollen

Durch Software-definierte Infrastrukturen können die von virtuellen Serverumgebungen oder Speichervirtualisierung her bekannten Effekte auf das gesamte Rechenzentrum ausgedehnt werden. Selbst der Beschaffung neuer Hardware, die sich auch in Zukunft niemand wird ersparen können, wird der Schrecken durch wesentlich preiswertere Systeme genommen. Und ein Vendor-Login, also die Beschränkung auf nur einen Hersteller, wird dadurch ebenso vermieden, wodurch sich bessere Preise von den Anbietern aushandeln lassen.

Alle bisher in Anwendungssilos verkapselten Kombinationen aus Rechner, Speicher, Netzwerk und anderen Komponenten werden durch ein SDDC aufgebrochen und in Pools für eben diese Infrastrukturdienste überführt. Kein Rechner, kein Array und kein Router ist mehr nur für eine Anwendung zuständig, sondern alle Ressourcen innerhalb der Hardware können jeglichem Prozess zur Verfügung gestellt werden, wenn ein solcher mehr Leistung oder zusätzliche Funktionalitäten benötigt. Damit können nun alle Komponenten, nicht nur Rechner und Speicher, wesentlich effizienter und damit kostensparender eingesetzt werden.

Keine Angst vor Migrationen

Migrationen wird durch Software-definierte Lösungen weitestgehend der Schrecken genommen. Da in einer solchen Umgebung alle Dienste auf jeglicher Hardware laufen, hin- und hergeschoben, gestartet und gestoppt werden können, stellt der Anwender einfach bei Bedarf neue oder zusätzliche Hardware auf und verteilt die Anwendungen auf diese zusätzlichen Systeme. Abschaltungen wegen Systemumzügen gehören damit in die graue Vorzeit. Durch den Wegfall dieser Herausforderungen, lässt sich die zum Betrieb benötigte Mitarbeiterzahl drastisch reduzieren. Das noch verbliebene Personal sollte dadurch Zeit und Muße für die wesentlichen Aufgaben der Datenverarbeitung erhalten, nämlich den Entwurf und die Einführung gewinnbringender neuer Anwendungen.

Gute Idee, aber noch ein langer Weg

Leider ist reines Software-definiertes RZ wie bisher beschrieben noch eine Utopie. Allerdings beschäftigen sich alle großen Anbieter mit einem deutlichen Teil ihrer Entwicklungsmannschaften mit Volldampf mit der Implementierung der ersten Komponenten. Und rennen damit bei den Anwendern prinzipiell offene Türen ein. Zwei Drittel bis vier Fünftel aller Open-Systems-Rechner in den IT-Abteilungen sind zwischenzeitlich virtualisiert, bei Speichersystemen im Enterprise-Bereich annähernd 100 Prozent. Nun gilt es, das bewährte Prinzip auf alle anderen Infrastrukturteile des Rechenzentrums anzuwenden. Zumindest sollte sich jeder mit der Anschaffung neuer Systeme befasste Verantwortliche bei jeder Komponente fragen, ob diese denn in Zukunft in ein Software-definiertes Konzept passen könnte.