Erasure-Coding ist Highlight des 1.3er Version von Quobyte

»Quobyte ist nicht einfach ein weiteres verteiltes Dateisystem, sondern eine ganz neuartige Technologie im Bereich paralleler Dateisysteme. Fehlertoleranz und Datensicherheit werden vollständig mittels Software verwirklicht, wobei zugleich die Vorzüge von Dateisystemen beibehalten werden«, erläutert Quobyte-CTO Felix Hupfeld. »Das erlaubt es, eine verlässlichere und besonders einfach zu verwaltende HPC-Speicherinfrastruktur aufzusetzen. Quobyte verwischt damit die Grenzen zwischen Scale-out-NAS und primärem und sekundärem HPC-Speicher.«

Highlight der neuen Quobyte-Version ist Erasure-Coding

Die beiden Gründer von Quobyte (v.l.): Felix Hupfeld und Björn KolbeckDen Kern des Updates auf Version 1.3 bildet das Erasure-Coding, das vor allem für sequentielle Workloads eine hohe Speichereffizienz mit großer Ausfallsicherheit verknüpft – ohne dabei etwas an Leistungsfähigkeit abgeben zu müssen. Genau wie die End-to-End-Prüfsummen und Quorum-replizierten Metadaten ist auch das Erasure-Coding eine rein in Software implementierte Funktionalität, mit deren Mitteln sich Standard-Server-Hardware in ein vollständig fehlertolerantes Speichersystem verwandeln lässt.

Die beiden Gründer von Quobyte (v.l.): Felix Hupfeld und Björn KolbeckDen Kern des Updates auf Version 1.3 bildet das Erasure-Coding, das vor allem für sequentielle Workloads eine hohe Speichereffizienz mit großer Ausfallsicherheit verknüpft – ohne dabei etwas an Leistungsfähigkeit abgeben zu müssen. Genau wie die End-to-End-Prüfsummen und Quorum-replizierten Metadaten ist auch das Erasure-Coding eine rein in Software implementierte Funktionalität, mit deren Mitteln sich Standard-Server-Hardware in ein vollständig fehlertolerantes Speichersystem verwandeln lässt.

Im Vergleich zum RAID, bei dem Redundanz in Hardware umgesetzt wird, gilt Erasure-Coding als effektiver: zum einen ist es ökonomischer, weil es Platz spart, und zum anderen wird das System insgesamt zuverlässiger und einfacher zu verwalten. Allerdings: Erasure-Coding belastet etwas den Server, es benötigt CPU-Power. Fürsprecher von Erasure-Coding betonen allerdings, dass dies bei modernen Servern kaum ins Gewicht fällt, die Vorteile würden den kleinen Nachteil der Last-Belastung aufwiegen.

Besonders geeignet für HPC- und Scale-out-NAS-Workloads

Das neue Release 1.3 sei außerdem besonders für HPC- (High Performance Computing) und Scale-out-NAS-Workloads geeignet, indem es die Anzahl möglicher IOPS erhöht und der Durchsatz noch verbessert. Außerdem liefere Quobyte Latenzen für direkten I/O, die unter einer Millisekunde liegen. Überdies erlaube es vollständig parallelisierte Metadaten-Operationen. Die neue Version vereinfache zusätzlich das Datenmanagement dank Inferface-übergreifenden Zugriffskontrolllisten (ACLs), integrierter Multi-Mandanten-Fähigkeit und hierarchischen Quotas.

Quobyte hat seine Wurzeln in der HPC-Community. Die beiden Gründer, Björn Kolbeck und Felix Hupfeld, haben zuvor – und schon zusammen mit einem Teil des jetzigen Teams – am Hochleistungsrechenzentrum Zuse-Institut Berlin (ZIB) das parallele Dateisystem »XtreemFS« initiiert und entwickelt. Für Quobyte haben sie die grundlegende Architektur und besten Teile beibehalten. Zusätzlich floss in ihre Erfahrungen die einer großangelegten Speicherinfrastruktur bei Google ein, wo beide zwischenzeitlich angestellt waren.

Quobyte-Philosophie: x86-Server zu hochperformante Storage-Systeme in neuartigen Datacentern aufzurüsten

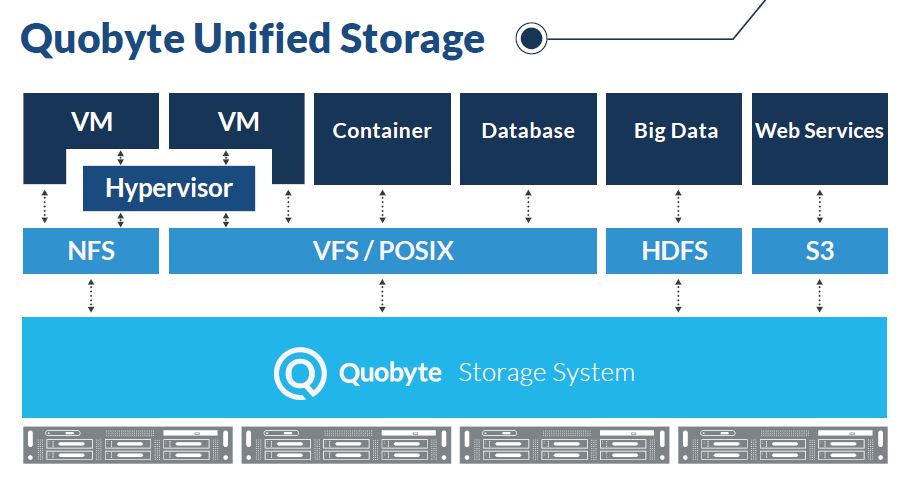

Ergebnis ist ein hochperformantes und robustes POSIX-Dateisystem, das um neue Erkenntnisse und Technologien erweitert wurde und auf zuverlässigen und sicheren Betrieb in Unternehmen ausgelegt ist. Die Philosophie der Unternehmensgründer ist es aber, dass ihre Lösung nicht allein auf HPC-Workloads festgelegt ist, sondern den Betrieb aller Arten von Applikationen unter jeglicher Arbeitslast erlaubt – und zwar auf gewöhnlichen x86-Servern.

Und so tritt Quobyte an, Standard-Hardware in ein verlässliches und hochautomatisiertes Datacenter-Dateisystem zu verwandeln. Quobyte unterstützt eigenen Angaben zufolge alle anfallenden Workloads, von virtuellen Maschinen bis hin zu Big Data und High-Performance Computing. Geboten würden alle Vorzüge eines Datacenter-Dateisystems: vollständige Fehlertoleranz, Ausfallsicherheit, Skalierbarkeit und Self-Management – verbunden mit einer administrativen Vereinfachung im laufenden Betrieb.