Freie Workload-Analyse für die Speicherinfrastruktur im Web

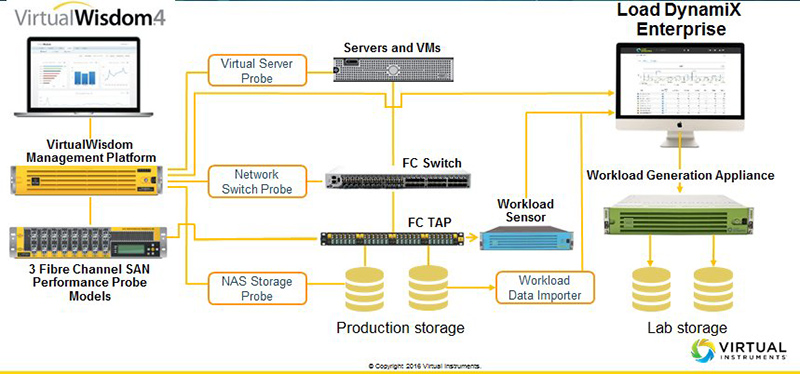

Das Zusammengehen von Virtual Instruments und »LoadDynamiX« soll den Kreis zwischen Echtzeit-Datenanalyse, Modellierung und Lasttest anhand modellierter Lasten an der Echt- oder an Testumgebungen schließen (Grafik: Virtual Instruments).Liegt es vielleicht an der Ein-/Ausgabeleistung der Speicher, dass eine Anwendung so langsam ist? Was geht auf den Verbindungen vom und zum Speicher vor sich? Wie groß sind die transportierten Zugriffe, welche Applikationen erzeugen die größte Belastung? Solche und ähnliche Fragen zu beantworten, erfordert in der Regel einiges technische Know-how und geeignetes Werkzeug. Zwar liefern die meisten Hersteller eigene Storage-Management-Software mit ihren Geräten, doch tiefergehende Analysen, die unter Umständen übersehene Zusammenhänge und Fehlerquellen offen legen, sind damit nicht immer möglich.

Das Zusammengehen von Virtual Instruments und »LoadDynamiX« soll den Kreis zwischen Echtzeit-Datenanalyse, Modellierung und Lasttest anhand modellierter Lasten an der Echt- oder an Testumgebungen schließen (Grafik: Virtual Instruments).Liegt es vielleicht an der Ein-/Ausgabeleistung der Speicher, dass eine Anwendung so langsam ist? Was geht auf den Verbindungen vom und zum Speicher vor sich? Wie groß sind die transportierten Zugriffe, welche Applikationen erzeugen die größte Belastung? Solche und ähnliche Fragen zu beantworten, erfordert in der Regel einiges technische Know-how und geeignetes Werkzeug. Zwar liefern die meisten Hersteller eigene Storage-Management-Software mit ihren Geräten, doch tiefergehende Analysen, die unter Umständen übersehene Zusammenhänge und Fehlerquellen offen legen, sind damit nicht immer möglich.

Workload-Analyse für Speicheranwender

Virtual Instruments, gestartet 2008 mit dem Ansinnen, die Abläufe in Speichernetzen bis auf die Applikationsebene zu analysieren, hat das in den vergangenen Jahren gesammelte Algorithmen-Wissen in ein frei nutzbares Online-Portal, geladen. In fünf Schritten erlaubt es Speicheranwendern, ihre Arbeitslasten zu analysieren und zu modellieren. Anwender laden dazu die von ihren Speichermanagementsystemen generierten .csv-Dateien, die in dem zu analysierenden Zeitraum entstanden sind, auf die Plattform, wo sie automatisch von nicht benötigten Daten bereinigt und ausführlich analysiert werden. Dabei fließen auch Metadaten-Abfragen in die Analyse ein. Als Ergebnis werden den Nutzern des Portals eine Reihe übersichtlicher Grafiken präsentiert, diese zeigen zum Beispiel die Zahl der Ein-/Ausgabezugriffe pro Zeiteinheit, die Blockgrößen, die Art der Daten (Block/File/Objekt), die Lese-/Schreibrate, den Anteil zufälliger gegenüber sequentiellen Zugriffen oder der Verzögerung bestimmter Datentypen. Außerdem speist das System die realen Workload-Daten in ein Modell ein.

Nach der Analyse können die IT-Manager der Plattform mit diesem Modell arbeiten und zum Beispiel simulieren, was passiert, wenn sie die Blockgröße herabsetzen, mehr File- als Blockdaten abgefragt oder geschrieben werden. Nützlich ist dies beispielsweise bei der Bewertung neuer Technologien, bei der Produktevaluierung, der Optimierung vorhandener Konfigurationen oder der Fehlersuche. Schließlich fließt der spezifische Workload jedes Unternehmens, welches die Plattform zur Analyse genutzt hat, in eine Library ein, wo andere Nutzer der Plattform sie einsehen können. Dadurch sollen Anwender voneinander lernen.

Als Ausbau dieses kostenlosen Modells ist eine Privat-Variante geplant, die Virtual Instruments vor allem an Reseller verkaufen möchte. »Sie können dann auf Basis ihres privaten WorkloadCentral-Portals ihren Kunden Services wie das Management der Storage-Infrastruktur oder die Optimierung, Fehleranalyse und -behebung in Speichernetzen anbieten«, erklärt Virtual-Instruments-CMO Len Rosenthal im Gespräch mit speicherguide.de in München.

Umfangreiche Lasttests in Speichernetzen

Zudem hat Virtual Instruments sich mit LoadDynamiX zusammengeschlossen, einem Spezialisten für Lasttests in Speichernetzen, dessen Tool mit dem bei Web-Lasttests sehr beliebten Loadrunner vergleichbar ist. Loaddynamix gestattet es, modellierte Lasten unter Echtbetriebsbedingungen auf einer Labor-Speichernetzumgebung zu testen. Dabei sammelt und speichert zunächst ein Workload-Sensor analog zu den von Virtual Instruments verwendeten Performance Probes alle Daten, die übers Speichernetz fließen. Anschließend werden sie in das Datenmodell von LoadDynamiX Enterprise importiert und lassen sich dort modellieren. Will man testen, wie eine entsprechende oder eine andere Last auf einer neuen Infrastruktur läuft, wird die gewünschte Last auf der Modell-Enginge modelliert und dann an die Workload Generation Appliance weitergeleitet. Diese erzeugt dann entsprechende Bitströme und leitet sie auf die Speicherumgebung im Labor. Rosenthal, der nach Jahren bei Virtual Instruments einige Zeit für Loaddynamix tätig war: »Wir werden in Zukunft die Performance-Probes und den Workload Sensor von Loaddynamix Enterprise in einem Gerätetyp zusammenführen.« Damit verabschiedet sich das Unternehmen von der Konzentration auf Fibre-Channel-Umgebungen und öffnet sich auch für die Ethernet-Welt.

Außerdem ist geplant, den Kreis zwischen Modell, Lasttest und Realbetrieb auch dadurch zu schließen, dass Daten aus der Modellierung und Simulation direkt in das Analysetool von Virtual Instruments, Virtual Wisdom, einfließen können. Dafür bekommen die beiden Unternehmen vom Venture-Kapitalisten HighBar im Rahmen der Vereinbarung zum Merger eine Geldspritze von 20 Millionen Dollar. Weitere Details zum Merger gab Rosenthal anlässlich des Gesprächs in München nicht preis.

Gemeinsam haben beide Unternehmen rund 200 Mitarbeiter, von denen rund 100 von Virtual Instruments, der Rest von Loaddynamix stammen und einen Umsatz »noch unter 100 Millionen Dollar« (Rosenthal). Kunden waren bisher neben Großunternehmen mit umfangreichen Speicherinfrastrukturen vor allem Speicherhersteller, die ihre eigenen Produkte mit den Lösungen testeten und überprüften. Mit dem Workload-Central-Portal sollen die Möglichkeiten der Speichernetzanalyse auch kleineren, weniger solventen Firmen zugänglich werden – möglicherweise in der Hoffnung, dass sie, wenn sie einmal »ausgewachsen« sind, weiterhin auf die gewohnte Technik zugreifen wollen, dann allerdings im eigenen Haus.