Früher hatten wir Daten, künftig existieren wir in Daten

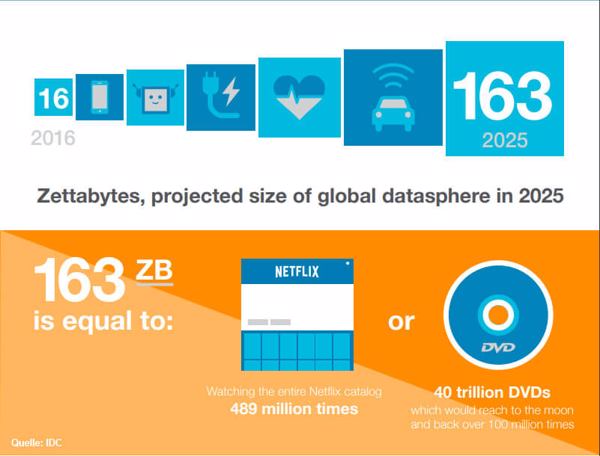

163 ZByte heißt die Zahl der nächsten 8 Jahre. Vielleicht ist sie letztlich zwangsweise kleiner, da die globale Herstellung von Speicherkapazität der IDC-Prognose nur nacheilen kann (Quelle/Grafik: IDC).Es ist eine ehrenvolle Pflicht der Speicherindustrie, nachzuweisen, dass die Datenmengen in den Himmel wachsen. Früher hat das der damalige Speicherriese EMC im »Digital Universe« mit Hilfe der Marktforscher von IDC getan, die letzten beiden IDC-Studien »Data Age 2025« sponsorte Festplattenhersteller Seagate.

163 ZByte heißt die Zahl der nächsten 8 Jahre. Vielleicht ist sie letztlich zwangsweise kleiner, da die globale Herstellung von Speicherkapazität der IDC-Prognose nur nacheilen kann (Quelle/Grafik: IDC).Es ist eine ehrenvolle Pflicht der Speicherindustrie, nachzuweisen, dass die Datenmengen in den Himmel wachsen. Früher hat das der damalige Speicherriese EMC im »Digital Universe« mit Hilfe der Marktforscher von IDC getan, die letzten beiden IDC-Studien »Data Age 2025« sponsorte Festplattenhersteller Seagate.

Letzter Stand der Dinge ist, dass »wir« im Jahr 2016 16 ZByte Speicherkapazität gefüllt haben, 2020 sollen es 44 ZByte sein. Bereits fünf Jahre später, im Jahre 2025, wird die Menschheit in und mit 163 ZByte Daten wühlen, graben, analysieren, augmentieren und virtuelle Welten vom Feinsten schaffen können.

Kleine Notiz am Rande: Dank marketingtechnischer Erkenntnisse sind Daten ja seit kurzem das Öl des 21. Jahrhunderts oder gleich der Zukunft, und während man das analoge Öl verbrennt oder zu Plastik umwandelt, ist das Schöne am Öl der Zukunft, dass man damit nichts verschmutzen kann.

Und für Datenanalysten und Besitzer von Daten noch schöner ist, dass jede Benutzung des digitalen Öls nicht zum »Peak Oil« führt, dem Ölfördermaximum nach dem bekanntlich die Zivilisation erlöscht, sondern es ist genau umgekehrt: Jede Benutzung von Daten vermehrt diese in steigender exponentieller Weise.

Das Problem mit der globalen Speicherkapazität

Man könnte sich an dieser Stelle Sorgen um die NSA machen, die ja bekanntlich als das Backup-Rechenzentrum der ganzen Welt gilt, und damit konfrontiert sind, dass die oben erwähnten 163 ZByte den Speicherplatz von 40 Billiarden DVDs belegen würden, wie IDC errechnet hat. Erstaunlich, dass trotz dieses Massenbedarfs die CD-Rohlinge bei Aldi doch immer noch sehr billig zu bekommen sind.

Aber Scherz beiseite. Man könnte die 163 ZByte auch auf 16 Billionen 12-TByte-Festplatten oder 2.000 Milliarden SSDs mit 100 TByte Kapazität verteilen oder bei 10 Watt pro 100 TByte in ihren Millionen Megawatt fressenden Energieverbrauch umrechnen – es wird damit nicht handhabbarer geschweige denn verständlicher. Zurück bleibt wahrscheinlich nur der Gedanke, dass allein die Datenhaltung ein Riesengeschäft werden müsste.

Der IDC-Report bestätigt das indirekt durch die Erwähnung, dass die Speicherindustrie in den letzten 20 Jahren zwar acht Billionen HDDs herstellte, diese aber nur vier ZByte Daten fassen. Das führt im IDC-Report zu der Überlegung beständige wachsender Speicherkapazitäten, um dem prognostizierten Speicherbedarf zu genügen:

- Von 2017 bis 2020 müssten die jährlich ausgelieferten Kapazitäten bei HDD, Flash, Tape, Optical und DRAM mehr als 5,5 ZByte überschreiten. 5,5 ZByte ist die Kapazität, die in den letzten zehn Jahren jedes Jahr produziert wurde.

- Um der Prognose von 163 ZByte jedoch gerecht zu werden, müssten von 2017 bis 2025 jedes Jahr 19 ZByte Speicherkapazität produziert werden (19ZB x 9 Jahre= 171 ZByte insgesamt). Gemessen am aktuellen Produktionsvolumen von 5,5 ZByte pro Jahr, klafft hier insofern eine riesige Versorgungslücke.

Weder Halbleiter- noch Festplattenindustrie könnten das von den vorhandenen Produktionsstätten jeweils allein gewährleisten. Bei der Lastenteilung würde auf die HDD-Abteilung 58 Prozent, auf die Flash-Industrie 30 Prozent entfallen. Den Rest würden optische und Tape-Medien beisteuern.

Der I/O wird selbst mit SSD immer langsamer

Den Anwender selbst interessiert die globale Zunahme herzlich wenig, viele wissen noch nicht einmal, wieviel originäre Daten auf ihren Speichersystemen liegen. Und wer heute 100 TByte Daten hat, der besitzt bei 50 Prozent Datenwachstum in fünf Jahren 500 TByte. Das passt alles inklusive Server und Netzwerkswitches locker in ein 19-Zoll-Rack.

Interessanter beim Vergleich von Speichermedien wäre beispielsweise der I/O-Durchsatz pro GByte. Die 9,1-GByte-Festplatte war nach Meinung vieler Fachleute unübertroffen mit ihren 300 IOs. Soll sich das Verhältnis von Datenmenge zu Durchsatz die Waage halten, müsste eine 1-TByte-HDD zirka 33.000 I/Os liefern. Das ist physikalisch nicht möglich. Aber selbst für eine SSD sind 33.000 I/Os pro TByte eine gute Rate.

Eine 100 TByte SSD wie von Nimbus Data für den Sommer 2018 angekündigt, müsste dann pro Laufwerk 3,3 Millionen I/Os liefern. Tut sie aber nicht. Es sollen etwa 100.000 I/O pro Sekunde sein. Man sieht, die SSD steht heute vor demselben Problem wie die HDD vor 20 Jahren. Die Auswertung von Daten funktioniert rein rechnerisch wesentlich schneller als mit HDDs, bezogen auf die Datenmenge hat die 9,1-GByte-Festplatte bei den I/Os die Nase vorn.

Ebenfalls interessant im Zusammenhang mit der Speicherkapazität ist die Frage »Woher kommen die Daten?«. Die Frage »Wem gehören die Daten?« wird wahrscheinlich die DSGVO ein Stück weit klären und der politische Wille, ob man spezifischen Daten einen Preis gibt und damit einen Eigentümer definiert.

Daten, Ausdruck individueller Bedürfnisse

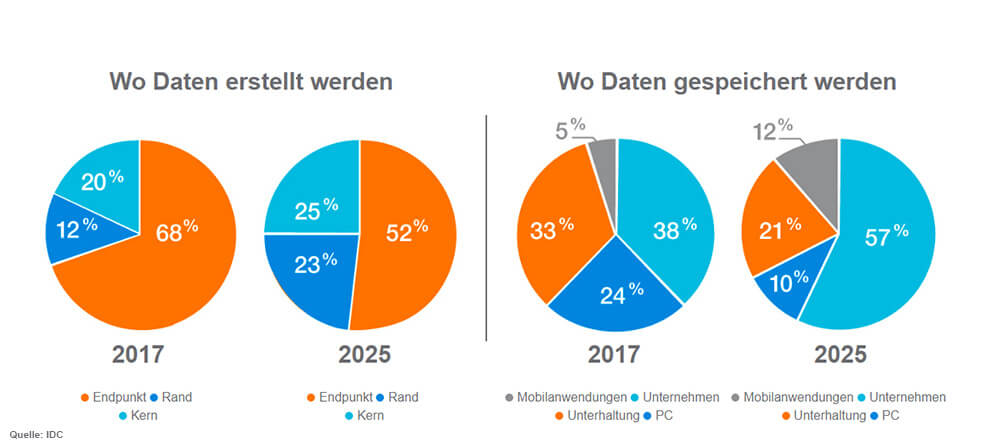

Ist die Kontrolle über den Ort der Datenproduktion gleichbedeutend mit Besitz? Oder garantiert der Ort der Datenspeicherung, die Verfügungsmacht über die Inhalte? (Quelle/Grafik: IDC)Woher kommen also die Daten? Der IDC-Report stellt auf Seite 21 fest, dass sich die Datenquellen verschieben werden: vom Konsumenten zu den Unternehmen. Wurden 2015 weniger als 30 Prozent aller Daten durch Unternehmen erzeugt, so werden es 2025 bereits 60 Prozent aller Daten sein. Da allerdings die Konsumenten auf den Plattformen von Google & Co. ihre Inhalte erzeugen, verwalten Unternehmen mehr als 97 Prozent der globalen Dateninhalte.

Ist die Kontrolle über den Ort der Datenproduktion gleichbedeutend mit Besitz? Oder garantiert der Ort der Datenspeicherung, die Verfügungsmacht über die Inhalte? (Quelle/Grafik: IDC)Woher kommen also die Daten? Der IDC-Report stellt auf Seite 21 fest, dass sich die Datenquellen verschieben werden: vom Konsumenten zu den Unternehmen. Wurden 2015 weniger als 30 Prozent aller Daten durch Unternehmen erzeugt, so werden es 2025 bereits 60 Prozent aller Daten sein. Da allerdings die Konsumenten auf den Plattformen von Google & Co. ihre Inhalte erzeugen, verwalten Unternehmen mehr als 97 Prozent der globalen Dateninhalte.

Beispielhaft erläutert der IDC-Report am Daten-Streaming wie der Konsum von Daten in Form von Audio und Video zur Inbesitznahme von Kundeninformationen führt. Streaming eigentlich ein Konstruktionsprinzip des Internets verteilt in einer Multicast-Aktion Inhalte an den Konsumenten. Eigentlich eine schöne Speicherersparnis, da der Streaming-Teilnehmer die Inhalte nicht auf seine Systeme kopiert. Doch die gleichzeitige Erhebung von Metadaten

- ob der Dienst gestoppt wurde,

- wie lange wurde er gestoppt,

- wurden Szenen übersprungen,

- mit welchem Gerät wurde der Dienst konsumiert,

macht den Dienst smarter. Dies zeigt aber auch, wenn die Daten nach Beendigung des Dienstes nicht gelöscht werden, das innewohnende Potenzial für die Marketingabteilung des Anbieters.

Das Datenzeitalter benötigt, IDC zufolge, viel Speicherplatz. Wo der herkommen soll, ist noch unklar. Doch wichtiger als diese kleine Sorge, sind die Möglichkeiten, die vor allem in den Metadaten stecken. Der Umbruch ganzer Industriezweige ist für jedermann erkennbar. Die IT-Steuerung von Elektromotoren beendet die »Freude am (Selber) Fahren«, eine Brille macht jedermann zum Experten. Doch hierüber wird speicherguide.de in einem weiteren Artikel berichten.