Hyperkonvergenz – SAN zweiter Klasse?

Von hyperkonvergenten Infrastrukturen (HCI) versprechen sich Unternehmen vereinfachte und kostengünstigere Rechenzentrumslösungen vor allem im Umfeld virtualisierter Anwendungen. Dabei können sie aber auch wirtschaftliche Risiken bergen und in technologische Sackgassen führen. Zeit, um einige Mythen zu verwerfen.

Michael Baumann, Konzept PR

Hyperkonvergenz muss aus einer Hand kommen?

Grafik: DatacoreDie Bündelung der Hardware-Ressourcen in einem Gerät ist eine kompakte und effiziente Rechenzentrumslösung, die besonders für Abteilungen, Remote-Standorte oder bestimmte Systemumgebungen geeignet ist. Diese Reduktion und Zentralisierung geht einher mit bekannten Vorteilen: weniger Hardware-Investition, übersichtliches Geräte-Management, geringere Rechenzentrumsfläche und vereinfachte Wartung. Nicht selten wird aber angenommen, wenn vom Konzept »Infrastructure in a Box« gesprochen wird, dass hyperkonvergente Lösungen hauptsächlich hardwaregetrieben seien und daher die »Geräte« aus der Hand eines Anbieters stammen müssten. Doch dies ist mitnichten der Fall.

Grafik: DatacoreDie Bündelung der Hardware-Ressourcen in einem Gerät ist eine kompakte und effiziente Rechenzentrumslösung, die besonders für Abteilungen, Remote-Standorte oder bestimmte Systemumgebungen geeignet ist. Diese Reduktion und Zentralisierung geht einher mit bekannten Vorteilen: weniger Hardware-Investition, übersichtliches Geräte-Management, geringere Rechenzentrumsfläche und vereinfachte Wartung. Nicht selten wird aber angenommen, wenn vom Konzept »Infrastructure in a Box« gesprochen wird, dass hyperkonvergente Lösungen hauptsächlich hardwaregetrieben seien und daher die »Geräte« aus der Hand eines Anbieters stammen müssten. Doch dies ist mitnichten der Fall.

Die Vorteile verdanken sich vor allem der eingesetzten Software: Nach Definition von Gartner zum Beispiel ist das Entscheidende, dass die Storage-Management-Funktionen (Hochverfügbarkeit, Recovery, Replikation, Deduplikation, Komprimierung) aus der Hardware gelöst und auf einer übergeordneten Software-Ebene angesiedelt werden. Dies entspricht der Definition von Software-defined Storage, wo im Zusammenspiel der Virtualisierungs-Software für Server und Storage der Schlüssel für effektive Hyper-Konvergenz liegt.

HCI ist ein geschlossenes System?

Wenn man der unzutreffenden hardwareorientierten Box-Definition folgt, kann man leicht der Täuschung erliegen, dass hyperkonvergente Lösungen notwendigerweise geschlossene, »schlüsselfertige« Appliances seien – und mancher Anbieter vermarktet sie auch so. Doch genau der Vorteil des Virtualisierungs- und damit Software-Ansatzes – der Einsatz von Standard-Komponenten – wird dadurch zerstört, also eine vollkommen gegen den Sinn der Technologie gerichtete Auslegung.

Effektive Hyper-Konvergenz sollte deshalb vielmehr den Ansatz verfolgen, sich aus der Abhängigkeit von proprietärer Hardware herauszulösen und stattdessen frei und flexibel Server-, Netzwerk- und Storage-Komponenten wählen zu können. »Silo-Lösungen« sind nicht zwangsläufig, wenn auf Software-definierten Dateninfrastrukturen aufgebaut wird.

HCI skaliert nicht?

Wachstum und erhöhter IT-Bedarf machen auch vor hyperkonvergenten Infrastrukturen nicht halt – die Skalierungsmöglichkeiten der gewählten Systeme sind daher von entscheidender Bedeutung. Und hier sind hardwarelimitierte Silo-Lösungen hoch problematisch. Also sollte, wer die Einführung hyperkonvergenter Lösungen erwägt, sich von Beginn an die Skalierungskonzepte der zur Wahl stehenden Anbieter genau ansehen und abklopfen, ob die Lösung mit heterogener Hardware funktioniert, ob verschiedene Hypervisor-Plattformen unterstützt werden, und auch nicht-virtualisierte Applikationen wie Echtzeit-Datenbanken integriert werden können.

So, wie es bei einer Software-definierten Infrastruktur selbstverständlich ist. Sie ist die Basis, um die (Selbst-)Beschränkungen bei der Skalierung zu vermeiden. Weitere Knoten (Scale-out) können ebenso flexibel gewählt werden wie Komponenten zur Optimierung der vorhandenen (Scale-up). Auch die Anfangsinvestition kann hierbei ein Kriterium sein. So gibt es Lösungen, die Hochverfügbarkeit bereits mit zwei Knoten erzielen, während andere hierfür drei benötigen. Je nach Größe des Anwendungsfeldes ein beträchtlicher Kostenunterschied!

Flash ist ein Muss?

Auch wenn durch eine hyperkonvergente Lösung eine Performance-Optimierung angestrebt wird, ist nicht zwingend notwendig, zu diesem Zwecke Flash-Speicher einzusetzen – vielmehr ist bei den intelligenteren Ansätzen Flash nur eine mögliche Steigerungsoption unter anderen.

Nicht wenige Hyperkonvergenz-Lösungen schreiben Flash für das Caching der Input-/Output-Verarbeitung zwingend vor, was die Kosten erhöht. Bei ausgereiften Software-definierten Lösungen wie etwa dem Virtual SAN von DataCore bleibt Flash dagegen eine Option als Primärspeicher für Tier-1-Anforderungen performancehungriger Anwendungen. Für das eigentliche Caching dagegen wird der performantere DRAM-Arbeitsspeicher genutzt, der in einer virtualisierten Umgebung in der Regel ohnehin üppig vorhanden ist.

Eine weitere Neuerung bei der hyperkonvergenten Performance ist die Einführung der Parallel I/O-Technologie mit der Virtual-SAN-Software. Die DataCore-Technologie ermöglicht erstmals eine parallele I/O-Verarbeitung in den heute gängigen Mehrkernprozessoren. Vor allem lastenintensive Datenverarbeitungsprozesse profitieren von einer Performance-Vervielfachung. Gleichzeitig können virtuelle Maschinen auf hyperkonvergenten Systemen dichter gepackt und damit Einsparpotenziale auf bislang unerreichtem Niveau erzielt werden – ganz ohne SSD oder Flash. Der nutzbringende Einsatz von Flash bzw. SSD basiert bei dieser Lösung auf einem Block-basierten Auto-Tiering: Damit kann die Software automatisch Datenblöcke von langsamerer auf schnellere Hardware leiten und dramatische Performance-Steigerungen erzielen.

Zweitklassiges SAN?

Effiziente hyperkonvergente Ansätze profitieren als ganz erheblich von einer ausgereiften Technologie aus dem Software-defined Storage-Umfeld. Gilt dies auch für die notwendige Ausfallsicherheit? Erst durch den Einsatz von SAN-erprobter Hochverfügbarkeitstechnologie, mit hardware- und plattformübergreifenden Automatismen wie transparentem Failover und Failback, kann man wirklich von Hochverfügbarkeit sprechen.

Darüber hinaus sollte die Virtual SAN-Plattform als Teil der hyperkonvergenten Lösungen das gesamte Feature-Set einer SAN-Software aufbieten können: flexible Speicherbereitstellung für alle Plattformen, Migrationsunterstützung (»in and out«), Replikation mit Deduplizierung und Komprimierung, CDP, vernünftiges Monitoring und Analyse der Speicherauslastung und vieles mehr. Die wenigsten hyperkonvergenten Anbieter verfügen jedoch über diese SAN-Expertise.

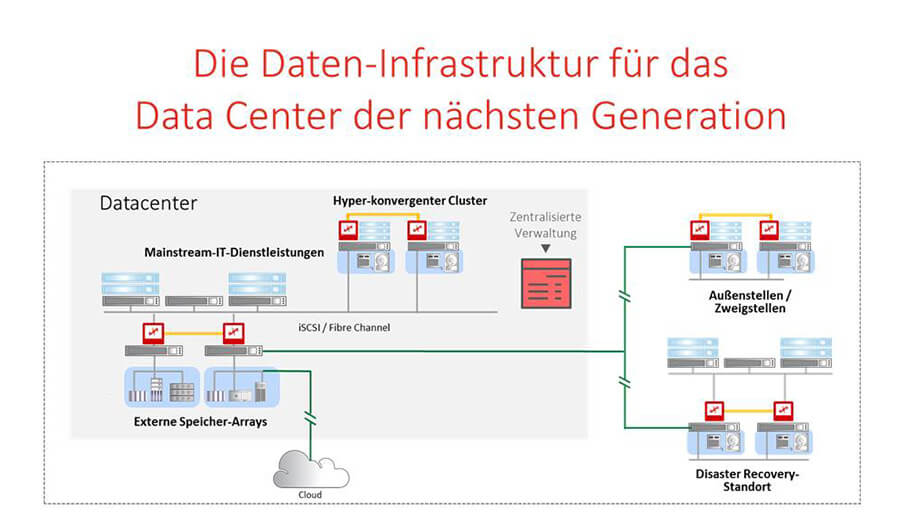

Auch bei weiterwachsenden Anforderungen erweist sich die Software-definierte Dateninfrastruktur als der zukunftssichere Weg: So ist beispielsweise DataCore ein Hersteller, der hyperkonvergenten Speicher mit physischen SANs und der Cloud kombinieren kann, in einem Parallel-Betrieb effektiv zusammenführen und zentral verwalten kann. Die eigentliche Frage ist deshalb nicht, ob Hyper-Converged, Converged oder herkömmliches SAN. Die Frage ist vielmehr, wie Unternehmen heutige RZ-Anforderungen umsetzen können und sich dabei gleichzeitig flexibel für die Zukunft aufstellen können. Der Schlüssel hierfür ist und bleibt die Software.

Datacore Software GmbH

Bahnhofstraße 18, D-85774 Unterföhring

Tel: +49 (0)89 - 46 13 57 00, Fax: +49 (0)89 - 461 35 70 90

E-Mail: infoGermany@datacore.com