4 Kriterien für Sekundär-Storage

Es ist wie im richtigen Leben: Die sexy Primärspeicher erhalten 80 Prozent der Aufmerksamkeit (und des Budgets), die langweiligen Sekundär-Storage haben 80 Prozent der Arbeit (Datenvolumen). Während Primärspeicher meist alle drei Jahre ersetzt werden, müssen Backup- und Archivspeicher länger durchhalten.

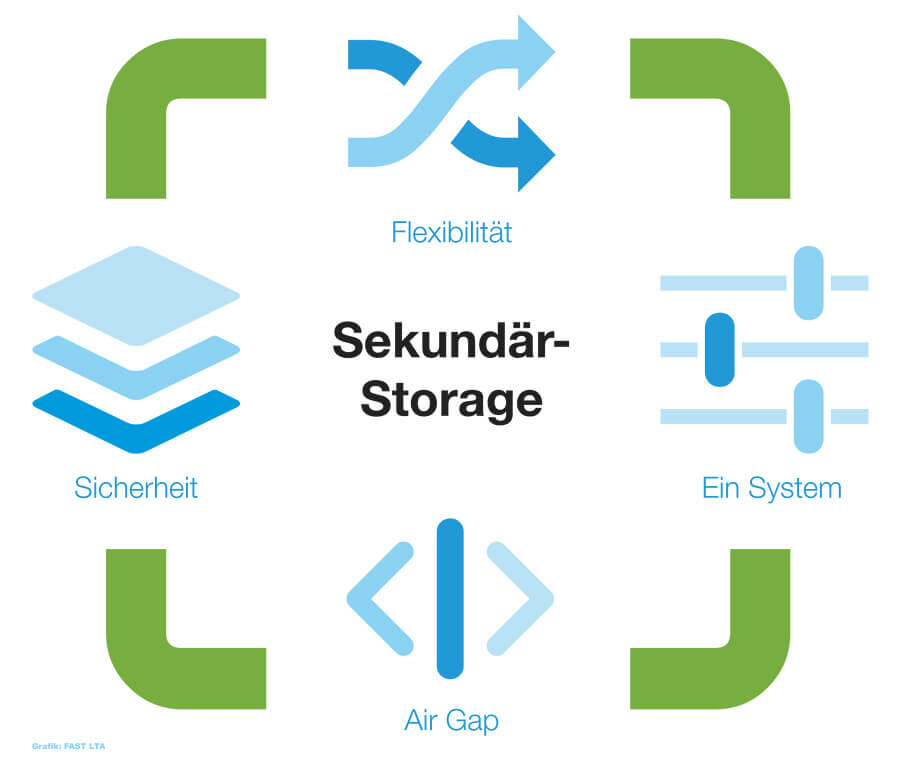

Die Entscheidung für einen Sekundärspeicher will also gut überlegt sein. Die folgenden vier Kriterien spielen dabei eine besondere Rolle.

#1: Datensicherheit

Eigentlich logisch: Wenn ein Storage für Backup und Archivierung vorgesehen ist, sollte es selbst keine zusätzliche Sicherung benötigen. Das Thema Sicherheit lässt sich dabei in drei Ebenen aufteilen:

Absicherung auf System-Ebene, um gegen Datenverlust durch Totalausfall gesichert zu sein. Fällt ein Speichersystem einem Feuer oder Wasserschaden oder einem Diebstahl zu Opfer, hilft keine noch so aufwändige Technologie. Dagegen schützt nur die Spiegelung von Daten an einen zweiten Standort.

Silent Brick System mit über 5 Slots, lässt sich durch Shelves mit je 14 Slots erweitern (Grafik: Fast LTA).

Silent Brick System mit über 5 Slots, lässt sich durch Shelves mit je 14 Slots erweitern (Grafik: Fast LTA).

Absicherung auf Hardware-Ebene, um gegen Datenverlust durch Ausfall von Datenträgern geschützt zu sein. Dies wird durch Kopien oder Redundanz erreicht, so dass eine definierte Anzahl der verwendeten Datenträger ausfallen kann, ohne dass dies gleich zu Datenverlust führt. Am bekanntesten ist hier RAID, das allerdings als nicht sicher genug gilt, um ohne zusätzliche Sicherung auszukommen. RAIDz (Teil von ZFS), vor allem in der Variante Triple-Parity, ist bereits deutlich sicherer, da schleichende Fehler und somit ein Scheitern des Rebuilds meist vermieden werden. Als besonders sicher gilt Erasure-Coding, das als Nachfolger von RAID gehandelt wird.

Absicherung auf Zugriffs-Ebene, um gegen Datenverlust oder -Manipulation durch Angriffe oder Fehlbedienung geschützt zu sein. Je nach Anwendung sind regelmäßige oder gar automatische Snapshots, sowie der Schutz durch Hardware-WORM-Versiegelung die Mittel der Wahl. Verstärkt auftretenden Attacken (z.B. Ransomware), aber auch mutwilligen oder versehentlichen Löschversuchen wird so effektiv ein Riegel vorgeschoben.

#2: Flexibilität

Üblicherweise beträgt der Investitionszeitraum in der IT drei Jahre. Sekundärspeicher müssen jedoch länger ihre Arbeit verrichten. Deshalb ist es essenziell, dass dieses Storage maximale Flexibilität aufweist, um für die Zukunft gewappnet zu sein.

Die Skalierbarkeit ist dabei der erste Aspekt, der ins Auge fällt. Der Bedarf an Speichervolumen wächst rapide, kaum jemand kann vorhersagen, wie viele Daten in drei, fünf oder zehn Jahren anfallen. Wenn man ein Speichersystem schon beim Kauf so dimensionieren muss, dass es alle Eventualitäten berücksichtigt, sind meist sehr hohe Investitionen notwendig. Besser geeignet sind Systeme, die elastisch je nach Bedarf skalieren. Ein wichtiger Aspekt dabei: Die Skalierbarkeit muss auch dann gewährleistet sein, wenn die initial eingesetzten Datenträger Jahre später unter Umständen nicht mehr zur Verfügung stehen.

Zur Flexibilität gehört auch, dass die Konfiguration des Systems nicht zu festgelegt ist. Welche Dateisysteme, Software-Anbindungen und Anwendungen werden unterstützt? Ist eine Ergänzung durch SSDs möglich, wenn sich deren Preisniveau dem der Festplatten weiter annähert? Können Speicherbereiche flexibel unterschiedlichen Anwendungen zugeordnet werden und können die auch unabhängig voneinander wachsen?

Nicht außer Acht zu lassen ist auch die Konnektivität des gewählten Systems. Abhängig von der gewünschten Anwendung kann es notwendig oder gewünscht sein, dass die physikalische Anbindung mit den steigenden Anforderungen wächst. Wo heute 1-Gbit-Ethernet üblich ist, sind morgen schon 10, 40 oder 100 Gbit gefordert. Wenn der reine Speicher fest mit den Server-Komponenten verbunden ist, ist ein Upgrade in der Regel nur zusammen möglich.

#3: Offline-Fähigkeit

Alle Daten sind ständig online, in der Cloud und überall und jederzeit verfügbar. Das birgt jedoch eine Reihe von Nachteilen und Risiken, die für Sekundärspeicher zu Problemen führen können.

Ständig erreichbare Datenspeicher sind auch ständig durch Ransomware und Hacker bedroht. Massiv verteilte Speicherstrukturen (Cloud) führen zu Unsicherheiten im Umgang mit sensiblen Daten und sind oft nicht rechtmäßig im Sinne von Richtlinien und Regularien, wie zum Beispiel der EU-DSGVO. Deshalb erleben offline-fähige Speicherkonzepte in letzter Zeit einen erneuten Aufschwung.

Ein Air-Gap schützt vor »Ansteckung« (Grafik: Fast LTA).

Ein Air-Gap schützt vor »Ansteckung« (Grafik: Fast LTA).

Das Stichwort dabei ist »Air Gap«. Was nicht verbunden (sondern durch eine physikalische Lücke, ein »Air Gap« getrennt) ist, kann sich nicht »anstecken«, da kein Zugriff möglich ist. Wünschenswert ist dabei natürlich, nicht extra aufwändige Offline-Kopien ziehen zu müssen, die man dann zugriffssicher zum Beispiel im Safe verwahren kann. Das Handling mit solchen reinen Offline-Medien ist so mühsam, dass im Grunde die Hoffnung überwiegt, dass man diese Kopien nie wieder benötigt. Von Haus aus offline-fähige, nicht-lineare Medien erlauben es hingegen, Daten schnell und ohne aufwändiges Kopieren wieder verfügbar zu machen.

#4: Geringe Komplexität

Die Reduzierung der Komplexität in der IT ist eines der großen Themen der kommenden Jahre, kaum ein Betrieb kann sich Spezialisten für jede Komponente leisten. Klar Primärspeicher genießen besondere Aufmerksamkeit und müssen individuell auf die jeweiligen Performance-Anforderungen abgestimmt sein.

Für die langfristige Aufbewahrung gilt dagegen immer: weniger ist mehr. Je mehr Systeme involviert sind, desto mehr Ansprechpartner, Konfigurationen, User-Interfaces und Wartungsverträge.

Da Sekundärspeicher auf langfristige Sicherung ausgelegt sind, spielen auch die Dauer der Wartungsverträge und die Möglichkeit der Verlängerung zu gleichbleibenden Konditionen eine wichtige Rolle.

Fazit: Always On oft nicht datenschutzkonform

Sicherheit und Skalierbarkeit sind offensichtliche Anforderungen an Speichersysteme für Backup und Archiv, doch schon da gibt es erhebliche Unterschiede. Dazu kommen die neue (alte) Anforderung nach Offline-Fähigkeit, da »always online« oft nicht datenschutzkonform und verstärkt Attacken ausgesetzt ist. Über allem steht der generelle Wunsch des »fire & forget«: ein Sekundärspeicher muss unkompliziert, langfristig zuverlässig seinen Job tun, Daten sichern.

- Primärspeicher sind teuer eine Verlangsamung des Ausbaus reduziert massiv die Investitionen.

- Datensicherung ist überlebenswichtig für Unternehmen, Backup- und Archivspeicher müssen von Haus aus sicher sein.

- Die Konsolidierung der Sekundärspeicher reduziert Komplexität und erhöht die Sicherheit.

FAST LTA GmbH

Rüdesheimer Str. 11

80686 München

Tel. 089/89 047-0

E-Mail: info@fast-lta.de