Kosten sprechen für die Desktop-Virtualisierung

Mit der Betriebssystem-Virtualisierung über Container lassen sich höhere Desktop-Dichten unterstützen als bei Hypervisor-Konzepten. Doch es gilt nicht nur die Anzahl der Arbeitsplätze ins Kalkül zu ziehen, auch der Aufwand für den Speicher kommt in die Gleichung.

Ganz oben auf der Agenda der IT-Verantwortlichen rangiert immer noch die Reduzierung der IT-Kosten, doch will man dabei die Flexibilität der IT für das Geschäft nicht ausbremsen. Auf die Ausgaben für die Client-Systeme umgesetzt hat das zur Folge, dass die Unternehmen einerseits vor der Herausforderung stehen, den Umstieg auf Windows 7 zu bewerkstelligen. Andererseits wäre es schön, die bestehende Client-Hardware noch länger zu nutzen. Hier erkennen die Marktforscher ein großes Potenzial für die Virtual-Desktop-Infrastructure (VDI).

Während beim Terminalserver-Ansatz nur weitgehend standardisierte Applikationen von einer Terminalserver-Farm den angeschlossenen Clients über ein Protokoll wie Microsofts RDP (Remote Desktop Protocol) oder ICA (Independent Computing Architecture) von Citrix bereit gestellt werden, bekommen die Anwender bei VDI dagegen einen kompletten Desktop – also Betriebssystem plus Applikationen sowie eigene Benutzerprofildaten zur Verfügung gestellt.

Connection-Broker bringen User zum Desktop

Diese Desktops laufen aber ebenfalls auf einem zentralen Server, der über eine Virtualisierungs-Plattform die Desktops startet und die gesamte Abarbeitung der Aufgaben übernimmt. An den Clients selbst werden ebenfalls nur die Ergebnisse angezeigt. Spezielle Module wie Connection-Broker übernehmen den Auf- und Abbau von Sessions und stellen sicher, dass Benutzer – egal von wo aus sie ihre Desktops starten – wieder die gewohnte Umgebung – Daten, Programme, Betriebssystem und Umgebungsdaten – zur Verfügung haben. Für die Verbindung mit den Clients kommen ebenfalls eigene Protokolle zum Einsatz – wie etwa PCOIP. Dieses Protokoll hat Teradici in Zusammenarbeit mit VMware erstellt.

Als Virtualisierungs-Plattform haben sich zum einen Hypervisor-Konzepte durchgesetzt. Vmware, Citrix, Microsoft und Redhat – um die prominentesten zu nennen – verfolgen diesen Ansatz. In eigenen virtuellen Maschinen werden aus entsprechenden Vorlagen auf derartig virtualisierten Servern dann die Desktops in einer VM an die anfragenden Clients ausgeliefert. Hier zählt in erster Linie der Wert, wie viele VMs eine Virtualisierungs-Plattform unterstützen kann. Denn für jedes Client-System muss auf dem Server eine passende Instanz gestartet werden.

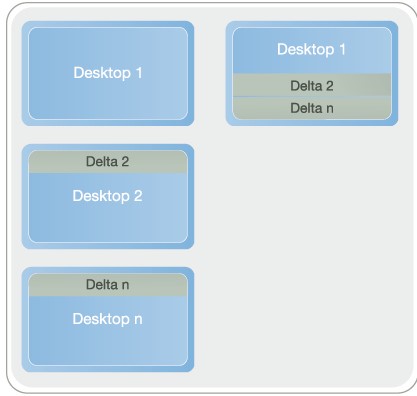

Zudem ist auch Speicherplatz auf den Massenspeichern nötig, um diese Images alle aufzunehmen. Hier haben Konzepte die Nase vor, die mit geeigneten Image-Techniken arbeiten und damit für die gleichartigen Teile eines Master-Images nur eine Kopie ablegen und die jeweiligen Änderungen über Delta-Dateien hinzufügen.

Hypervisor-Konzepte haben sich durchgesetzt

Hypervisor-Virtualisierung als Basis für VDI hat den Vorteil, dass sich verschiedene Client-Betriebssysteme gleichzeitig auf dem Server für die Clients bereitstellen lassen. Doch auf Grund des zugehörigen Overheads für das Umsetzen der vielen Softwareschichten im Hypervisor und der verschiedenen Gastbetriebssysteme lassen sich auf einem Standardserver weitaus weniger Desktops virtualisieren als etwa bei der Betriebssystem-Virtualisierung. (Auch der Hypervisor besitzt einen Software-Stack, um die Aufgaben wie Netzwerkzugriff und Massenspeicheranbindung über aufwendige Pufferstrukturen zu realisieren.)

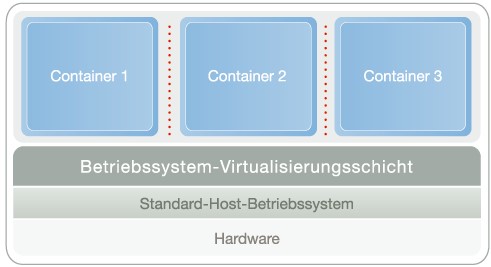

Das bereits für die Serverkonsolidierung bewährte Prinzip der Betriebssystem-Virtualisierung unterscheidet sich vor allem in einem Punkt von anderen Technologien: Die virtuelle Abstraktionsschicht setzt auf dem Betriebssystem des Hosts auf und nicht auf der Hardware. Dieses Konzept verfolgt Parallels mit seiner VDI-Lösung, die zudem noch einen Connection-Broker von Quest Software mit eingebaut hat. Die Nutzung verschiedener Betriebssysteme nebeneinander ist damit allerdings nicht möglich, doch in den meisten kostenbewussten Unternehmen ist bereits eine entsprechende Vereinheitlichung der Desktop-Plattformen als oberste Devise ausgegeben. Zudem ist auf den allermeisten Unternehmens-Desktops das Windows-Client-Betriebssystem die mit Abstand dominierende Plattform.

Die virtuelle Schicht erzeugt auf dem Server und der Betriebssysteminstanz zahlreiche isolierte virtuelle Umgebungen: die Container, in denen je ein virtueller Desktop läuft. Die Folge: Die Hardware muss nicht virtualisiert und das Betriebssystem nur einmal auf dem Server installiert werden und nicht zusätzlich in jedem einzelnen Container.

Effektiv arbeitet der Container-Ansatz

Diese Lösung besticht durch einen äußert geringen Ressourcenverbrauch und minimalen Verwaltungs-Overhead auf dem Server. Ein typischer Wert für eine derartige Lösung in Bezug auf den notwendigen Festplattenspeicher liegt, so die Aussage von Parallels, bei 50 bis 60 MByte pro Desktop. Die Betriebssystem-Virtualisierung hat zudem in der Praxis bewiesen, dass sie eine dreimal höhere Desktop-Dichte pro Server erzielen kann, als das bei der Hardware-Virtualisierung möglich ist.

Eine gewisse Skepsis ist im VDI-Umfeld aber angebracht. Scott M. Herold, Lead Architect Virtualization Business bei Quest Software, sieht einige Einschränkungen. »VDI passt nicht für alle Anwendungen. Problemfelder betreffen die Kosten für den Speicher und andererseits das Antwortverhalten der Applikationen auf den Desktops. Die Enduser akzeptieren keine langsamen Applikationen.«

Der Einsatz von Templates, also vordefinierten Vorlagen aus Betriebssystem und Applikationen, für VDI-Desktops erfordern, dass die Patches für das Betriebssystem und die Anwendungen in die Templates eingearbeitet werden. Hier sieht Herold allerdings noch massive händische Arbeiten als notwendig an. Skripting könne helfen, um den Verwaltungsaufwand zu reduzieren.

Ein weiteres Problemfeld sieht der Virtualisierungsexperte in den Speicherkosten: »Vergleicht man die Speicherkosten bei einem Konzept mit normalen Desktops, bei dem die Festplatten vergleichsweise günstig sind, so liegen die Informationen bei der VDI auf den teuren Speichersystemen – da liegt ein Faktor von vier bis fünf dazwischen.«

Speichereinsparmethoden wie etwa das Arbeiten mit Master-Images und den zugehörigen Dateien, die die Unterschiede aufnehmen, führen auf der anderen Seite zu Performance-Herausforderungen. Denn die Kosteneinsparungen beim Speicher müsse man mit Rechenleistung bezahlen.

Für die zukünftigen Infrastrukturkonzepte sieht Herold aber eine ganz andere Konstellation aufziehen: »Wenn man sich die webbasierten Anwendungen ansieht, wird schnell klar, dass künftig nicht mehr komplett ausgestattete Clients nötig sind. Mobile Endgeräte wie iPhone haben das Zeug dazu, über einen Browser-basierten Client Softwarepakete aus der Wolke zu verwenden.« Das könnte traditionelle Applikationen auf das Abstellgleis schieben.