Produkt-Review: Datacore »SANsymphony«

Für SANs geben Unternehmen zum Teil viel Geld aus, nicht immer an der richtigen Stelle. Oft überwiegen heterogene Strukturen und die Möglichkeiten von Virtualisierung sind nicht ausgereizt. Von Datacores virtuellen Pools profitieren, unter anderem, virtuelle Server. Resultat: eine gleichförmige Struktur im Rechenzentrum, ohne Einbußen bei Performance und Verfügbarkeit.

Von Hartmut Wiehr

Speicher-Virtualisierung ist ein relativ altes Konzept. Es sah anfangs lediglich die Zusammenfassung von Speicherdaten über mehrere unterschiedliche Arrays hinweg vor: Dies ist notwendig in einem Storage-Area-Network (SAN), in dem diverse Server samt Applikationen mit einer Palette von heterogenen Speichergeräten zusammenarbeiten sollen. Aber auch bei Direct-Attached-Storage (DAS) oder Network-Attached-Storage (NAS) findet sich dieses Szenario. Ein gemeinsamer logisch aufgebauter Pool ist besonders dann des Problems Lösung, wenn historisch gewachsene oder bei einer Akquisition bzw. einem Merger zusammengewürfelte Gerätelandschaften miteinander auskommen sollen.Wer da mit wem in einem (virtuellen) Pool zusammen passt, unterscheidet sich von Hersteller zu Hersteller – alle, ob Dell, EMC, Hewlett-Packard, Hitachi-Data-Systems oder IBM pflegen diesbezüglich ihren eigenen, letztlich proprietären Ansatz. Unter den wenigen unabhängigen Anbietern von Speichervirtualisierung, die schon länger am Markt sind, hat sich vor allem DataCore einen Namen gemacht. Man ist selbst nur mit Software für Speicher-Virtualisierung am Markt und arbeitet mit diversen Anbietern von Hard- und Software zusammen. Strategische Partner sind derzeit die Spezialisten für Server- und Desktop-Virtualisierung Citrix, Microsoft und VMware. Kooperationen mit anderen unabhängigen Anbietern von Speichervirtualisierungs-Software gibt es nicht.

Das Prinzip von Datacores »SANsymphony« ist einfach: Es geht um geräteunabhängige Einbindung von Speicherplatz, der von unterschiedlichen Array-Anbietern zur Verfügung gestellt wird. Dieses virtuelle Disk-Pooling kann auch als Fortsetzung oder Weiterentwicklung des RAID-Ansatzes betrachtet werden, bei dem es sich im Prinzip um die Datensicherung quer über verschiedene Festplatten handelt. Je nach RAID-Modell lassen sich so in einer virtuellen »Gesamtfestplatte« verschiedene Lösungen für die zuverlässige Sicherung der Daten aufbauen. Ein virtueller Pool aus unterschiedlichen Disk-Arrays von diversen Herstellern macht grundsätzlich betrachtet nichts anderes.

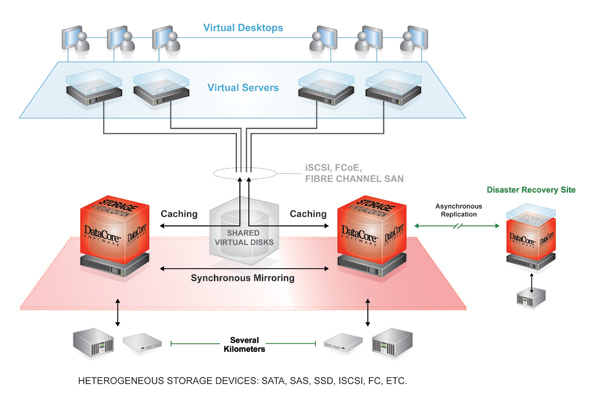

Sansymphony bietet IT-Abteilungen bereits seit Jahren die Möglichkeit, Speichergeräte unterschiedlicher Hersteller zu einem logischen Volume zusammenfassen. Neben diesem Hauptcharakteristikum haben die Datacore-Entwickler mit der Zeit weitere Funktionen hinzugefügt, darunter Hochverfügbarkeit durch synchrone Spiegelung, leistungsfähiges Caching oder asynchrone Replikation. Modernisierungen von Sansymphony betrafen darüber hinaus Online-Snapshots, transparente Migration und Back-end Load-Balancing. Parallel zu der allgemeinen Verfügbarkeit von Thin Provisioning hat man ebenfalls dynamische Speicherbereitstellung angeboten.

Ganz vorne, aber unbemerkt

Vielleicht stand man nicht immer von Anfang an der Spitze des technologischen Fortschritts, doch wurde das Portfolio beständig erweitert und an das allgemeine Niveau der Storage-Branche angepasst. Der Analyst Mark Peters von der Enterprise Strategy Group (ESG) hat Datacore zu Anfang diesen Jahres bescheinigt, mit seinem Software-Ansatz einen »andersartigen Zugang zu Speicher« geschaffen zu haben. Man war mit Speichervirtualisierung teilweise dem Markt um Jahre voraus, hatte es aber versäumt, in größerem Maße auf sich aufmerksam zu machen.

Für einen Hersteller, der bereits über ein Jahrzehnt mit seinem Kernprodukt bei etwa 6.000 Kunden weltweit präsent ist, ist man laut Peters relativ unbekannt. Doch habe man immerhin über 20.000 Lizenzen verkauft. Selbst die Partnerschaften mit Array-Herstellern von Dell bis zu IBM und Fujitsu konnten nicht zu mehr Aufmerksamkeit verhelfen. Peters kritisiert aber auch, dass Datacore zu wenig Gewicht auf Marketing gelegt habe.

Inzwischen ist Virtualisierung allgemein als Mittel anerkannt, die Produktivität bestehender IT-Infrastruktur zu erhöhen und die Kosten für die Geräteanschaffung bei Servern und Speichergeräten deutlich zu senken. Weil andere Anbieter zunächst wenig Programme für Speichervirtualisierung im Köcher hatten und zudem nun die Server-Virtualisierung eine Plattform auch für virtuelle Disk-Pools geschaffen hat, konnte Datacore in den letzten Jahren seine Marktanteile höher schrauben.

Besonders die funktionalen Verbesserungen und die Performance-Steigerung auf den Server-Plattformen, auf denen Datacores Software läuft, hatten positive Rückwirkungen. Je mehr Unternehmen den Einsatz von Virtualisierung ausdehnen, desto mehr könnten sie auch die Vorteile der Neuausrichtung ihrer Rechenzentren genießen, meint Peters von der ESG.

Mit der Durchsetzung von Server-Virtualisierung stellt sich erneut die Frage, welche IT-Prozesse und -Geräte zu einer Verlangsamung oder Behinderung der IT führen. Storage in seiner klassischen Ausführung steht schon seit Jahrzehnten weit oben auf einer solchen Liste möglicher Störfaktoren für Server- und besonders I/O-Aufgaben. Daten müssen eben nicht nur eingegeben oder verarbeitet, sondern sie wollen auch möglichst zuverlässig und sicher abgelegt werden. Mit anderen Worten: Datenspeicherung, Backup, Replikation und Restore oder Disaster-Recovery kosten nicht nur extra Geld, sondern beeinträchtigen mitunter extrem die Leistungsfähigkeit von Servern und Netzwerk. Jüngstes Beispiel in dieser Richtung ist die allseits gelobte Daten-Deduplikation, die aber sehr schnell Server und Netzwerk in die Knie zwingen kann.

Speicher orchestrieren

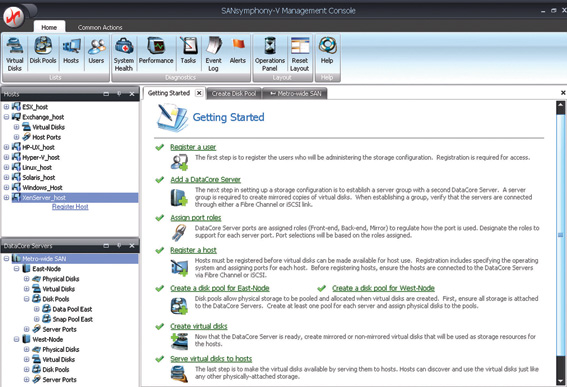

Die jetzt neu herausgekommene Version »SANsymphony V R8« berücksichtigt die genannten Painpoints der Anwender. So verfügt Sansymphony V R8 gegenüber den Vorgängerversionen über einen radikal neuen Ansatz für die GUI und stellt damit einen Schritt vorwärts für die Bedienbarkeit von SANs und der Integration von Komponenten in die Speicherumgebung dar. Wesentlich neue Features in Sansymphony V sind die voll integrierte Continuous-Data-Protection (CDP) und eine überarbeitete asynchrone Replikation, die bis zu 20 Mal schneller als die vorherige Implementierung arbeiten soll.Aktuell wird laut Alexander Best, Technical Business Development EMEA bei Datacore, an einer Erweiterung für den »Windows Home Server« (WHS) gearbeitet, so dass die neuen Funktionen auch für kleinere Umgebungen zur Verfügung stehen. Die Beta-Version ist bereits für Systemintegratoren verfügbar. Das Produkt nennt sich »Drive Harmony« und ist ein Ersatz für den »Windows Drive-Extender«, der in der aktuellen Version des WHS nicht mehr ausgeliefert wird.

Best unterstreicht besonders die Bedeutung des Vormarschs der Server-Virtualisierung: »Für Datacore ist dies ein wertvolles Zugpferd. Dadurch wurde Virtualisierung im Allgemeinen salonfähig: Der Ansatz, mit Standard-Hardware und Virtualisierungs-Software Hardware-Unabhängigkeit herzustellen und davon zu profitieren, wird nun auch für Storage verstanden. Die einst abgeschlossene SAN-Welt mit ihren Speicherboliden wurde aufgebrochen.« Die Vorteile der Speicher-Virtualisierung würden deshalb heute realistisch betrachtet und zum Einsatz gebracht. Die frühere Isolierung des Datacore-Ansatzes gelte nicht mehr.

Best führt aus, dass man bislang keine speziellen API-Features implementieren musste, da sich ja alle Funktionen für Speichervirtualisierung auf den regulären SCSI-Kommandosatz beziehen. Er fügt allerdings hinzu: »Die Einführung von `VMware VAAI´ (vStorage APIs for Array Integration) führt hier jedoch neue Spielregeln ein. Datacore wird mittelfristig VAAI unterstützen und somit noch besseren Support für Vmware bieten können als bisher.« Ob dies gelingt, wird davon abhängen, ob Vmware weiter in den Speicherbereich vordringen wird, um seine marktbeherrschende Stellung bei virtuellen Maschinen (VMs) abzusichern.

Die Konkurrenz schläft nicht

Bei Datacore gibt man sich trotz der zunehmenden Konkurrenz im Speichermarkt und der kaum noch zu zählenden Übernahmen optimistisch: Man besitze mit vielen der eigenen Features ein Alleinstellungsmerkmal und sehe »dem Wettbewerb heute gelassen entgegen«. Best ist sich sicher: »Als hart arbeitende, reine Software-Company sind wir um einiges flexibler und schneller als die `Dinosaurier´ und `Elefanten´ im klassischen Storage-Umfeld. Zudem haben wir seit über zehn Jahren diesen einzigen Fokus und damit eine äußerst ausgereifte Technologie.« Diese habe sich am Markt bewährt und sei an dessen Anforderungen kontinuierlich weiterentwickelt worden.

Fakt ist durchaus, dass man im Unterschied zum Wettbewerb auf Hardware-Unabhängigkeit setzen kann. Damit bietet man IT-Abteilungen einen großen Freiheitsgrad bei der Auswahl der Storage- und der Server-Hardware. Aus Kundensicht kommt Datacore oft dort zum Einsatz, wo es sich um einen transparenten Auto-Failover und das dazugehörige automatische Failback dreht. Die Art der Hardware und die Auswahl des Hardware-Herstellers muss dabei keine Berücksichtigung mehr erfahren.Durch die relativ frühe Festlegung auf Storage-Virtualisierung hat sich Datacore einen technologischen Vorteil gegenüber anderen Anbietern verschaffen können – zunächst im SAN-Umfeld, und jetzt bei Virtualisierung allgemein. Man hat rechtzeitig erkannt, dass Server-Virtualisierung und SAN direkt voneinander abhängen. Ohne Server-Virtualisierung ist ein SAN einfach nur eine Alternative zu klassischen SCSI- oder SAS- Verbindungen, letztlich nur eine unkoordinierte Ansammlung von Block-Level-Storage mit Netzwerkzugang.

Jedes Unternehmen, das sich heute mit dem Thema Virtualisierung im Storage-Bereich beschäftigt, braucht eigentlich auch eine Virtualisierung der Server- und PC-Landschaft. Ohne eine solche allgemeine Umrüstung ist die IT-Infrastruktur nur halbherzig virtualisiert. Wenn Unternehmen lediglich ein SAN mit virtuellen Pools nutzen, lassen sie einen Großteil der mit Virtualisierung erzielbaren wirtschaftlichen Vorteile brach liegen. Die Kosten für eine herkömmliche Shared-Storage-Lösung, die Hochverfügbarkeit und Performance leisten muss, können enorm sein und komplette Virtualisierungs-Projekte aushebeln. Datacore ist es gelungen, sich hier mit einer glaubwürdigen Lösungsalternative zu positionieren – zumindest solange, bis einer der großen Speicherhechte im Teich zuschnappt.

Neue Funktionen sind:

- intuitive, konfigurierbare GUI

- Workflow-Integration und -Automation

- automatische Wizards

- aufgabenorientiertes Design

- konsolidierte Statistiken / Events über alle Knoten hinweg

- automatisiertes Support-Paket

- einfachere Lizenzierungsstruktur