Von Hochverfügbarkeit & Zero-Minute-Recovery – ein Rant

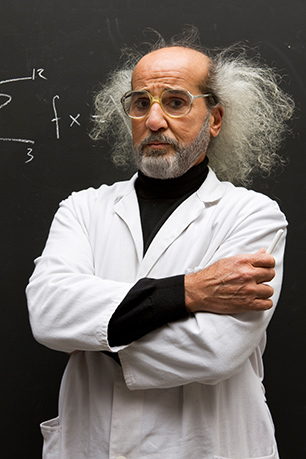

Unserem Doc schwillt mal wieder der Kamm. Dass die Hersteller immer irgendwie gehörig auf den (Marketing-)Putz hauen, ist bekannt und nichts Neues. Doch speziell beim Thema Verfügbarkeit und Recovery, wenn es um wichtige Unternehmensdaten geht, muss nach der Ansicht unseres Docs einiges zurechtgerückt werden

Meinung Doc Storage:

Liebe Leser,

nun, da die EDV-Karnevalsveranstaltungen durch sind, sei es mir erlaubt, hier einmal meine Kopfschmerzen loszuwerden. Nicht, dass man es anders erwartet hätte, aber auf allen Messen, Konferenzen und – ich liebe dieses Wort – Summits wurde wieder über so viel Unnötiges geredet und so viel unmögliches und überflüssiges versprochen, dass hier einmal über die gröbsten drei Schnitzer geredet werden muss.

1. 100 Prozent Verfügbarkeit

Ich hatte ja, naiv wie ich nun einmal bin, gehofft, dass das Thema »100 Prozent Verfügbarkeit« ausreichend diskutiert und als Mumpitz zu den Akten gelegt worden ist. Aber ich wurde wieder einmal eines besseren belehrt. Kaum hatten wir alle Speicherhersteller (bis auf den einen roten aus Japan) davon überzeugt, dass von Menschenhand gemachte Systeme niemals hundertprozentig verfügbar sein können, steigt diese Chimäre aus den tiefschwarzen Kellern der Marketingabteilungen wieder herauf.

Nun sollen auf einmal Cloud-Umgebungen auf 100 Prozent getrimmt sein, dem Nutzer die Daten in diesen Blasen immer verfügbar gemacht und ohne jeglichen Ausfall bereitgestellt werden. Aufmerksame Leser dieser Publikation werden sogar entsprechende Angebote von Herstellern finden, und diese sind nicht Jahre alt, sondern stammen aus dieser Woche. Dem interessierten Nutzer und potentiellen Kunden soll durch allerlei professionell klingende Anglizismen wie Dashboard-Reporting und Remote-Monitoring, oder durch lustige scheinfachliche Verschwurbelungen wie prädikative Analysen, intelligenten Lernalgorithmen, proaktiven Vorfallerkennungen und einigem mehr der Zaubertrick plausibel gemacht werden.

Schön und gut – die Speicherumgebung der Wolke mag hiermit lückenlos überwacht und eventuelle Fehler schon vor ihrem Auftreten geahnt werden können. Was ist allerdings mit dem Zugang zu dieser Umgebung? Mit den Netzen des Anwenders, denen der Weitverkehrsanbieter und den mannigfaltig dazwischengeschalteten LAN- und WAN-Geräten? Fällt auch nur eines davon aus, ist es Essig mit den hundert Prozent. Baggert irgendwo eine gelangweilte Fachkraft mit ihrem gelben Stahlberg ein zu breites oder zu tiefes Loch, war es das mit dem Zugang. Man mag noch dutzende solcher Szenarien kennen, alle laut Anbietern dermaßen unwahrscheinlich, dass sie »einmal in x Jahrhunderten« vorkommen. Aber sie kommen vor. Und die Jahrhunderte werden komischerweise immer kürzer, je komplexer die entsprechenden Umgebungen werden.

Also hört mir auf mit den hundert Prozent, erzählt den Leuten bitte, was sie wirklich zu erwarten haben.

2. Produktionsaufnahme in Null Minuten

Auch hier schwillt mir die ganz dicke Ader. Vor zehn, ach was, vor fast zwanzig Jahren kamen synchron geschalteten Speichersystemen in den Markt. Den Nutzern wurde gesagt, dass sie unter bestimmten Voraussetzungen die an einem Standort ausgefallene Produktion mit demselben Datenbestand an einem anderen Ort in kürzester Zeit wiederaufnehmen können. Man bedenke, dass damals alle Speichergeräte in den Rechenzentren unter derselben Herrschaft und – meistens – sehr gut koordiniert aufgebaut und konfiguriert waren. Die Leitungen waren redundant, auch wenn das bei den vom rosa Riesen und seinen Konkurrenten aufgerufenen Preisen meist mehr kostete als die ganzen Festplattenberge zusammen. Das Schwenken der Produktion wurde monate-, wenn nicht jahrelang konzeptioniert, K-Fall-Handbücher mit den entsprechenden Verfahren waren dicker als Krieg und Frieden. Und wenn man Glück hatte, ich meine wirklich Glück, war man am kommenden Werktag woanders wieder oben.

Jetzt kommen Hersteller aus der hecke und wollen den potentiellen Kunden erzählen, mit ihrer Hilfe könnten sie – ich liebe Englisch – Zero-Minute-Recovery machen. Will sagen, sie könnten in derselben Minute, in der ihre Speicherumgebung das zeitliche gesegnet hat, ohne weitere Einschränkungen auf dieselben Datenbestände in irgendeiner Wolke zugreifen, mit denselben Nutzerberechtigungen und dem exakt selben Datenbestand. Auch diese Hersteller können offensichtlich zaubern. Mal ganz abgesehen davon, dass der Zugriff auf die Daten in der Wolke um Faktoren langsamer sein dürfte als der auf die lokalen Platten, tun die Mitarbeiter während der Bürostunden nämlich alles dafür, dass dieses Konzept zum Scheitern verurteilt ist.

Diese kleinen garstigen Wesen öffnen nämlich Dateien direkt vom zentralen Speicher, bearbeiten diese und speichern sie dort wieder ab. Fällt während dieser normalen Arbeitsweise allerdings der zentrale Speicher aus, aus welchem Grund auch immer, sind alle zu dieser Zeit geöffneten Dateien im besten Falle auf der anderen Seite auf dem alten Stand, im schlimmsten Falle korrupt, weil als »geöffnet« markiert. Im besten Falle müssen also alle Mitarbeiter mit ihrer Arbeit an den zentral abgelegten Daten neu beginnen. Das heißt, es geht nur die Arbeit von ein paar Minuten oder einigen Stunden verloren. Im schlimmsten Falle muss der Backup-Mensch erst einmal die Altstände aus der Nacht oder von wann auch immer zurückholen – wenn er Glück hat aus einem B2D-Image, wenn er Pech hat… naja, das wissen wir alle.

Es gibt nach einem Ausfall eines zentralen Speichers keine Produktionsaufnahme in Null Minuten, das ist völliger Blödsinn. Technisch vielleicht, mit sehr, sehr vielen wenn's und abers, aber organisatorisch mit Sicherheit nicht.

So, und jetzt können mich wieder die üblichen Verdächtigen auf den Scheiterhaufen stellen, anzünden und aktuelle Marketing-Phrasen singend um mich herumtanzen. Aber bei eventuellen Zuschriften immer schön dran denken: sachlich bleiben, ich bin es auch.

Und kommende Woche geht mit dem Thema Flash weiter. Flash spart Zeit!? Ja! Aber…

Lieben Gruß

Doc Storage