Höhere Datendichte in Festplatten fordert Datenretter heraus

Die zunehmenden Datendichten bei Festplatten bewirken, dass bei einem Headcrash mehr Sektoren irreparabel beschädigt werden. Also möglicherweise nicht alle Daten via Datenrettung gerettet werden können. Unter diesem Gesichtspunkt sollte der persönliche Backup-Plan die allerhöchste Prämisse haben.

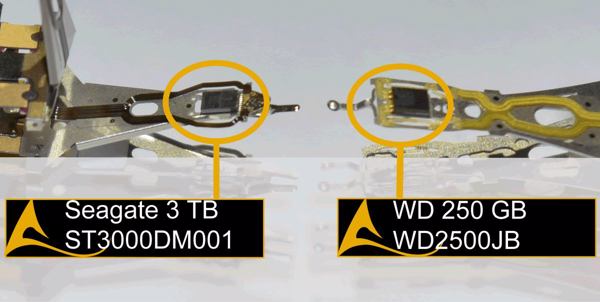

Nur marginale Unterschiede beim Schreib-Lese-Kopf einer moderneren Seagate-Festplatte und einer etwas älteren WD-Festplatte (Bild: Kuert Datenrettung)Betrachtet man die Entwicklung bei der Datendichte von Festplatten, so lässt sich feststellen, dass es in den letzten Jahren zwar gelungen ist, die Dichte zu erhöhen, jedoch die Flächen eines Schreib-Lese-Kopfes hierbei im Verhältnis zur Datendichte nur marginal reduziert wurden. Für die Datenrettung ist dies nun nach Angaben von Kuert Datenrettung zunehmend ein Problem, denn mit steigender Datendichte wird im Falle eines Headcrashs der Festplatte auch eine höhere Anzahl an Sektoren irreparabel beschädigt, die in diesen in diesen beschädigten Bereichen liegen.

Nur marginale Unterschiede beim Schreib-Lese-Kopf einer moderneren Seagate-Festplatte und einer etwas älteren WD-Festplatte (Bild: Kuert Datenrettung)Betrachtet man die Entwicklung bei der Datendichte von Festplatten, so lässt sich feststellen, dass es in den letzten Jahren zwar gelungen ist, die Dichte zu erhöhen, jedoch die Flächen eines Schreib-Lese-Kopfes hierbei im Verhältnis zur Datendichte nur marginal reduziert wurden. Für die Datenrettung ist dies nun nach Angaben von Kuert Datenrettung zunehmend ein Problem, denn mit steigender Datendichte wird im Falle eines Headcrashs der Festplatte auch eine höhere Anzahl an Sektoren irreparabel beschädigt, die in diesen in diesen beschädigten Bereichen liegen.

Jüngst präsentierte beispielsweise der Hersteller Seagate mit der ST2000LM009 eine 2 TByte große Festplatte mit einer Datendichte von 1 TByte pro Magnetscheibe. Das bedeutet aber für den Anwender laut Kuert, dass auch er sich genau vor Augen halten sollte, wofür er Festplatten einsetzen will, welche Daten er darauf speichern will, und welchen Wert er diesen Daten bemessen will.

Datenrettung kann nicht zaubern

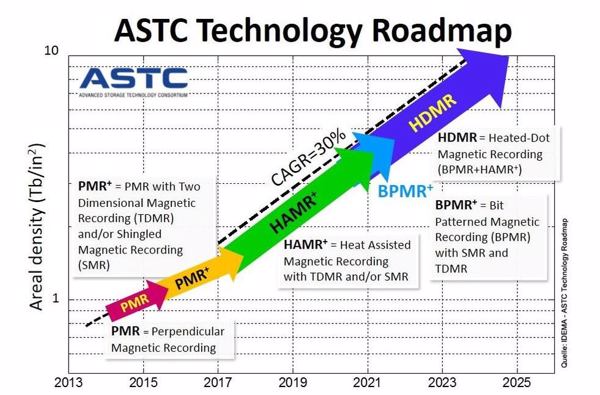

Die Datendichten werden weiterhin zunehmen – Auswirkungen eines Headcrashs werden aber erheblicher (Bild/Quelle: ASTC)»Im Falle unersetzlicher Daten sollte jeder Anwender sich vor Augen halten, dass herstellerseitige Marketingversprechen zur Lebensdauer von Festplatten keine Garantie für die Ausfallsicherheit einer Festplatte darstellen«, sagt Martin Eschenberg, CMO bei Kuert Datenrettung in Bochum. »Hier gilt, dass jeder selbst zusehen muss, wo er bleibt und für sich die ideale und bestenfalls automatisierte Lösung sucht, um diese unersetzlichen Daten regelmäßig auf verschiedenen Speicherorten und Speicherarten abzulegen.«

Die Datendichten werden weiterhin zunehmen – Auswirkungen eines Headcrashs werden aber erheblicher (Bild/Quelle: ASTC)»Im Falle unersetzlicher Daten sollte jeder Anwender sich vor Augen halten, dass herstellerseitige Marketingversprechen zur Lebensdauer von Festplatten keine Garantie für die Ausfallsicherheit einer Festplatte darstellen«, sagt Martin Eschenberg, CMO bei Kuert Datenrettung in Bochum. »Hier gilt, dass jeder selbst zusehen muss, wo er bleibt und für sich die ideale und bestenfalls automatisierte Lösung sucht, um diese unersetzlichen Daten regelmäßig auf verschiedenen Speicherorten und Speicherarten abzulegen.«

Anwender sollten sich nach Meinung von Eschberg verstärkt fragen: Sind die Daten ersetzlich oder unersetzlich? Denn je höher die Datendichte einer ausgefallenen Festplatte ist, desto höher ist auch der anzusetzende Arbeits- und Zeitaufwand bei einer Datenrettung. Die Datendichte steht hierbei in einer direkten Korrelation zum jeweiligen Fehler, und natürlich auch zu den entsprechenden Kosten zur Datenrettung sowie dem Erfolg der Rettung.

HGST-Studie ergab: Je kleiner die Festplatten-Bauform, desto kürzer der Lebenszyklus

Und der Datenrettungserfolg steht auch, wenn man Hitachi-Zahlen glauben schenken möchte, in einer direkten Beziehung zur Lebensdauer einer Festplatte. Denn Studien des Herstellers Hitachi/HGST würden eine Korrelation zwischen fortschreitender Miniaturisierung und der durchschnittlichen Lebensdauer von Festplatten belegen, nach der Kurzformel: Je kleiner die Festplatten-Bauform, desto kürzer der Lebenszyklus. HGST-Studie hätten ergeben, dass eine 5,25-Zoll-Festplatte 15 bis 20 Jahre, ein 3,5-Zoll-Modell zehn bis 20 Jahre, aber eine 2,5-Zoll-Festplatten nur noch durchschnittlich zehn Jahre.

Doch wie definiert sich »Erfolg« für Rettungslabore? Diese definieren nach Einischätzung von Eschenberg Erfolg oder Erfolgsquoten unterschiedlich: »So finden sich Aussagen wie ‚99 Prozent Erfolgsquote’, jedoch ohne hierauf einen speziellen Bezug zum Medium, zur Kundenzufriedenheit oder zur Anzahl zu nehmen.« Labore, die es etwas kundenfreundlicher und transparenter gestalten, würden ihren »Erfolg« im Sinne von durch den Kunden angenommenen Datenrettungsfällen definieren. Also dessen, dass gerettet wurde, was der Kunde haben auch gerettet haben wollte. »Dass die Quoten hierbei naturgemäß deutlich niedriger, aber natürlich auch realistischer sind, versteht sich von selbst«, betont Eschenberg.

Die Angabe von Erfolgsquoten ist nach Meinung des Kuert-Managers ein Marketingmerkmal, denn retten könne man in den meisten Fällen etwas, selbst dann wenn es nur zwei unstrukturierte Zeilen eines Windows-Ereignisprotokolls sind. Aus Sicht des Kunden sei dies dann zwar Misserfolg, aus Sicht des Marketings betreffender Labore jedoch ein Erfolg, wenn auch schöngerechnet.

Trotz neuer Festplatten-Technologien – unbedingt Backup machen

Zukünftige Festplattengenerationen beinhalten Technologien wie HAMR (Heat Assisted Magnetic Recording), HDMR (Heat Dot Magnetic Recording) oder TDMR (Two Dimensional Magnetic Recording) stellen neue Herausforderungen für Labore dar, die es zunächst einmal allesamt in den Griff zu kriegen gilt. Folgt man jedoch den Entwicklungen der letzten Jahre, so werden auch zukünftig die gleichen Mechanismen und Korrelationen greifen wie in der Vergangenheit.

Für die Anwender sollte zukünftig, entgegen aller Technologie, die Backup-Disziplin und der persönliche Backup-Plan die allerhöchste Prämisse haben. Denn jede physikalische Beschädigung einer Plattenoberfläche steht zukünftig in einem direkten Zusammenhang mit der Datendichte pro Scheibe – stärker noch als dies in den vorausgegangenen Jahren der Fall war.