Cohesity: »Sekundärdaten sind wichtiger als primäre Daten«

Laut einer aktuellen Studie des Beratungshauses IDC stellt die Modernisierung der Rechenzentrums- und Storage-Landschaft den wichtigsten Erfolgsfaktor für die Umsetzung der digitalen Transformation in Unternehmen dar. Hierfür bieten sich insbesondere hyperkonvergente Systeme an, bei denen Prozessoren, Speicher und Netzwerk auf Basis eines Software-orientierten Ansatzes integriert und diese als Software oder Appliance bereitgestellt werden. Solche Systeme sind meist auch Bestandteil einer Software-defined Infrastructure, bei der virtualisierte Workloads automatisiert und unabhängig von der vorhandenen IT-Infrastruktur aus Servern, Storage-Systemen und Netzwerk bezogen werden.

Das Start-up Cohesity hat sich auf Speichersysteme für sekundäre Daten spezialisiert, die im Durchschnitt rund 80 Prozent der gesamten Daten in einem Unternehmen ausmachen. Nur mit einer solchen Technologie lässt sich ein einheitlicher Datenraum im Unternehmen schaffen, ist Klaus Seidl, Vice President of Sales bei Cohesity, überzeugt. Der neue EMEA-Chef erklärt, wie er das Start-up im EMEA-Raum positionieren möchte. Und er führt aus, warum sekundäre Daten wichtiger sind als primäre und wie sich der Storage-Markt in den nächsten Jahren entwickeln wird.

Herr Seidl, Sie verantworten seit einigen Monaten als neuer Vice President of Sales das EMEA-Geschäft von Cohesity. Was hat Sie zu diesem US-amerikanischen Start-up geführt? Wie möchten Sie Ihre Marktpräsenz im DACH- und EMEA Raum erhöhen, und welche Zielmärkte adressieren Sie?

Klaus Seidl, Cohesity (Foto: Stefan Girschner)Seidl: Im Jahr 2013 war ich der erste Mitarbeiter des Start-ups SimpliVity in Europa und habe dann als VP Sales EMEA bis Oktober 2017 das Geschäft in Europa aufgebaut, das unter meiner Leitung auf über 100 Mitarbeiter anwuchs, 23 Länderniederlassungen beinhaltete und zuletzt auf Augenhöhe mit den Umsätzen in USA war. Bei Simplivity erfolgte der Markteintritt in Europa annähernd zeitgleich mit dem in den USA.

Klaus Seidl, Cohesity (Foto: Stefan Girschner)Seidl: Im Jahr 2013 war ich der erste Mitarbeiter des Start-ups SimpliVity in Europa und habe dann als VP Sales EMEA bis Oktober 2017 das Geschäft in Europa aufgebaut, das unter meiner Leitung auf über 100 Mitarbeiter anwuchs, 23 Länderniederlassungen beinhaltete und zuletzt auf Augenhöhe mit den Umsätzen in USA war. Bei Simplivity erfolgte der Markteintritt in Europa annähernd zeitgleich mit dem in den USA.

Anders bei Cohesity: Das 2013 gegründete Start-up verfolgt eine schrittweise Erschließung der Märkte, also zunächst die amerikanische Westküste, dann die gesamte USA und seit einem Jahr die EMEA-Region. Für eine verstärkte Marktpräsenz setzen wir auf ein hundertprozentiges Partnermodell und werden hierzu ein eigenes Channel-Geschäft aufbauen, unterstützt durch lokale Vertriebsteams in den einzelnen Ländern und Regionen. In zwei bis drei Jahren soll dann der Umsatzanteil der EMEA-Region bei rund 40 Prozent am weltweiten Umsatz liegen. Mit unserer Storage-Technologie wollen wir Unternehmen Funktionalitäten anbieten, wie sie vor allem bei Cloud-Providern zu finden sind. Dank der Scale-out-Architektur kann der Anwender selbst entscheiden, ob er die Speicherlösung im eigenen Haus oder bei einem externen Provider betreibt. Zudem lassen sich dann auch flexibel vorhandene Infrastruktur-Kapazitäten auslagern.

Storage-Systeme und das 3-Schichten-Modell

Welche Rolle spielt bei Speichersystemen die 3-Schichten-Architektur?

Seidl: Gemäß der drei-Schichten-Software-Architektur befinden sich im Tier-1 die Benutzerschnittstellen und im Tier-2 die direkt damit verbundenen Applikationen. Im Tier-3, der Datenhaltungsschicht, werden die Daten gespeichert und geladen. In dieser Schicht findet demnach auch die Datenarchivierung statt. Im Nachfolgenden möchte ich von einem 2-Schichten-Modell ausgehen, bei dem Tier-1 und Tier-2 zu einer Schicht zusammengefasst werden.

Die Herausforderung für Anwender ist es nun, auf Basis dieser Systemarchitektur Big-Data-Anwendungen und andere Datenanalyse-Lösungen nutzen zu können. Hinzu kommt der erhöhte Bedarf nach Test- und Entwicklungsumgebungen, für die ebenfalls Daten aus der 2. Schicht, also Tier-2 benötigt werden. Ähnlich wie bei einem Eisberg, bei dem nur die Spitze sichtbar ist, werden von sämtlichen gespeicherten Daten nur rund 15 bis 20 Prozent genutzt, und sind somit aktive Daten. Die (nicht sichtbare) große Mehrheit der sekundären Daten von 80 bis 85 Prozent stellte bisher eine Art Versicherung für den Anwender dar, diente also vor allem für Backup- und Archivierungszwecke.

Passive Daten nutzbar machen

Wie wirkt sich nun der technologische Ansatz von Cohesity aus, die passiven Daten nutzbar zu machen?

Klaus Seidl, Cohesity (Foto: Stefan Girschner)Seidl: Unser Ansatz ist es nun, dass alle Daten in einer einzigen Umgebung abgespeichert werden und diese Daten für Anwendungen mehrfach genutzt werden können. Wir sprechen dabei von dem »Second Usage«, also die Daten nicht nur speichern, sondern auch wieder benutzen zu können. Dieser Ansatz dient in erster Linie dem Testen und der Entwicklung von Software, zum Beispiel einem SAP-System, ist aber auch wichtig für die Datenarchivierung und -wiederherstellung. Hierbei ist erwähnenswert, dass sich Mohit Aron, der Gründer und CEO von Cohesity, längere Zeit unter anderem mit der Entwicklung des Google-File-Systems beschäftigt hat, was eine Alternative darstellt, die Daten einfach nur auf Bänder zu schreiben und dann wieder auszulesen.

Klaus Seidl, Cohesity (Foto: Stefan Girschner)Seidl: Unser Ansatz ist es nun, dass alle Daten in einer einzigen Umgebung abgespeichert werden und diese Daten für Anwendungen mehrfach genutzt werden können. Wir sprechen dabei von dem »Second Usage«, also die Daten nicht nur speichern, sondern auch wieder benutzen zu können. Dieser Ansatz dient in erster Linie dem Testen und der Entwicklung von Software, zum Beispiel einem SAP-System, ist aber auch wichtig für die Datenarchivierung und -wiederherstellung. Hierbei ist erwähnenswert, dass sich Mohit Aron, der Gründer und CEO von Cohesity, längere Zeit unter anderem mit der Entwicklung des Google-File-Systems beschäftigt hat, was eine Alternative darstellt, die Daten einfach nur auf Bänder zu schreiben und dann wieder auszulesen.

Unsere Speichertechnologie unterstützt die Verwendung von Big-Data- und Hadoop-Anwendungen, wodurch die Datenmengen auf Tier-2 durchsuchbar sind und auch entsprechende Regeln, also »Smart Constraints« hinterlegt werden können. So ist es beispielsweise nicht möglich, die in herkömmlicher Form auf Tier-2 gespeicherten Daten regelkonform mit der EU-DSGVO zu löschen. Wenn man dabei berücksichtigt, mit welcher Geschwindigkeit die Daten in dieser Schicht wachsen, ist es enorm wichtig für Unternehmen, ihren »Datenhaushalt« in Ordnung zu halten. Es reicht heute nicht mehr, nur ständig die Speicherkapazitäten für die Daten zu vergrößern, verbunden mit der Hoffnung, diese später auch noch auslesen zu können.

Verwaltung sekundärer Daten nicht vernachlässigen

Warum sollten Anwender ihre klassischen Speichersysteme modernisieren?

Seidl: Der Markt für neue, innovative Speichersysteme ist sechs bis sieben Mal so groß wie der klassische Storage-Markt, wo die letzte Innovation vielleicht vor 20 Jahren stattfand. Ziel muss es sein, die Deduplizierung und Replikation von Daten mit möglichst hoher Effizienz zu erreichen. Dadurch eröffnen sich ganz neue Möglichkeiten bei der aktiven Speichernutzung, für die keine zusätzlichen Platten benötigt werden, so auch keine Kopien der Daten. Mithilfe einer hyperkonvergenten Speicherarchitektur können Unternehmen ihre bisher nur für Backup und Archivierung genutzten Datensammlungen »Google-fähig«, also durchsuchbar machen und erst dadurch Big-Data- und IoT-Anwendungen für den Geschäftserfolg nutzen. Damit werden abgekühlte, sekundäre Daten von gestern zu aktiven Daten von heute. Wir müssen also den häufig anzutreffenden Datenwust bei den Anwendern in ein optimiertes Daten-Management verwandeln.

Bisher ist es so, dass die Mehrzahl der hyperkonvergenten Storage-Lösungen von Anbietern wie HPE, Nutanix oder Simplivity das Daten-Management von primären Daten zum Ziel hat. Inzwischen ist dieser Markt von den Anbietern stark umkämpft, der Markt für Speichersysteme von sekundären Daten jedoch eher vernachlässigt und mit Sicht auf die Datenmengen eigentlich der größere Markt. In den letzten fünf Jahren kamen immer mehr Anbieter mit speziellen IT-Infrastrukturlösungen für die Datenanalyse in den Markt, wie zum Beispiel Cloudera oder MapR. Infolge dieses Analytics-Hypes werden jetzt auch immer mehr Data-Scientists gesucht.

Wie unterscheidet sich die Storage-Lösung von Cohesity im Vergleich zu denen Ihrer Mitbewerber?

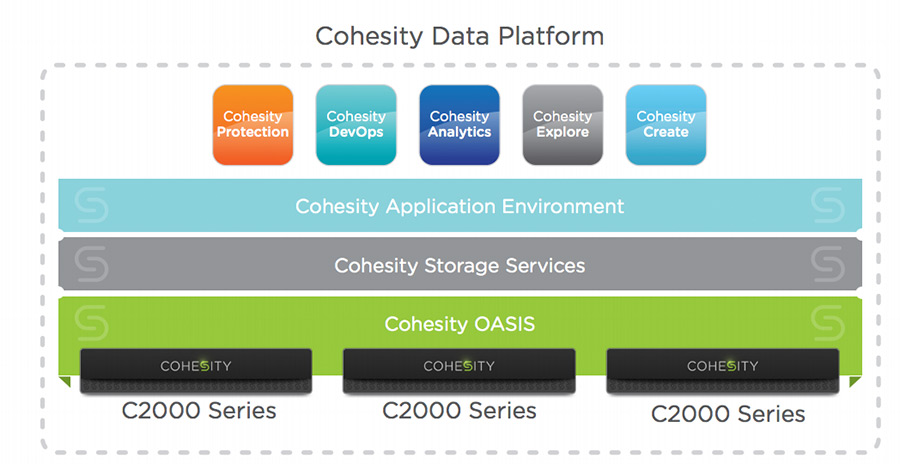

Die »DataPlatform« enthält verschiedene Anwendungen, wie Datenschutz, DevOps, Analytics und basiert auf hyperkonvergenten Speichersystemen wie der C2000-Serie (Grafik: Cohesity).Seidl: Unsere DataPlatfom sorgt dafür, dass die Daten zentral gesammelt und verwaltet werden, sodass diese jederzeit auffindbar und durchsuchbar sind. Die Lösung bieten wir On-Premise – Software only (aktuell auf Basis von Cisco oder HPE), als hochskalierbare Appliance oder als Cloud-Edition (Multi-Cloud-Lösung) an. Seit November 2017 ist die Cloud-Edition auch für die AWS-Plattform verfügbar. Entscheidend ist: Unsere Lösung versteht ein Administrator innerhalb von zehn Minuten und deshalb ist sie auch sehr schnell installiert.

Die »DataPlatform« enthält verschiedene Anwendungen, wie Datenschutz, DevOps, Analytics und basiert auf hyperkonvergenten Speichersystemen wie der C2000-Serie (Grafik: Cohesity).Seidl: Unsere DataPlatfom sorgt dafür, dass die Daten zentral gesammelt und verwaltet werden, sodass diese jederzeit auffindbar und durchsuchbar sind. Die Lösung bieten wir On-Premise – Software only (aktuell auf Basis von Cisco oder HPE), als hochskalierbare Appliance oder als Cloud-Edition (Multi-Cloud-Lösung) an. Seit November 2017 ist die Cloud-Edition auch für die AWS-Plattform verfügbar. Entscheidend ist: Unsere Lösung versteht ein Administrator innerhalb von zehn Minuten und deshalb ist sie auch sehr schnell installiert.

Der von mir gern benutzte Begriff »Copy Data Management« verdeutlicht, dass sich mit wenigen Mausklicks Datenmengen mit einer Größe von mehreren PBytes verwalten und Routineaufgaben wie Backup und Archivierung einfach durchführen lassen. Außerdem stellt unsere Data-Platform durch die Schaffung eines konvergenten Datenspeichers eine skalierbare Test- und Entwicklungsumgebung sowie Funktionen für die Datenanalyse bereit.

Storage- und IT-Umgebung erfolgreich modernisieren

Welcher Weg führt zu einer erfolgreichen Modernisierung der Storage- und IT-Umgebung?

Die »DataPlatfom«-Lösung bietet Cohesity On-Premise oder als hochskalierbare Appliance an (Bild: Cohesity).Seidl: Natürlich müssen wir uns bei einer neuen Installation nach den Erneuerungszyklen und dem Budget des jeweiligen Kunden richten. Entscheidend ist jedoch, nicht eine weitere Insellösung einzurichten, sondern neue Wege beim Daten-Management einzuschlagen. Hierbei ist es auch wichtig, die Fachabteilungen schon bei der Lösungsberatung einzubeziehen, da diese häufig unzufrieden sind mit der vorhandenen IT-Infrastruktur und sich daher Cloud-Lösungen wünschen. Nach unserer Einschätzung haben jedoch meist beide Lösungsansätze, also On-Premise und Cloud, ihre Existenzberechtigung. Dies ist vergleichbar mit einer Person, die eine Wohnung oder ein Haus besitzt und hin und wieder in einem Hotel übernachtet, wo sie das Zimmer aber nur mietet.

Die »DataPlatfom«-Lösung bietet Cohesity On-Premise oder als hochskalierbare Appliance an (Bild: Cohesity).Seidl: Natürlich müssen wir uns bei einer neuen Installation nach den Erneuerungszyklen und dem Budget des jeweiligen Kunden richten. Entscheidend ist jedoch, nicht eine weitere Insellösung einzurichten, sondern neue Wege beim Daten-Management einzuschlagen. Hierbei ist es auch wichtig, die Fachabteilungen schon bei der Lösungsberatung einzubeziehen, da diese häufig unzufrieden sind mit der vorhandenen IT-Infrastruktur und sich daher Cloud-Lösungen wünschen. Nach unserer Einschätzung haben jedoch meist beide Lösungsansätze, also On-Premise und Cloud, ihre Existenzberechtigung. Dies ist vergleichbar mit einer Person, die eine Wohnung oder ein Haus besitzt und hin und wieder in einem Hotel übernachtet, wo sie das Zimmer aber nur mietet.

Neue Technologien wie IoT, Sensortechnik, künstliche Intelligenz oder maschinelles Lernen verdanken wir vor allem der stark verbesserten Compute-Leistung der Server, die für den Anwender auch bezahlbar ist. Und damit sind wir auch wieder bei der Datenspeicherung: Ohne vollständig durchsuchbare Datenpools und ein intelligentes Copy-Data-Management, führen die disruptiven Digitalisierungs-Technologien nicht zum Erfolg.

- Cohesity: »Sekundärdaten sind wichtiger als primäre Daten«

- Storage-Systeme und das 3-Schichten-Modell

- Passive Daten nutzbar machen

- Verwaltung sekundärer Daten nicht vernachlässigen

- Storage- und IT-Umgebung erfolgreich modernisieren