»IDC Cloud Summit 2017«: Rückblicke, Impressionen, Interviews

Die Cloud-Welle hat nun auch Deutschland erfasst. Und das bringt viele Facetten mit sich. Zum einen gibt es den massiven Umstieg auf die Hybrid-Cloud – und parallel zeichnet sich bereits die Multi-Cloud ab. Der Drang in die Cloud ist so stark, dass nun auch hierzulande erste Unternehmen mit einer Cloud-First-Strategie unterwegs sind. Nachbericht vom »IDC Hybrid Cloud Summit 2017« in Frankfurt.

Und so zeichnet sich bereits die Multi-Cloud ab. Sie scheint, da bereits viele Firmen damit erste Erfahrungen gemacht haben, sich relativ schnell durchzusetzen. »Mehr als 70 Prozent werden in Europa 2018 Multi-Cloud-Umgebungen betreiben«, erwartet Giorgio Nebuloni, Associate Research Director bei IDC Central Europe, kürzlich auf dem »IDC Hybrid Cloud Summit 2017« in Frankfurt. Der Einsatz von Cloud-Computing dürfte somit eine grundlegende Antwort auf die Digitalisierung sein, die 52 Prozent der Unternehmen als eine zentrale Herausforderung sehen.

Und damit kommt IDC in einer kurz zuvor veröffentlichten Studie zu dem Schluss: Eine Cloud-Transition ist auf den Weg gebracht, die Cloud-Disruption ist nun hierzulande in vollem Gange. Eine erfolgreiche Cloud-Transition basiert demzufolge auf einer strukturierten Vorgehensweise zur Umsetzung von Cloud-Initiativen, die neben einer technischen Sicht auf Cloud-Services und Cloud-Technologie auch Prozesse und organisatorische Aspekte berücksichtigt.

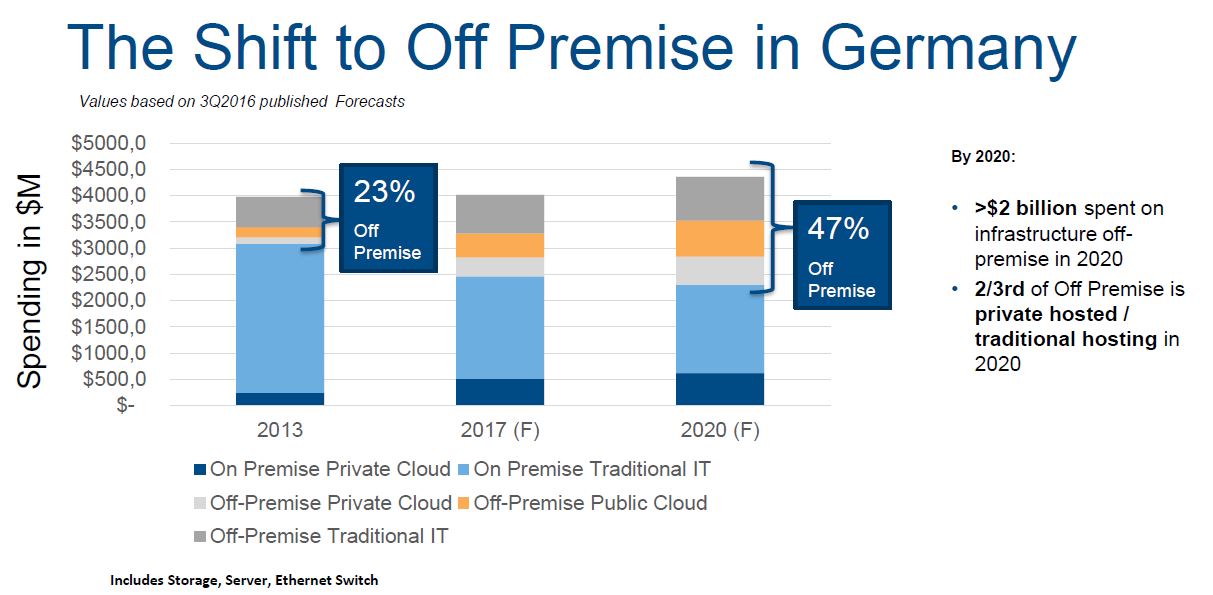

In Investitions-Budgets sieht das dann so aus, dass bis 2020 mindesten 35 Prozent der Ausgaben für IT-Neuinvestitionen Cloud-basierend sein werden. Die Ausgaben in die klassischen Non-Cloud-Investitionen werden indes auf hohem Niveau flach bleiben, bzw. allenfalls nur leicht abnehmen.

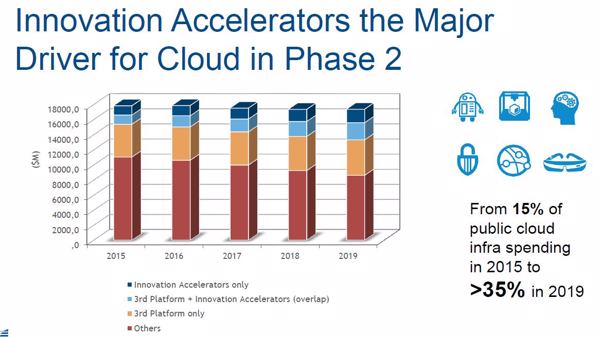

Über neue Workloads, die nun langsam immer mehr in die Cloud verlagert werden, sprachen wir auch mit Georgio Nebuloni in Frankfurt. Der IDC-Analyst spricht im speicherguide.de-Video-Interview unter anderem darüber, welche Beschleunigungsfaktoren es gibt, dass die Cloud nun zum Mainstream wird.

DARZ positioniert ihre Hybrid-Cloud für KRITIS-Organisatonen

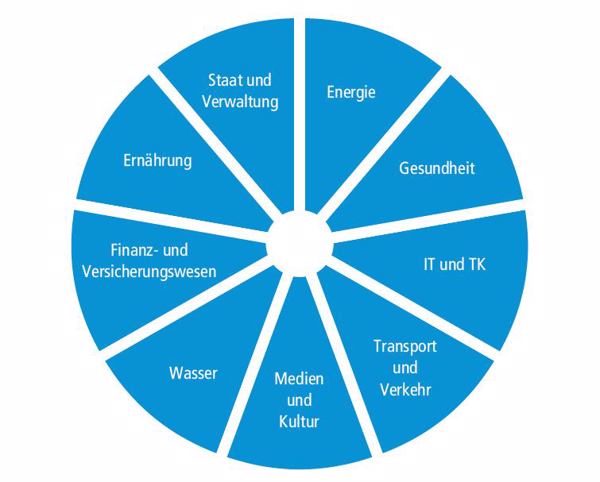

Hierbei können Lösungen basierend auf der Hybrid-Cloud helfen. Welche das sind, erläutert uns Lars Göbel, Leiter Strategie beim DARZ (Darmstädter Rechenzentrum), im Video-Interview mit speicherguide.de. Denn das Datacenter des DARZ ist in dem ehemaligen Gebäude der hessischen Landesbank untergebracht – und damit gilt es als das hochsicherste Datacenter in Europa. Und damit ist es eigentlich prädestiniert für das Auslagern kritischer Infrastrukturen. »Gerade für Unternehmen und Organisationen aus dem KRITIS-Bereich können wir Cloud-Infrastrukturen auf zertifiziertem Niveau realisieren«, betont Göbel. (Ein Strategiepapier zu KRITIS vom DARZ finden Sie hier.)

Was die von KRITIS betroffenen Organisationen konkret tun müssen, ist bislang noch nicht im Detail geklärt. Fest steht, dass gravierende IT-Sicherheitsvorfälle dem BSI gemeldet werden müssen und dass ein Ansprechpartner für IT-Sicherheitsfragen ernannt werden muss. Zwei sehr entscheidende Aspekte des IT-Sicherheitsgesetzes sind leider immer noch sehr schwammig ausgelegt. Zum einen geht es um die Frage, welche Teile der eigenen IT-Infrastruktur konkret kritisch einzustufen sind und wie der geforderte Stand der Technik in Bezug auf IT-Sicherheit erlangt werden kann. Hierzu geben weder die Vorschriften noch die Verordnung oder auch das Gesetz Auskunft.

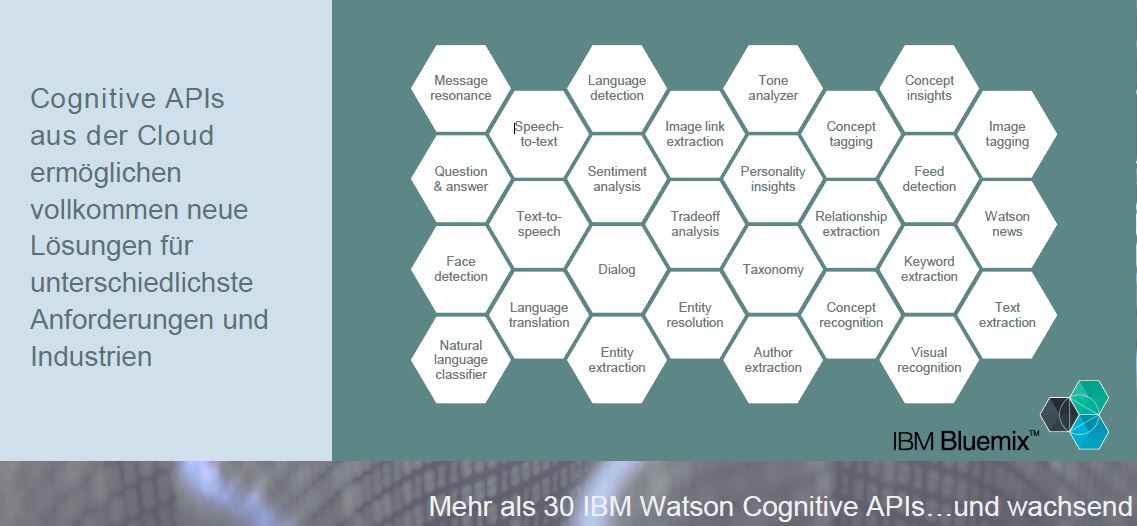

IBM: Kognitive Services aus der Cloud liefern nun echten Geschäftsnutzen

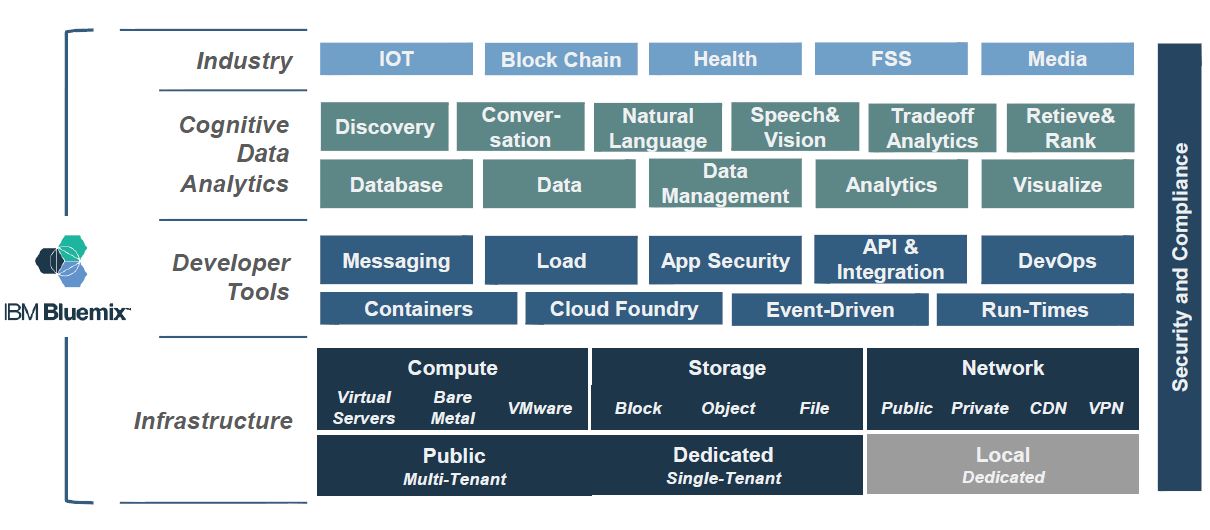

Runde erläutert, dass es das wesentliche Element von Cognitive Services ist, dass sie nicht nur Daten lesen, verstehen und interpretieren können, sonder auch »daraus lernen und Rückschlüsse ziehen können«. Runde führt im Interview auch einige konkrete Einsatzbeispiele an, beispielsweise bei BMW oder bei der Bayerischen Versicherungskammer.

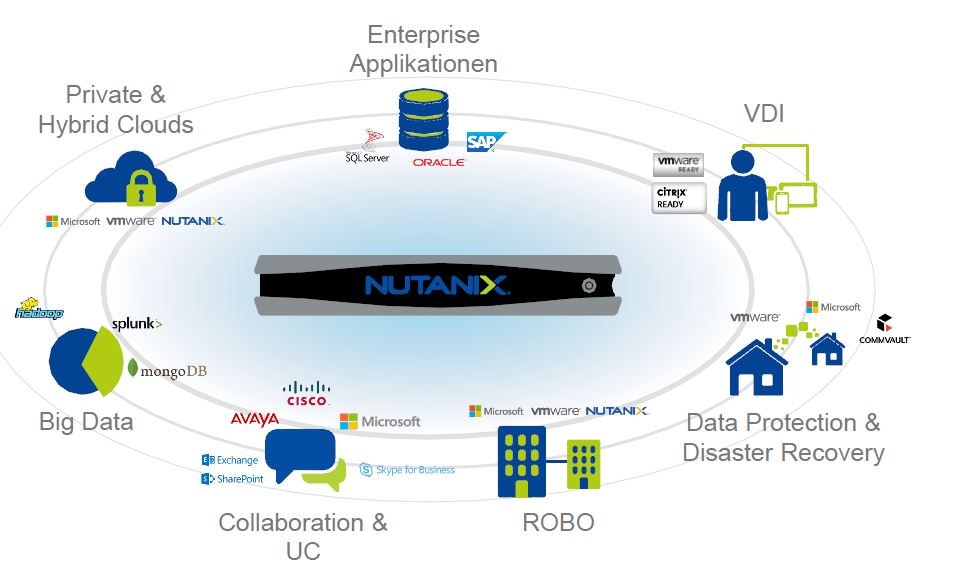

Nutanix unterstützt Unternehmen, den disruptiven Weg zu gehen

Nutanix tritt mit ihren Hyperkonvergenz-Systemen dahingehend an, die Konzepte der bekannten Hyperscaler – wie Amazon AWS oder Google Cloud – ins Enterprise zu transportieren. Denn es lässt sich damit eine hochskalierbare Web-Scale-Architektur auch im Datacenter der Unternehmen aufbauen, erläutert Dr. Markus Pleier, Director Presales Germany bei Nutanix, im Video-Interview mit speicherguide.de: »Fachbereiche in Unternehmen können mit unseren Hyperkonvergenz-Systemen Resourcen genauso schnell bereit gestellt werden wie in der Public-Cloud.«

Riverbed sorgt für allumfassende Performance, wenn Kunden mehrere Clouds nutzen

Oliver Burgstaller, Director Advanced Business Solutions von Riverbed, provozierte auf dem IDC-Event mit dem Postulat: Die Cloud ist nicht per se günstig. Im Video-Interview mit speicherguide.de stellt er klar: »Es geht letztendlich darum, welche Workloads bleiben im Datacenter, und welche Workloads verlagert man in die Cloud.« Es ist schließlich auch Capex gegen Opex abzuwägen.

Burgstaller führt als Beispiel Software-Entwickler an, die schnell zu Ergebnissen kommen wollen, und dabei noch gar nicht abschätzen können, welcher Workload entsteht dabei. Für sie sei die Cloud prädestiniert. Und wichtig sei hierbei, dass man auch die Kosten im Blick behalten könne.

Riverbed band bislang Außenstellen ans Unternehmens-Datacenter an. Mittlerweile stellt das Unternehmen fest, dass die Datacenter immer öfters an die Public-Cloud angebunden werden. »Wir sind hier in der Lage allumfassende Performance zu bieten«, stellt Burgstaller den Mehrwert von Riverbed für Unternehmenskunden heraus. Dabei stellt sich auch oft heraus, dass der Kunde Visibilität an Orten haben will, an denen keine eigene Hardware installiert ist. Und diese Visibilität bekommen Kunden mit den Riverbed-Lösungen.

Trend ist laut Burgstaller auch, dass die Kunden verschiedene Applikationen in verschiedenen Clouds laufen lassen: »Und diese Clouds müssen mit der heimischen Cloud im Kunden-Datacenter kommunizieren.«

Rackspace-Fanatical-Support managed die Hybrid- und Multi-Clouds der Kunden

Das Unternehmen Rackspace war früher ein Hosting-Provider – aber mittlerweile ist man deutlich mehr: Rackspace positioniert sich als Managed-Cloud-Provider, und bietet hier den bekannten 24x7x365-Fanatical-Support an. Der Bedarf ist anscheinend da. »Denn die Multi-Cloud ist sogar bereits im Mittelstand angekommen«, erläutert Alex Fürst, Vice President DACH von Rackspace, im Video-Interview mit speicherguide.de. »Sehr häufig treffen wir die Hybrid-Cloud an, und dass Kunden natürlich mit mehreren Public-Cloud-Anbietern zusammenarbeiten. Hier bieten wir unseren Fanatical-Support On-top beispielsweise auf AWS oder Azure an.«

Besonders gut aufgestellt ist Rackspace, wenn die Cloud-Plattform OpenStack bei Kunden im Einsatz ist. Denn bei dieser Plattform, die auf Open-Source-Software basiert, war Rackspace einer der Gründungsväter. »OpenStack ist generell für den Mittelstand sehr interessant«, betont Fürst. Rackspace könne hier mittlerweile eine Erfahrung von über einer Milliarde Betriebsstunden vorweisen.

Trotz aller Vorteile der Lösung und weltweiter Bekanntheit des Unternehmens – Rackspace hatte über mehrere Jahre erfolglos versucht, in Deutschland Fuß zu fassen. Das soll jetzt Fürst mit einem Team, das den Channel und den Mittelstand kennt, ändern. Dazu arbeite man momentan aus München heraus viel mit Partnern und Systemhäusern zusammen.

Denn fehlende Ressourcen und mangelnde Kompetenzen sind laut Fürst derzeit die größten Herausforderungen für Unternehmen, die schon in der Multi-Cloud sind, oder demnächst mit Multi-Cloud-Umgebungen arbeiteten. Hier biete sich ein neutraler Managed-Service-Partner an, der Zugriff auf Ressourcen hat, und über die Kompetent und Erfahrung in den verschiedenen Public-Cloud und Technologien verfügt.

Vmware verspricht: Applikationen in die Cloud ohne Downtime verschieben

Dass sich mittlerweile Applikationen in die Cloud ohne Downtime verschieben lassen, darauf beharrte Richard Munro, Chief Technology Officer von VMware Cloud Services sowohl in seiner Präsentation auf dem »IDC Hybrid Cloud Summit« als auch im Video-Interview mit uns. Abhängig sei dies eigentlich kaum noch von einer kompatiblen Cloud, sondern vielmehr von der Netzwerkumgebung im unternehmenseigenen Datacenter. Munroe verweist in diesem Zusammenhang auf Vmwares Netzwerk-Virtualisierung NSX, die dann beispielsweise mit der Vmware-Cloud »vCloud Air« zusammenspielt.

Aber die Vmware-Cloud spielt seit einigen Monaten auch mit AWS zusammen. Mit »VMware Cloud on AWS« seien Applikationen über Vmware-vSphere-basierte Private-, Public- und Hybrid-Cloud-Umgebungen hinweg betreibbar. »Das ist eigentlich schon nicht mehr eine Hybrid-Cloud, vielmehr befinden wir uns auf dem Weg zur Multi-Cloud«, erläutert Munro. Man arbeite ja auch bereits mit der »Bluemix«-Cloud vin IBM zusammen.

In seiner Präsentation betonte Munro den ständigen Kreislauf von »Daten zu Analytics zu Applikationen, und wieder zurück« zu den Daten. Diesen Loop würden reinrassige Internet- und Cloud-Unternehmen wie Facebook oder Uber sehr schnell durchschreiten. Dafür gebe es noch kein standarisiertes Vorgehensmodell. Die Best-Practices-Sammlung ITIL (Information Technology Infrastructure Library) hält Munro im Cloud-Zeitalter eher für hinderlich: »ITIL wurde geschaffen, um diesen Loop zu verlangsamen.« (Dies korreliert übrigens auch mit einer IDC-Studie aus dem Jahr 2013, wonach ITIL bei Cloud-Services kaum zum Einsatz komme.)

Bedeutet laut Munro: »Traditionelle Applikationen vertrauen auf traditionelle Infrastrukturen. Und wenn traditionelle Applikationen in die Cloud gehen sollen, dann wird eine Hybrid-IT-benötigt.« Er beschwört sogar die Anwender: »Bleiben Sie nicht in den Datensilos stecken! Nicht auf die Cloud zu reagieren, ist jetzt der größte Fehler, den man machen kann. Die digitale Transformation kommt, und die Cloud ist real.«

- »IDC Cloud Summit 2017«: Rückblicke, Impressionen, Interviews

- DARZ positioniert ihre Hybrid-Cloud für KRITIS-Organisatonen

- IBM: Kognitive Services aus der Cloud liefern nun echten Geschäftsnutzen

- Nutanix unterstützt Unternehmen, den disruptiven Weg zu gehen

- Riverbed sorgt für allumfassende Performance, wenn Kunden mehrere Clouds nutzen

- Rackspace-Fanatical-Support managed die Hybrid- und Multi-Clouds der Kunden

- Vmware verspricht: Applikationen in die Cloud ohne Downtime verschieben