Effizientes Datenmanagement bringt Digitalisierung voran

In den letzten zehn Jahren hat bei vielen IT-Entscheidern ein Umdenken stattgefunden, verstärkt Cloud-Services zu nutzen. Nicht mehr allein der Erwerb von Technologie für die interne IT steht im Vordergrund, sondern vielmehr der Einsatz der besten Technologie. Daher verfolgen auch immer mehr Unternehmen eine Cloud-First-Strategie. Bei der Umsetzung einer Digitalisierungsstrategie geht es nicht nur darum, zwischen verschiedenen Produkt- und Service-Bereitstellungsmodellen zu wählen. Ziel muss es vor allem sein, den Wechsel auf eine vorwiegend Cloud-basierte IT-Umgebung zu schaffen.

Das Analystenhaus IDC hat ein Anwachsen des weltweiten Datenvolumens bis 2025 auf 163 ZByte prognostiziert. Das ist zehnmal mehr als die 16,1 ZByte an Daten, die 2016 generiert wurden. Neue Bereitstellungsmodeelle wie Cloud-native Software als Service (SaaS), Internet der Dinge (IoT), mobile, hybride und Multi-Cloud-Anwendungen sowie lokal laufende Anwendungen haben häufig dazu geführt, dass für das Unternehmen wichtige Daten über mehrere Repositories verteilt sind. Die Vielzahl von Datentypen und Repositories stellen die IT-Abteilung vor große Herausforderungen, denn dies führt auch zu Änderungen in den Bereichen Datenschutz, Sicherheit, Governance und Infrastrukturverwaltung.

Herr Lye, warum entscheiden sich immer mehr Unternehmen, von einer verteilten IT-Umgebung in eine Hybrid-Cloud-Umgebung zu wechseln? Und warum ist es nicht immer so leicht wie manche Anbieter versprechen?

Anthony Lye, Netapp (Bild: Stefan Girschner)Lye: Das liegt sicherlich an der Einfachheit der Abrechnungsmodelle in der Cloud. Der Kunde erhält beispielsweise eine Rechnung von Amazon Web Services über das, was er konsumiert bzw. abonniert hat. Dabei gibt es keine versteckten Kosten. IT war immer eine komplexe Organisation, die überwacht werden musste. Eine Cloud-basierte IT bietet völlige Transparenz und verursacht nur Betriebskosten, bindet aber nicht das Firmenkapital und muss auch nicht abgeschrieben werden. Die Rolle der IT ist heute wahrscheinlich umfngreicher als je zuvor, weil die Unternehmen erkennen, dass ihre Daten die beste Quelle für Differenzierung und Innovation sind.

Anthony Lye, Netapp (Bild: Stefan Girschner)Lye: Das liegt sicherlich an der Einfachheit der Abrechnungsmodelle in der Cloud. Der Kunde erhält beispielsweise eine Rechnung von Amazon Web Services über das, was er konsumiert bzw. abonniert hat. Dabei gibt es keine versteckten Kosten. IT war immer eine komplexe Organisation, die überwacht werden musste. Eine Cloud-basierte IT bietet völlige Transparenz und verursacht nur Betriebskosten, bindet aber nicht das Firmenkapital und muss auch nicht abgeschrieben werden. Die Rolle der IT ist heute wahrscheinlich umfngreicher als je zuvor, weil die Unternehmen erkennen, dass ihre Daten die beste Quelle für Differenzierung und Innovation sind.

Daten der neue Rohstoff fürs Business

Daten sind also der neue Rohstoff für Unternehmen?

Die All-Flash-Arrays der NetApp-FAS-A-Serie bieten Scale-Out-Flash-Speicher mit integriertem Datenmanagement (Bild: Netapp).Lye: Zuerst müssen Unternehmen herausfinden, welche Art von Daten sie überhaupt haben, wo sie gespeichert sind, wer Zugriff darauf hat und welchen Wert sie haben. Darin liegt auch der Grund, warum wir uns besonders auf die Datenstruktur konzentrieren. Wir stimmen mit den Experten von IDC überein, dass Unternehmen Richtlinien für den Datenschutz, die Datensicherheit, Datenorchestrierung und Integration festlegen sollten, ja und sogar eine Richtlinie für die Datenoptimierung. Das empfehlen wir auch unseren Kunden. Denn Unternehmen haben heute Daten an ganz verschiedenen Orten gespeichert: On-Premises, in der Public-Cloud und in der Private-Cloud. Die Datenmengen vergrößern sich durch Nutzung der IT-Infrastruktur und ihre Struktur verändert sich. Daher ist es nötig, die Daten wieder zusammenführen, um mit deren Hilfe bessere Entscheidungen treffen und auch digitale Produkte entwickeln zu können.

Die All-Flash-Arrays der NetApp-FAS-A-Serie bieten Scale-Out-Flash-Speicher mit integriertem Datenmanagement (Bild: Netapp).Lye: Zuerst müssen Unternehmen herausfinden, welche Art von Daten sie überhaupt haben, wo sie gespeichert sind, wer Zugriff darauf hat und welchen Wert sie haben. Darin liegt auch der Grund, warum wir uns besonders auf die Datenstruktur konzentrieren. Wir stimmen mit den Experten von IDC überein, dass Unternehmen Richtlinien für den Datenschutz, die Datensicherheit, Datenorchestrierung und Integration festlegen sollten, ja und sogar eine Richtlinie für die Datenoptimierung. Das empfehlen wir auch unseren Kunden. Denn Unternehmen haben heute Daten an ganz verschiedenen Orten gespeichert: On-Premises, in der Public-Cloud und in der Private-Cloud. Die Datenmengen vergrößern sich durch Nutzung der IT-Infrastruktur und ihre Struktur verändert sich. Daher ist es nötig, die Daten wieder zusammenführen, um mit deren Hilfe bessere Entscheidungen treffen und auch digitale Produkte entwickeln zu können.

Wie können Unternehmen durch die effiziente Nutzung ihrer Daten einen Wettbewerbsvorteil erzielen?

Lye: Ich denke, dass jedes Unternehmen, unabhängig von der Branche, die Daten grundsätzlich als Hauptquelle für Wettbewerbsvorteile betrachten sollte. Heute werden Produkte nicht nur hergestellt und ausgeliefert, sondern sind über IoT-Anwendungen auch kontinuierlich mit dem Internet verbunden. Unternehmen können dann die vom Produkt gelieferten Daten nutzen, um die Kundenerfahrung und das Produkterlebnis zu verbessern. Es geht also darum, diese Daten zu sammeln und daraus abgeleitete Produkte zu entwickeln. So wird die Transformation sämtlicher Branchen von Daten bestimmt.

Wer die besten Daten hat, gewinnt. Interessant ist, ist, dass gerade große Konzerne auf eine lange Geschichte zurückblicken – eine Geschichte des Geschäfts, eine Geschichte von Kunden und eine Geschichte von Produkten. Und sie hoffen, dass dies ein Vorteil gegenüber jungen Unternehmen ist. Die Frage ist aber, ob die großen Unternehmen ihre Daten wirklich effizient nutzen können. Junge Unternehmen hingegen sind viel agiler.

Die digitale Transformation ist in vollem Gange

Können Sie für die Transformation durch Daten ein Beispiel nennen?

Lye: Den größten Transformationsprozess durchläuft gerade die Automobilindustrie, hervorgerufen durch drei Faktoren: Elektrische Fahrzeuge, autonomes Fahren und die Sharing-Economy. Unternehmen mit langer Tradition wie BMW, Mercedes-Benz, Ford oder General Motors müssen sich mit diesen drei massiven Veränderungen auseinandersetzen. Und wie in anderen Industrie-Branchen zeigt sich, dass die meisten Unternehmen disruptive Entwicklungen ignorieren. Sie glauben, dass es nicht wahr ist. Dagegen haben wir ein Unternehmen wie Tesla, mit einer Marktkapitalisierung über der von General Motors und gleichzeitigen Verkäufen von weniger als einem Prozent des Umsatzes von General Motors. Oder Google mit seiner Tochtergesellschaft Waymo, die autonom fahrende Taxis auf den Markt bringt. Das sind Beispiele von Unternehmen, die vor zehn Jahren noch gar nicht existierten.

Die Daten verändern also die Automobilindustrie genauso wie die Cloud die IT-Branche verändert oder der Bitcoin die Banken-Branche. Mittlerweile gibt es so viele digitale Produkte und Dienste, die wir mehr schätzen als die physischen Gegenstücke. In meiner beruflichen Karriere der letzten 25 Jahre gab es ununterbrochenen Wandel, vom Mainframe bis zum Mini-Computer. Und jedes Mal wurden die Möglichkeiten, die Technologie zu nutzen, erweitert, indem ältere Technologien kannibalisiert wurden. Das ist meiner Ansicht nach eine großartige Sache.

Datenmanagement: IT muss dezentralisiert werden

Kommen wir auf den Data-Fabric-Ansatz von Netapp. Wie unterstützt dieses Konzept das Datenmanagement?

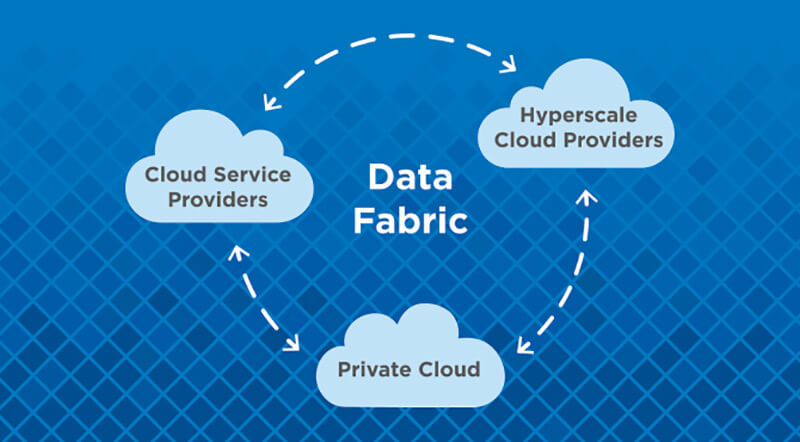

Der Data-Fabric-Ansatz umfasst Datenschutz sowie Sicherheit, Integration und Optimierung der Daten (Bild: Netapp).Lye: Wir haben erkannt, dass die IT-Umgebung dezentralisiert werden muss und dass viele Unternehmen kein eigenes Rechenzentrum mehr benötigen. Außerdem wird die IT-Umgebung künftig viel verteilter sein und die Daten werden viel dynamischer und vielfältiger sein. In den meisten Unternehmen wird es eine gemischte IT-Umgebung geben, bestehend aus einem eigenen Rechenzentrum sowie Private- und Public-Cloud-Diensten.

Der Data-Fabric-Ansatz umfasst Datenschutz sowie Sicherheit, Integration und Optimierung der Daten (Bild: Netapp).Lye: Wir haben erkannt, dass die IT-Umgebung dezentralisiert werden muss und dass viele Unternehmen kein eigenes Rechenzentrum mehr benötigen. Außerdem wird die IT-Umgebung künftig viel verteilter sein und die Daten werden viel dynamischer und vielfältiger sein. In den meisten Unternehmen wird es eine gemischte IT-Umgebung geben, bestehend aus einem eigenen Rechenzentrum sowie Private- und Public-Cloud-Diensten.

Der Data-Fabric-Ansatz ist eine Architektur und enthält eine Reihe von Tools und Technologien. Andere Unternehmen können hierbei die APIs und die von uns entwickelten Blueprints nutzen. Mit Data Fabric fokussieren wir Datenschutz, Sicherheit, Integration und Optimierung. Der Speicher und die Persistenz stellen sicher, dass der Anwender sämtliche Protokolle, Dateien und Objekte nutzen kann, unabhängig davon, ob es sich um unseres oder ein anderes Storage-Management-System handelt, einschließlich Komprimierung, Deduplizierung, Zugriffskontrolle und zusätzlichen Datendiensten für Snapshots. Außerdem werden Anwendungen wie DevOps, Backups oder Analytics unterstützt.

Wichtig ist auch die Orchestrierung der Daten. Mit OnCommand Insight (OCI) bieten wir eine Lösung für das Monitoring und Management der Hybrid-Cloud-Infrastruktur, also der vorhandenen Speicher- und Computing-Infrastruktur. Sie verrät dem Anwender den genauen Verbrauch der Ressourcen und wie viel er dafür bezahlen muss.

Netapp hat sich also von einem Storage-Hersteller zu einem Data-Management-Anbieter verwandelt?

Lye: Ein wichtiger Schritt war es, die Storage-Management-Software Ontap in die Cloud zu importieren. Wir haben erkannt, dass die in Cloud-Plattformen eingesetzten Laufwerke dieselben sind wie die die in unseren selbst entwickelten Systemen. Schließlich war wir auch nicht Erfinder des Flash-Speichers. Wir haben erkannt, dass die IT-Umgebungen, in der unsere Systeme eingesetzt werden, fast immer gemischt sind. Daher haben wir vor vier Jahren begonnen, mit den großen Cloud-Anbietern wie Amazon Web Services, Microsoft und Google zusammenzuarbeiten. Ich glaube nicht, dass andere Hersteller wie HP oder EMC diese Entscheidung getroffen haben.

Aufgrund dieser Transformation haben wir drei Geschäftsbereiche gebildet: Kernsysteme, Software und All-Flash-Storage-Systeme sowie die beiden neuen Geschäftsbereiche Cloud-Business, der ich angehöre, und Cloud-Infrastructure-Business, die Hyper-Converged-Infrastruktur (HCI) und SolidFire abdeckt. Auf der HCI-Technologie basieren beispielsweise die SAP Enterprise Cloud, IBM Cloud und viele andere Cloud-Plattformen. Mein Geschäftsbereich Cloud-Business umfasst hingegen ausschließlich Services, die auf Cloud-Plattformen wie AWS, Azure, Google, IBM oder Alibaba laufen. Die Integration der verschiedenen Lösungen erfolgt mit unserem Data-Fabric-Ansatz, der übrigens auch Endpunkte unterstützt, die nicht von uns stammen.

Datenmanagement: Herausforderung DSGVO

Wie sehen Sie die Herausforderungen durch die neuen Bestimmungen der Datenschutz-Grundverordnung (DSGVO)?

Lye: In der Tat kommen durch Inkrafttreten der DSGVO zahlreiche Herausforderungen auf die Unternehmen zu. Wir müssen unsere Kunden dabei unterstützen, ihre Daten in einer stark verteilten Umgebung zu sichern und vor Cyberattacken zu schützen. Die Ontap-Software liefert eine gute Basis, die Verfügbarkeit und Sicherheit der Daten zu gewährleisten. Auch unsere Kernlösungen bieten wichtige Funktionen, wie die Verschlüsselung und Verfügbarkeit von Informationen sowie die Begrenzung der Verbreitung der Informationen. Daher schauen wir uns derzeit eine Reihe von Technologien für maschinelles Lernen an, um dem Anwender zeigen zu können, welche Art von Daten er gespeichert hat und wo sie sich befinden.

Auf Basis dieser Informationen lassen sich dann passende Governance-Richtlinien ableiten, die unter anderem regeln, welche Personen auf die Daten zugreifen dürfen. Ich glaube, dass die Anwender von neuen Cloud-Plattformen vor allem Informationen schneller verbreiten möchten, ohne selbst auf das Sicherheits-Level achten zu müssen.

Akzeptanz von Cloud-Plattformen

Könnte die Sicherheitsthematik dazu führen, dass die Akzeptanz von Cloud-Plattformen bei Anwendern sinkt?

Lye: Ich denke, dass die Cloud-Plattformen auf eine sehr spezifische Art und Weise entwickelt wurden. Sie skalieren nämlich horizontal. Und viele traditionelle Legacy-Anwendungen, die es vor Cloud-Computing gab, benötigen eine Scale-Up-Architektur. Daher wurden die Cloud-Plattformen meiner Meinung nach nicht für eine Leistungssteigerung entwickelt. Sie wurden vielmehr entwickelt, weil sich 80 Prozent der benötigten Infrastruktur mit 20 Prozent der Systeme abdecken lassen. Wenn man zwischen dem Nutzwert und den Vorteilen von High-Performance-Systemen abwägt, erscheint Cloud-Computing gut platziert zu sein.

Wenn ich den Vergleich zu Automobilindustrie ziehe, haben wir auf der einen Seite ein preisgünstiges Familienauto und auf der anderen Seite einen schnellen Sportwagen. Die Cloud-Technologie würde demnach einem BMW der 3er Reihe oder einem Ford Focus entsprechen. Die heute verfügbaren Cloud-Infrastrukturen entsprechen also dem ersten Auto von Henry Ford in Massenfertigung, das in jeder gewünschten Farbe zu haben war, solange es schwarz war. Bei einer Cloud-Plattform handelt es sich um eine völlig konsistente Umgebung, ohne jede Variabilität. Und darin liegt der Unterschied zur Unternehmens-IT, die darauf fokussiert ist, die Probleme der Anwender zu lösen, was häufig zu äußerst komplexen und heterogenen Infrastrukturen geführt hat.

Wie wurde die Cloud-Technologie zum Treiber von Innovation?

Lye: Die Cloud durchläuft drei Hauptphasen der Innovation. In der ersten Phase sprechen wir von der Strategie der Unternehmen, eine Cloud-Plattform zu implementieren. Dabei stellt sich die Frage, ob sich eine vorhandene IT-Umgebung, einschließlich Backup und Datenbanken, einfach in die Cloud verschieben lässt. Dieses Vorgehen ist ähnlich wie der Open-Stack-Ansatz. In der 2. Phase wird dann die Cloud zu derjenigen Technologie, mit der sich völlig neue Anwendungen entwickeln lassen, die aber niemals On-Premises laufen würden. In der 3. Phase kommen nun neue Technologien wie maschinelles Lernen und künstliche Intelligenz dazu. Auch sie funktionieren nicht On-Premises, sondern nur auf Cloud-Plattformen.

Maschinelles Lernen und KI in der Praxis

Wie sieht es mit praktischen Anwendungen bei maschinellem Lernen und künstlicher Intelligenz aus?

Anthony Lye, Netapp: »Unternehmen investieren inzwischen viel mehr in Cloud-Infrastruktur als in ihre eigenen RZs.« (Bild: Stefan Girschner)Lye: Unternehmen haben zunächst Data-Scientist eingestellt, um geeignete Anwendungsfälle zu finden. Hierbei wurde erkannt, dass maschinelles Lernen und künstliche Intelligenz den Knowledge-Worker so unterstützen kann, wie Workflow-Systeme es bei Prozessen konnten. Zahlreiche Anwendungen wurden entwickelt, um eine Vielzahl menschlicher Prozessarbeit überflüssig zu machen. Ich denke, die große Chance von ML ist, das Gleiche für den Knowledge-Worker zu erreichen. Entscheidend ist, dass die Mitarbeiter dabei nicht durch Computer ersetzt werden, sondern in ihrer Arbeit unterstützt werden.

Anthony Lye, Netapp: »Unternehmen investieren inzwischen viel mehr in Cloud-Infrastruktur als in ihre eigenen RZs.« (Bild: Stefan Girschner)Lye: Unternehmen haben zunächst Data-Scientist eingestellt, um geeignete Anwendungsfälle zu finden. Hierbei wurde erkannt, dass maschinelles Lernen und künstliche Intelligenz den Knowledge-Worker so unterstützen kann, wie Workflow-Systeme es bei Prozessen konnten. Zahlreiche Anwendungen wurden entwickelt, um eine Vielzahl menschlicher Prozessarbeit überflüssig zu machen. Ich denke, die große Chance von ML ist, das Gleiche für den Knowledge-Worker zu erreichen. Entscheidend ist, dass die Mitarbeiter dabei nicht durch Computer ersetzt werden, sondern in ihrer Arbeit unterstützt werden.

Wir nutzen ML und KI beispielsweise für die eigene Anwendung Active Support. Hierbei melden Geräte, die bei Kunden im Einsatz sind, automatisch ihren aktuellen Status an uns. Außerdem haben wir eine riesige Datenbank mit Milliarden Einträgen, die darüber Auskunft geben, wie gut unsere Controller funktionieren. Diese Informationen stellen wir auch den ML-Plattformen von AWS und Microsoft zur Verfügung.

Ohne Cloud-Technologie geht es in Zukunft also nicht?

Lye: Unternehmen investieren inzwischen viel mehr in Cloud-Infrastruktur als in ihre eigenen Rechenzentren. Denn sie ist viel sicherer als das unternehmenseigene Rechenzentrum. Und die Konzentration der Innovationen in der Cloud bietet auch eine Reihe von wirtschaftlichen Vorteilen. Die große Herausforderung wird nicht darin liegen, die Computing-Funktionen von Cloud-Plattformen zu erweitern, sondern vielmehr zu wissen, wo die eigenen Daten liegen und wie sie sich mit den Bereichen verbinden lassen, wo Innovationen stattfinden. Das liegt vor allem daran, dass einige Daten nicht in der Public-Cloud gespeichert werden dürfen. Wir setzen auf die Strategie, die Vorteile einer Hybrid-Cloud-Umgebung optimal zu nutzen.

.