Bitkom-Leitfaden hilft Planen von Big-Data-Projekten

Das immerhin über 80 Seiten umfassende Werk gibt konkrete Tipps und Hilfen bei der Planung und Umsetzung von Big-Data-Projekten in Unternehmen. Big Data bedeutet mittlerweile auch die Analyse großer Datenmengen aus unterschiedlichen Quellen in hoher Geschwindigkeit, im Idealfall in Echtzeit. Dies reicht von der Analyse einzelner Genome in der Medizin bis zur Optimierung des Verkehrs von Städten oder ganzen Staaten. »Das Geschäftsmodell vieler Unternehmen«, sagt Dr. Mathias Weber, Big-Data-Experte beim Bitkom, »wird sich durch Big-Data-Technologien stark verändern.«

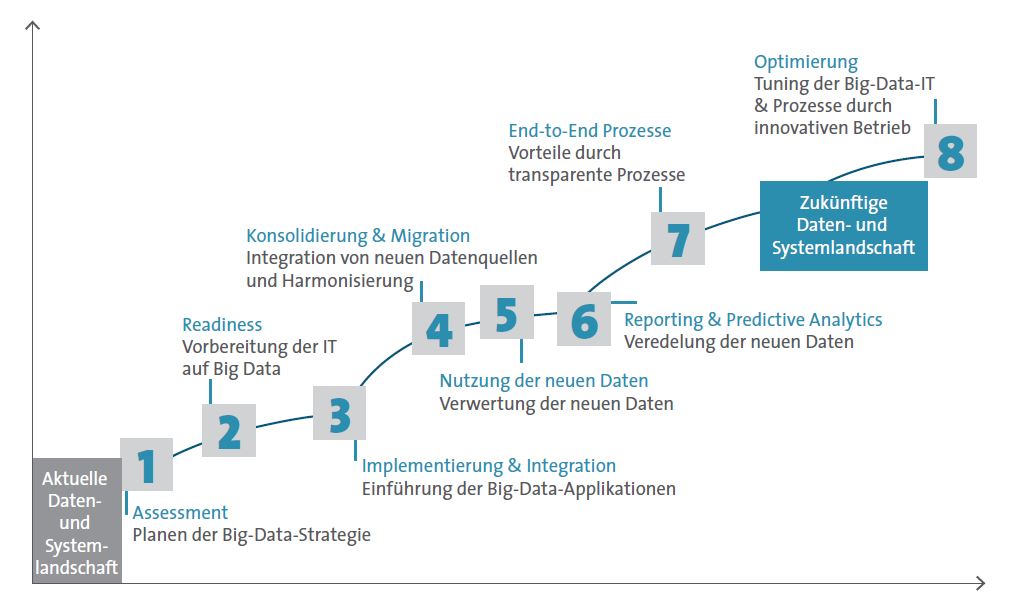

Big-Data-Projekten in acht Phasen umsetzen

Im Fokus des Leitfadens stehen Planung und Umsetzung von Big-Data-Projekten in Unternehmen. Dazu wird ein Vorgehensmodell vorgestellt, das in acht Phasen alle Aktivitäten zusammenfasst. So kann die Komplexität von Big-Data-Projekten deutlich reduziert werden. Das Phasenmodell reicht von der Erfassung der Möglichkeiten für das Unternehmen durch den Einsatz von Big Data über die konkrete Planung bis zur Umsetzung und weiteren Optimierung.

Der Leitfaden enthält zudem eine Übersicht über Architekturen und Basis-Technologien und er gibt Tipps, wie Big-Data-Kompetenz bei den eigenen Mitarbeitern aufgebaut werden kann. »Um die Möglichkeiten von Big Data für das eigene Unternehmen nutzen zu können, ist eine gründliche Planung notwendig«, betont Weber. »Oft wird die Komplexität solcher Projekte unterschätzt.«

Datenschutz hat bei Big-Data-Projekten bedeutende Rolle

Werden in Big-Data-Projekten personenbezogene Daten verarbeitet, spielt der Datenschutz eine bedeutende Rolle. Der Leitfaden greift hierbei zwei wichtige Punkte auf: Er gibt Tipps, was bei der Pflicht zur Datenschutz-Folgenabschätzung, dem sogenannten »Privacy Impact Assessment«, beachtet werden muss. Ein solches Assessment ist unter anderem im Entwurf zur EU-Datenschutzverordnung enthalten. Der Leitfaden enthält hierzu eine konkrete Checkliste, die bei der Umsetzung von Big-Data-Projekten wichtige Hilfestellung geben kann.

Zudem klärt er darüber auf, wie anonymisierte und pseudonymisierte Daten zu einem höheren Datenschutz im Sinne des Bundesdatenschutzgesetzes führen können. Ziel ist es in beiden Fällen, dass erhobene Daten nicht direkt einer Person zugeordnet werden können. »Wer im Rahmen seines Big-Data-Projektes personenbezogene Daten verarbeiten will«, erklärt Weber, »muss früh innerhalb der Planungsphase den Datenschutz berücksichtigen.«

An dem kostenfrei herunterladbaren Leitfaden haben Vertreter vieler Firmen mitgearbeitet, die auf dem Big-Data- bzw. IT-Markt durchaus heftige Konkurrenten sind. Die Mitgestalter reichen unter anderem von Software AG, T-Systems, HP über IBM, Splunk, SAP, arvato Systems bis hin Marktanalysten von Experton Group oder Forrester Research. Experton brachte erst letzte Woche ihren brandneuen »Big Data Vendor Benchmark 2013« über den deutschen Big-Data-Anbietermarkt heraus. Und auch Leitfaden-Mitschreiber Robert Guzek von Fujitsu Technology Solutions gab speicherguide.de schon mal ein Interview rund um Big-Data-Trends.

- Bitkom

- Bitkom bezieht Position zum EuGH-Urheberrechtsabgabeurteil

- Neuer Bitkom-Leitfaden: So digitalisieren Sie Papierdokumente

- Bitkom veröffentlicht kostenlosen Compliance-Leitfaden

- Doc. tec. Storage über Hadoop, Big Data und Business-Intelligence-Lösungen

- Relevanz und Bedeutung von Big Data nimmt zu

- Mehr Infos über Big Data im speicherguide.de-Schwerpunkt