Dateninfrastruktur: Von der Datenflut zur Datenintelligenz

Generative KI verspricht Effizienz, , Innovation, Automatisierung und neue Geschäftsmodelle– doch viele Projekte scheitern an der Realität: Ohne robuste Dateninfrastrukturen, durchdachte Governance und skalierbare Strategien bleiben viele Vorhaben Stückwerk. Der Weg zur produktiven KI führt über die Basis – die Daten.

Generative KI verspricht Effizienz, , Innovation, Automatisierung und neue Geschäftsmodelle– doch viele Projekte scheitern an der Realität: Ohne robuste Dateninfrastrukturen, durchdachte Governance und skalierbare Strategien bleiben viele Vorhaben Stückwerk. Der Weg zur produktiven KI führt über die Basis – die Daten.

Künstliche Intelligenz ist längst nicht mehr nur ein Forschungsprojekt oder ein Technologietrend – sie steht im Zentrum digitaler Transformationsstrategien. Besonders generative KI verspricht, Experten zufolge, enorme Produktivitätsgewinne, neue Geschäftspotenziale und einen grundlegenden Wandel in der Art und Weise, wie Unternehmen mit Daten arbeiten. Soweit die Theorie, denn in der Realität bleibt die Umsetzung häufig hinter den Erwartungen zurück.

Die Gründe dafür sind ebenso vielfältig wie wiederkehrend: mangelhafte Datenqualität, fehlende Transparenz über Datenflüsse, unklare Zugriffsrechte und fragmentierte Infrastrukturen. Gleichzeitig stehen den KI-Projekten Anforderungen an Datenschutz, Compliance und Cyber-Resilienz gegenüber. Wer generative KI erfolgreich einsetzen will, braucht mehr als ein Sprachmodell – nämlich eine intelligente, skalierbare und sichere Datenarchitektur, die den Weg von der Idee zur produktiven Anwendung zuverlässig unterstützt.

Mit hybriden Datenplattformen die volle Nutzung von GenAI entfalten

Benjamin Bohne, ClouderaFür Benjamin Bohne, Group Vice President Sales CEMEA bei Cloudera, ist ein strategisches Datenmanagement eine der Voraussetzungen im Zeitalter von generativer KI (GenAI). Geopolitischer Unsicherheiten und sich wandelnder Regularien sind nicht nur Herausforderungen, sondern »eine Chance sich neu aufzustellen und effizienter zu werden.«

Benjamin Bohne, ClouderaFür Benjamin Bohne, Group Vice President Sales CEMEA bei Cloudera, ist ein strategisches Datenmanagement eine der Voraussetzungen im Zeitalter von generativer KI (GenAI). Geopolitischer Unsicherheiten und sich wandelnder Regularien sind nicht nur Herausforderungen, sondern »eine Chance sich neu aufzustellen und effizienter zu werden.«

Lange Zeit galt das Paradigma »Cloud-first« als Maßgabe. Angesichts steigender Kosten, regulatorischer Risiken (z. B. potenzielle EU-Gegenzölle auf US-Cloud-Services) und wachsender Anforderungen an Datensouveränität findet zunehmend ein Umdenken statt. Der neue Trend: »Use-Cases-first«, sagt Bohne. »Unternehmen bevorzugen hybride Multicloud-Strategien, die sowohl Flexibilität bei der Anbieterwahl als auch Kontrolle über Datenstandorte bieten. Die Devise lautet: Cloud, wo es Sinn ergibt – aber stets mit Blick auf Effizienz, Compliance und Resilienz.«

Moderne Datenarchitekturen als Enabler

Bohne plädiert für eine service-orientierte Architektur nach dem Data-Mesh-Modell. Dieses ermögliche es, Daten dezentral zu organisieren und dennoch zentral zugänglich zu machen. Es wurde als Gegenentwurf zu klassischen, stark zentralisierten Datenplattformen entwickelt – also zu Data-Lakes oder zentralen Data-Warehouses, die alle Daten unter einem Dach zusammenführen. Stattdessen geht Data-Mesh davon aus, dass Daten dort verwaltet und verantwortet werden sollen, wo sie entstehen – also in den jeweiligen Fachbereichen oder Domänen. Diese Bereiche sind nicht nur Datenproduzenten, sondern auch für die Qualität, Pflege und Bereitstellung ihrer Daten verantwortlich. Ziel ist es, Datensilos aufzubrechen, Redundanzen zu vermeiden und eine skalierbare, kosteneffiziente Datenbasis zu schaffen. Gerade in datenintensiven Branchen wie der Automobilindustrie sei dies entscheidend für eine zukunftsfähige IT-Infrastruktur.

Nachbesserungsbedarf besteht laut Bohne auch bei der Datenarchitektur, denn Mitarbeiter verwenden KI-Anwendungen oft über nicht kontrollierte Plattformen: »Unternehmen sollten daher proaktiv sichere, integrierte KI-Umgebungen bereitstellen, um Datenabflüsse zu vermeiden und Potenziale gezielt zu nutzen.«

Zudem kann ein KI-System nur so leistungsfähig sein, wie die Daten, auf denen es basiert. Veraltete oder duplizierte Daten bergen Risiken – in manchen Fällen sei es sogar besser, gar keine Daten zu verwenden als schlechte. Vor diesem Hintergrund betont Bohne die Bedeutung konsistenter Datenqualität, klarer Zugriffsrechte und der Einhaltung regulatorischer Anforderungen wie dem EU-Data-Act.

Fünf Kernprinzipien für eine zukunftsfähige Datenstrategie

Fünf Erfolgsfaktoren für Unternehmen, die GenAI systematisch nutzen wollen:

- Enterprise-KI ermöglichen: KI-Zugriff über klar definierte APIs – intern wie extern – bei voller Kontrolle über die verwendeten Daten.

- Echte souveräne Cloud-Infrastruktur: Technologische Redundanz und Vermeidung von Lock-ins, um auf politische und wirtschaftliche Veränderungen reagieren zu können.

- Interoperabilität durch Open-Source: Einsatz offener Standards als Basis für technologische Flexibilität und langfristige Innovationsfähigkeit.

- Zentrale Datenkontrolle statt Silos: Nur wer seine Daten zentral steuern kann, kann sie auch unternehmensweit sinnvoll einsetzen.

- Echtzeitfähigkeit nach Geschäftsmodell: Unterschiedliche Branchen benötigen unterschiedliche Reaktionszeiten – aber der Trend geht klar zur Echtzeitverarbeitung.

Intelligente Dateninfrastruktur als Schlüsseltechnologie für KI

Sabrina Kasper, NetappFür Sabrina Kasper, AI Sales Lead DACH bei NetApp, ist eine intelligente und integrierte Dateninfrastrukturen die Voraussetzung für erfolgreiche KI-Initiativen in Unternehmen: »Der Trend geht klar von isolierten Pilotprojekten hin zu produktiven KI-Anwendungen, die tief in bestehende Prozesse integriert sind – mit all ihren infrastrukturellen Herausforderungen.«

Sabrina Kasper, NetappFür Sabrina Kasper, AI Sales Lead DACH bei NetApp, ist eine intelligente und integrierte Dateninfrastrukturen die Voraussetzung für erfolgreiche KI-Initiativen in Unternehmen: »Der Trend geht klar von isolierten Pilotprojekten hin zu produktiven KI-Anwendungen, die tief in bestehende Prozesse integriert sind – mit all ihren infrastrukturellen Herausforderungen.«

Künstliche Intelligenz ist längst über die Hype-Phase hinaus. Unternehmen beschäftigen sich laut Kasper zunehmend mit der Frage, wie und wann KI sinnvoll implementiert werden kann: »Die größte Hürde ist dabei, die dafür notwendige Dateninfrastruktur ist oft nicht vorbereitet. Untersuchungen zufolge gehen 63 Prozent davon der Unternehmen davon aus, dass ihr Storage für KI-Anwendungen nicht geeignet ist.«

Flaschenhals Datenmanagement

Der zentrale Engpass bei KI-Projekten liegt meist im Umgang mit Daten. Laut Studien entfällt rund 80 Prozent des Projektaufwands auf das Management, die Klassifizierung und die Bewegung von Daten – nur 20 Prozent auf die eigentliche Modellierung oder das Training. Hauptursache hierfür: »Datensilos und isolierte Infrastrukturen, die oft im Schatten der offiziellen IT entstehen – getrieben von Fachabteilungen mit eigenem Budget, aber ohne übergreifende Integration«, erklärt Netapp-Managerin Kasper.

Ein weiteres Problem sei der mangelhafte Umgang mit Datenschutz und Governance. Nur 20 Prozent der Unternehmen verfügen über eine ausgereifte Daten-Security-Strategie – ein kritischer Befund angesichts der sensiblen Informationen, die in KI-Projekten verarbeitet werden. Fehlende Zugriffskontrollen können dazu führen, dass interne Chatbots unbeabsichtigt vertrauliche Informationen wie Gehaltsdaten preisgeben.

Anforderungen an eine intelligente Infrastruktur

Netapp verfolgt einen Ansatz, der eine intelligente Dateninfrastruktur muss, vier zentrale Eigenschaften mitbringen:

- Integriert: Die Infrastruktur muss in der Lage sein, Daten über System- und Abteilungsgrenzen hinweg nutzbar zu machen – auch in Verbindung mit KI-spezifischen Werkzeugen wie MLOps-Plattformen.

- Intelligent: Automatisierte Klassifizierung, Zugriffskontrollen und Policy-basierte Steuerung sind essenziell, um auch nicht-technische Nutzer wie Data Scientists abzusichern.

- Skalierbar: Neben klassischer Skalierung im Sinne von Performance geht es auch um die Skalierbarkeit von Produktivität – etwa durch native Unterstützung der Tools, die Fachanwender ohnehin nutzen.

- Sicher: Die Dateninfrastruktur muss Schutzmechanismen bieten, die auch in hybriden und Cloud-Umgebungen greifen – inkl. Klassifizierung, Verschlüsselung und durchgängiger Zugriffssteuerung.

Die Realität vieler KI-Projekte ist hybrid: »Über 90 Prozent der Vorhaben starten in der Cloud, häufig aus Kosten- oder Flexibilitätsgründen«, erklärt Netapp-Managerin Kasper. »Entscheidend ist dabei, dass Unternehmen ihre Daten nahtlos zwischen On-Premises-Systemen und Cloud-Umgebungen bewegen können – ohne Sicherheits- oder Governance-Verluste.« Das umfasse unter anderem native Integration mit Hyperscalern und die Fähigkeit, Projekte bei Bedarf auch wieder in eigene Umgebungen zurückzuführen.

Wie KI heute Business-Intelligence revolutioniert

Philippe Picalek, Strategy»Ziel muss sein, Daten nicht nur zu visualisieren, sondern echten Mehrwert daraus zu generieren«, fordert Philippe Picalek, Vice President Northern Europe bei Strategy. »Dies sowohl für unterschiedliche Nutzergruppen im Unternehmen als auch über klassische Dashboards hinaus.«

Philippe Picalek, Strategy»Ziel muss sein, Daten nicht nur zu visualisieren, sondern echten Mehrwert daraus zu generieren«, fordert Philippe Picalek, Vice President Northern Europe bei Strategy. »Dies sowohl für unterschiedliche Nutzergruppen im Unternehmen als auch über klassische Dashboards hinaus.«

Picalek zieht eine Parallele zum Eishockey: Gute Spieler sind dort, wo der Puck ist, großartige Spieler antizipieren, wo er sein wird. Übertragen auf die Business-Intelligence (BI) bedeute dies: »Nicht nur rückblickend analysieren, sondern vorausschauend und proaktiv agieren – durch KI-gestützte Datenanalysen.«

Letztendlich würden sich zwei Nutzergruppen mit unterschiedlichen Anforderungen ergeben:

- Datenexperten (z. B. Data Scientists, Finanzanalysten, Underwriter): Sie arbeiten täglich mit Daten, erstellen Dashboards und modellieren Datenmodelle.

- Datennovizen (z. B. Vertriebsmitarbeitende, Retail-Beschäftigte): Sie verfügen über wenig Daten-Know-how, benötigen aber dennoch Entscheidungsgrundlagen aus Daten.

KI kann beide Gruppen unterstützen – mit unterschiedlichem Fokus. Für Experten geht es vor allem um Effizienz und Automatisierung bei der Datenanalyse. Für Datennovizen soll KI als einfaches Interface fungieren, das Fragen beantwortet, ohne tieferes technisches Wissen vorauszusetzen.

KI-Anwendungen in der BI-Praxis

»KI hilft dabei, schneller Dashboards zu erstellen, relevante Daten zu identifizieren oder Trends zu erkennen«, erklärt Picalek. »Versicherer nutzen beispielsweise KI zur Risikoeinschätzung (z. B. Naturgefahrenprognosen), Retail-Mitarbeitende erhalten automatisiert Hinweise auf ausverkaufte Produkte oder Nachfrageveränderungen.« Auch die mobile Nutzung über Apps werde zunehmend wichtiger.

Für Anwender ohne Datenhintergrund soll KI dabei möglichst intuitiv funktionieren – idealerweise per natürlicher Spracheingabe. Wenn mehr Mitarbeitende mit Daten arbeiten, steigere sich die unternehmerische Wettbewerbsfähigkeit.

Herausforderungen und Risiken

Trotz aller Potenziale steht der BI-Einsatz von KI noch nicht auf dem »Plateau der Produktivität«. Strategy-Manager Picalek sieht mehrere zentrale Herausforderungen:

- Datenqualität: Schlechte Daten führen zu schlechten Ergebnissen (»Garbage in, Garbage out«). Datenexperten erkennen solche Mängel, Laien hingegen nicht.

- Vertrauenswürdigkeit und Fehlinterpretationen: Besonders problematisch, wenn KI-Nutzer blind vertrauen – etwa, weil ein KI-System eine falsche Aussage plausibel formuliert.

- Governance und Sicherheit: Ohne saubere Datenklassifikation, Zugriffskontrollen und Compliance-Mechanismen drohen Datenlecks. Es müsse beispielsweise ausgeschlossen werden, dass Mitarbeitende Einblick in vertrauliche Informationen erhalten, wie Gehälter oder Kontodaten.

- Semantische Strukturierung: Als Lösungsansatz bietet sich die Verwendung semantischer Graphen an, die Daten kontextualisieren, klassifizieren und sicher zugänglich machen. Idealerweise bilden dienen sie als Grundlage für KI-Anwendungen.

KI-basierte Sicherheit als integraler Bestandteil des Datenmanagements

Frank Schwaak, RubrikFür Frank Schwaak, Field CTO EMEA bei Rubrik, ist Cyber-Resilienz nicht nur die Voraussetzung für Datensicherheit, sondern spielt auch eine tragende Rolle für den Erfolg generativer KI-Projekte. Besonders im Hinblick auf Datenqualität, Zugriffsrechte und Governance sieht er erheblichen Handlungsbedarf: »Wegen fehlender Datenqualität stellt laut Gartner bis Ende 2025 rund 30 Prozent der Unternehmen ihre GenAI-Projekte wieder ein.« Fehlendes Daten-Labeling, unzureichende Governance und falsch gesetzte Zugriffsrechte gefährden sowohl den Erfolg als auch die Sicherheit solcher Projekte.

Frank Schwaak, RubrikFür Frank Schwaak, Field CTO EMEA bei Rubrik, ist Cyber-Resilienz nicht nur die Voraussetzung für Datensicherheit, sondern spielt auch eine tragende Rolle für den Erfolg generativer KI-Projekte. Besonders im Hinblick auf Datenqualität, Zugriffsrechte und Governance sieht er erheblichen Handlungsbedarf: »Wegen fehlender Datenqualität stellt laut Gartner bis Ende 2025 rund 30 Prozent der Unternehmen ihre GenAI-Projekte wieder ein.« Fehlendes Daten-Labeling, unzureichende Governance und falsch gesetzte Zugriffsrechte gefährden sowohl den Erfolg als auch die Sicherheit solcher Projekte.

»Ohne saubere, strukturierte und zugriffsregulierte Daten ist keine belastbare KI möglich«, betont Schwaak. »Vor allem im Umgang mit sensiblen Informationen – etwa in Chatbots oder Analysemodellen – muss sichergestellt sein, dass vertrauliche Inhalte weder in Trainingsdaten einfließen noch unbeabsichtigt ausgegeben werden.«

Kosten und Risiken im Blick behalten

Die Umsetzung sicherer KI-Projekte sei nicht nur technisch, sondern auch wirtschaftlich anspruchsvoll. So setzen zum Beispiel Finanzdienstleister, vollständig auf lokale KI-Infrastruktur – mit eigenen Nvidia-Systemen und bewusstem Verzicht auf Cloud-Dienste. Nur solche Maßnahmen garantieren hohe Sicherheit, sind jedoch mit erheblichen Kosten verbunden.

Weitere Herausforderungen sieht Schwaak in der Operationalisierung von GenAI-Anwendungen. Das Prototyping müsse überwacht, validiert und ständig auf Plausibilität geprüft werden. Zusätzlich stellen sich Fragen zur Absicherung gegen gezielte Manipulation von Trainingsmodellen durch Cyberangriffe.

Zentrale These: Backup als vertrauenswürdige Datenquelle

Ein zentrales Element des Rubrik-Konzept ist die Nutzung des Backup-Systems als »Single Source of Truth«. »Dort liegen sämtliche Daten eines Unternehmens – strukturiert, unstrukturiert, aus Cloud- und On-Prem-Quellen – bereits konsolidiert vor«, meint Schwaak. »Werden diese durch eine Kette aus Data-Governance-Mechanismen, Sensitivitätsanalysen und Zugriffskontrollen geprüft, entsteht ein vertrauenswürdiges Fundament für den Einsatz generativer KI.«

Schwaak fordert einen ganzheitlichen Ansatz und eine Kombination aus Cyber-Resilienz, intelligenter Datenklassifikation und zentralisiertem Datenmanagement. Damit würde nicht nur an Sicherheit gewonnen, sondern vor allem auch an Effizienz. »Voraussetzung sei allerdings ein Umdenken – weg vom isolierten KI-Experiment hin zu einem gesamtheitlichen, sicherheitsgetriebenen Datenmanagement.

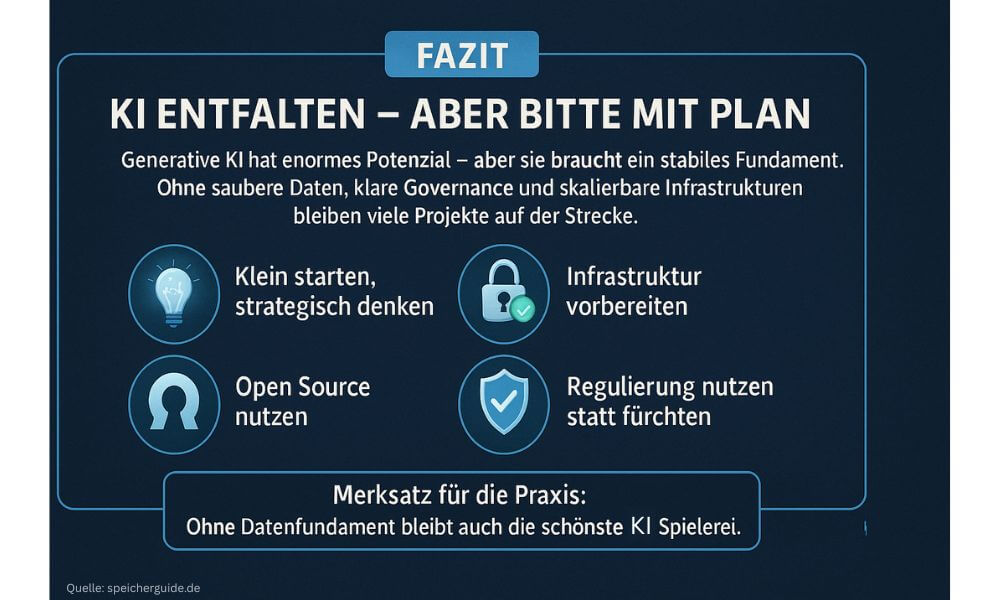

Fazit: KI entfalten – aber bitte mit Plan

Generative KI bietet enormes Potenzial – von effizienteren Prozessen über bessere Entscheidungen bis hin zu völlig neuen digitalen Services. Doch der Weg dahin ist kein Selbstläufer. Wer KI produktiv einsetzen will, muss zunächst die Grundlagen legen: saubere Daten, transparente Governance und eine Infrastruktur, die nicht morgen schon zum Flaschenhals wird.

Die Realität in vielen Unternehmen zeigt: Projekte starten oft vielversprechend, scheitern dann aber an verteilten Datensilos, uneinheitlicher Qualität oder fehlender Zugriffssteuerung. Gleichzeitig steigen die Anforderungen – von regulatorischer Seite ebenso wie durch Nutzererwartungen. Ob im Supermarkt, in der Logistik oder in der Finanzabteilung: KI funktioniert nur so gut, wie das Fundament, auf dem sie läuft.

Für IT-Manager heißt das konkret:

- Klein anfangen, aber strategisch denken: Use-Cases wie Lagerabfragen oder KI-gestützte Kundenkommunikation sind gute Einstiegspunkte – sie lassen sich relativ schnell realisieren und liefern direkten Mehrwert.

- Datenzugriffe differenziert steuern: Nicht jeder muss bzw. darf alles sehen. Rollenkonzepte, Zugriffskontrollen und segmentierte Berechtigungen sind kein Overhead, sondern Voraussetzung für Vertrauen – intern wie extern.

- Infrastruktur schrittweise modernisieren: Ein zentraler, standardisierter Datenzugang – etwa via Backup-Integration oder über eine Data-Mesh-Architektur – bringt Übersicht und Kontrolle.

- Open-Source-Komponenten bevorzugen: Sie reduzieren Abhängigkeiten von Hyperscalern, erleichtern Migrationen und schaffen technologische Beweglichkeit. Generell muss die Abhängigkeit von US-Anbietern kritisch hinterfragt werden.

- Regulierung als Chance begreifen: Der AI-Act oder NIS-2 mögen unbequem wirken, helfen aber dabei, Risiken frühzeitig zu identifizieren – und sichere, tragfähige Lösungen zu bauen.

KI wird den Arbeitsalltag verändern – ob gewollt oder nicht. Wer diese Entwicklung aktiv mitgestalten will, braucht keine All-in-Strategie. Aber er benötigt eine klare Vorstellung davon, wie Daten, Systeme und Menschen zusammenspielen sollen. Denn ohne Fundament bleibt auch die schönste KI eine Spielerei.