50 PByte? Ihr könnt kommen!

Wenn es in den PByte-Bereich geht, dann kommen klassische Storage-Architekturen an ihre Grenzen. Fujitsu bringt jetzt eine vollkommen neue Storage-Familie basierend auf Fujitsu-Infrastruktur und dem Open-Source-Cluster-Dateisystem Ceph sowie additives Management von Fujitsu. Die Skalierungsmöglichkeiten bis in den hohen PByte-Bereich sind frappierend.

Von Engelbert Hörmannsdorfer

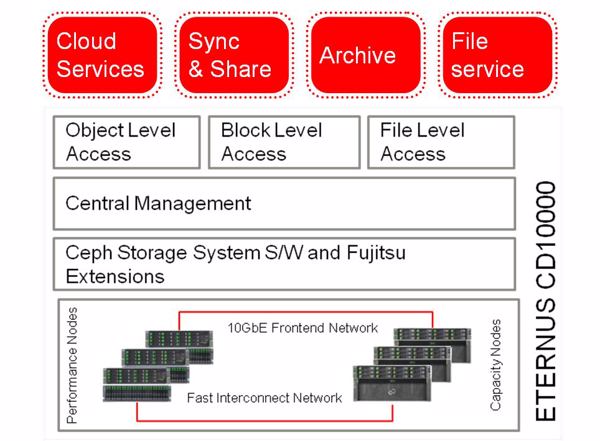

»ETERNUS CD10000« kombiniert das Cluster-Dateisystem »Ceph« mit Fujitsus Storage-Management-Funktionen (Bild: Fujitsu)Die Entwicklungen bei Cloud-Services, Mobility, Big Data und Analytics, Social-Networking und spezialisierte Internetangebote rollen unaufhaltsam, und revolutionieren schon heute nahezu jeden Bereich des Wirtschaftens und Lebens. Aus Storage-Sicht rollt dadurch eine wahre Datenlawine auf Rechenzentren zu, vor allem auf Cloud-Rechenzentren. Und wenn es in den PByte-Bereich geht, dann steht jetzt schon fest: klassische Storage- Architekturen wie beispielsweise RAID kommen zunehmend an ihre Grenzen.

»ETERNUS CD10000« kombiniert das Cluster-Dateisystem »Ceph« mit Fujitsus Storage-Management-Funktionen (Bild: Fujitsu)Die Entwicklungen bei Cloud-Services, Mobility, Big Data und Analytics, Social-Networking und spezialisierte Internetangebote rollen unaufhaltsam, und revolutionieren schon heute nahezu jeden Bereich des Wirtschaftens und Lebens. Aus Storage-Sicht rollt dadurch eine wahre Datenlawine auf Rechenzentren zu, vor allem auf Cloud-Rechenzentren. Und wenn es in den PByte-Bereich geht, dann steht jetzt schon fest: klassische Storage- Architekturen wie beispielsweise RAID kommen zunehmend an ihre Grenzen.

Manche Hersteller propagieren zwar Scale-out-Lösungen, die auf Cluster mit RAID-Systemen basieren. Das funktioniert sogar bis zu einem gewissen Grad. Allerdings skaliert die Performance nicht linear. Und beispielsweise auch der berühmtberüchtigte RAID-Rebuild wird nun zu einem langwierigen und echt risikobehafteten Problem.

Openstack und Ceph bahnen sich ihre Wege

Massiv skalierbare (Storage-)Infrastrukturen sind also gefragt. Denn neben dem Einsatz von skalierbaren und hochverfügbaren Storage-Architekturen für Mission-Critical-Umgebungen etabliert sich ein Trend in Rechenzentren hin zu Ressourcen in der Cloud. In der Open-Source-Welt bahnen sich gerade unter anderem zwei Entwicklungen hier ihren Weg. Dies ist zum einen »OpenStack«: eine extrem skalierbare Open-Source-Plattform zum Betrieb einer Cloud. Die Software eignet sich für eine kleine private Cloud aus wenigen Servern ebenso wie für eine Public-Cloud auf Amazon-Niveau.

Und zum anderen gibt es »Ceph«, ein Open-Source-Cluster-Dateisystem für Linux, mit denen sich Standard-Server-Hardware zu Storage-Clustern verbinden lassen. Diese halten die Daten redundant bereit und lassen sich leicht erweitern. Vor allem mit Openstack oder bei der Linux-Virtualisierung wird Ceph oft eingesetzt.

Ceph und Fujitsu: eine sich bestens ergänzende Kombination

Eine Basis-Version beginnt bei zirka 200/250 TByte. Und dann können Anwender nach Bedarf skalieren – und wie: Auf bis zu 224 Knoten kann ein Cluster heute ausgebaut werden! Das ist momentan einmalig in der Branche. Die Erstversion geht bis 56 PByte. Aber die Architektur ermöglicht bereits demnächst Skalierungsmöglichkeiten bis in den dreistelligen PByte-Bereich. Ein Cloud-Service-Provider hat Bedarf für bis zu 250 PByte? Kein Problem, die Daten können kommen. »Und das alles als echtes Unified-Storage auf Objekt-, Block- und File-Ebene«, schwärmt Roth. »Letztendlich bietet Ceph Skalierbarkeit bis in den Exabyte-Bereich, und ist zudem höchst zuverlässig und performant – und das wichtigste, ohne jegliche Downtime.«

Wenn Anwender neue Knoten hinzufügen möchten, dann ermöglicht Ceph eine nahtlose Erweiterung im laufenden Betrieb. Einen neuen Knoten in den Cluster einzufügen dauert nur ein paar Minuten. Genauso einfach kann ein Kunde einen Knoten auch wieder herausnehmen – Ceph erkennt das, und rekonfiguriert den Datenbestand.

Ceph schlägt RAID

Ein zentrales Element von Ceph ist der so genannte CRUSH-Algorithmus (Controlled Replication Under Scalable Hashing), der für das Schreiben und Lesen von Daten verwendet wird. Mit Hilfe des Algorithmus werden die Daten gleichmäßig über die Knoten und Festplatten einer CD10000-Appliance verteilt gespeichert und sind jederzeit reproduzierbar. Mit berücksichtigt wird dabei auch der aktuelle Zustand des Clusters – das heißt, die Software erkennt Änderungen durch, zum Beispiel, das Hinzufügen neuer Speicherknoten sowie Ausfälle von Festplatten und Knoten.

»Durch diese Technologie«, betont Roth, »ergeben sich Vorteile, die man von früheren RAID-Storage-Systemen gar nicht kennt.« So gibt es durch die verteilte Datenspeicherung keine Hotspots mehr. Außerdem ist das System selbstverwaltend, und passt sich Änderungen automatisch an. Und schließlich ist das System selbstheilend – es erkennt defekte Festplatten oder Knoten, und reagiert entsprechend.

Die Hardware – optimiert und aufeinander abgestimmt

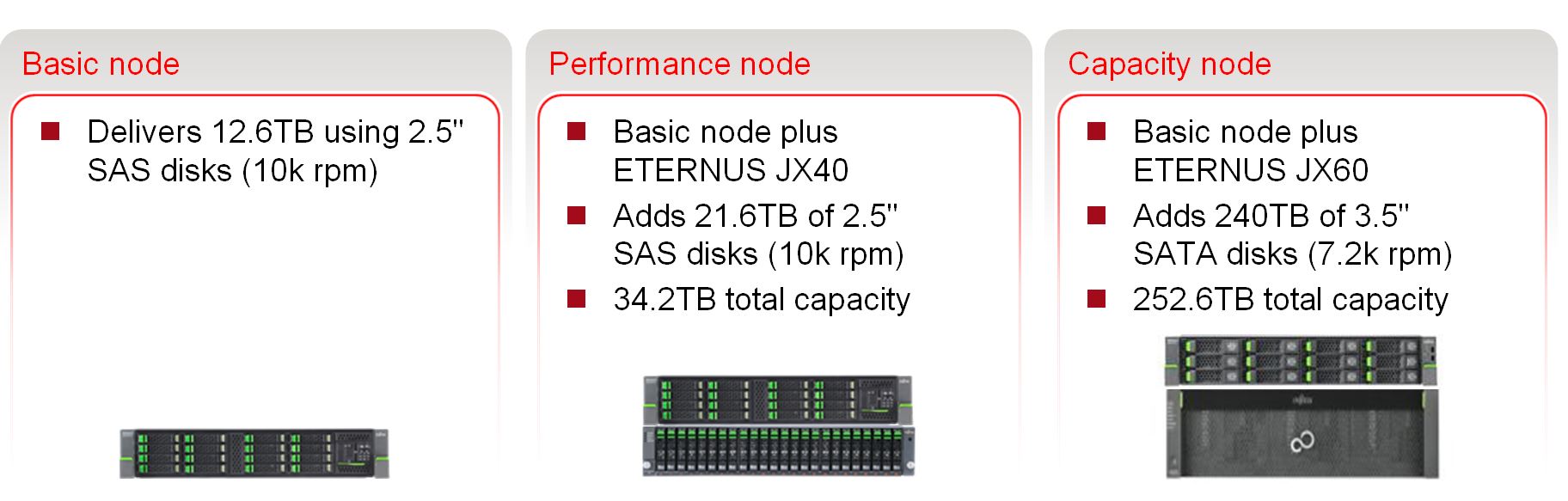

► Grundbaustein der Appliance ist der »Basic Node«; er besteht aus einem Fujitsu-Server »PRIMERGY« mit 12,6 TByte Rohkapazität.

► Für die Skalierung der Leistung ist der »Performance Node« zuständig, bei dem ein Fujitsu-Primergy-Server mit PCIe-SSDs ausgestattet ist. Zusätzliche Kapazität wird durch ein Fujitsu-JBOD »ETERNUS JX40« bereitgestellt. Die Rohkapazität des Performance-Node beträgt 34,2 TByte.

► Und schließlich gibt es den »Capacity Node«, der eine einfache Skalierung der Kapazität ermöglichen soll. Hierbei wird der Primergy-Server durch ein JBOD »ETERNUS JX60« ergänzt, so dass dieser Speicherknoten auf eine Rohkapazität von 252,6 TByte kommt. Beeindruckend dabei: Basic-Node, Performance-Node und Capacity-Node können in einer Appliance gemischt eingesetzt werden. Damit soll sich mit der CD10000 nahezu jedes Kunden-Einsatzszenario optimal konfigurieren lassen.

► Ergänzend ist noch ein »Management Node« verfügbar. Dieser zeichnet im Betrieb der Appliance die Ereignisse auf. Die Datensammlung wird für das Management der Infrastrukturlösung genutzt. Sollte der Management-Node ausfallen, so hat dies keinen Einfluss auf den Betrieb der Appliance.

Datenkommunikation in Hochgeschwindigkeit

Natürlich müssen sich die Nodes in Höchstgeschwindigkeit austauschen, damit sich die Performance richtig entfalten kann. Dazu sind die Fujitsu-Appliances im Backend mit 40-Gbit/s-Infiniband und im Frontend mit 10-Gbit/s-Ethernet verschaltet.

Aber bei all der ausgefeilten Hardware muss noch mal betont werden, dass erst das verteilte Dateisystem von Ceph diese Hardware-Architektur richtig ausreizt. Das passiert durch den Kniff, indem das Dateisystem die Metadaten von den gespeicherten Daten trennt. »Für die Metadaten-Transaktionen, die normalerweise die Hälfte der Arbeitslast verursachen, bietet die Storage-Software eine neuartige Architektur, die das Metadaten-Management über viele Metadata-Server (MDS) verteilt«, erläutert Roth. Die Clients greifen hierbei mit Hilfe des (oben erwähnten) CRUSH-Algorithmus direkt auf Daten zu, ohne dass eine zentrale Instanz abgefragt werden muss. Praktisch gesehen führt dies dazu, dass selbst dann, wenn sehr viele Clients auf die Appliance zugreifen, sich Daten ohne Performance-Einbußen lesen und schreiben lassen.

Und was ist mit der Konkurrenz?

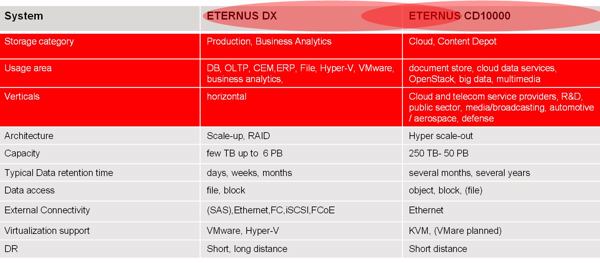

Im weitesten Sinne lässt sich CD10000 mit dem ECS-System von EMC vergleichen. Gemeinsam ist beiden: Die Storage-Nodes basieren auf Intel-Server-Technologie und auf JBODs. Aber hier hören die Gemeinsamkeiten schon auf.

EMC kommt derzeit auf acht Storage-Nodes, während Fujitsu bereits in der Erstversion auf über 200 kommt. Und dann schafft Fujitsu eine Speicherkapazitäten von zunächst 5 PByte, während EMC 2,9 PByte spezifiziert. Bei Fujitsu sprechen die Nodes über das wesentlich schnellere Infiniband, bei EMC über Standard-Ethernet-Verbindungen. EMC offeriert auch keine SSD-Caches. Und anstatt auf Open-Source-Software setzt EMC auf eine proprietäre Entwicklung.

Open-Source plus Fujitsu-Management

Zusätzlich ergibt sich eine neue Dimension eines wirklich einfachen Disaster-Recovery durch die CD10000. Für katastrophensichere Konfigurationen kann die Appliance gesplittet und über zwei oder mehrere Standorte verteilt werden. Nur ein mögliches Szenario hierbei (von vielen anderen denkbaren): Die Daten am primären und am sekundären Standort werden je nach definiertem SLA jeweils redundant gespeichert. Dadurch ist einerseits an jedem Standort die Verfügbarkeit im Falle von Fehlern an Festplatten und Speicherknoten gewährleistet, und andererseits eine gegenseitige Absicherung gegen den Ausfall eines kompletten Standorts gegeben.

Fujitsu hat überdies eine GUI entwickelt, über die die gesamte Appliance gemanagt wird – inklusive der Verwaltung der Open-Source-Software Ceph; letztere erfolgt normalerweise über Kommandozeilen, und benötigt eigentlich tiefgreifendere Kenntnisse. Deshalb wurde das Fujitsu-Management-Tool so ausgelegt, dass es als zentrale Instanz sowohl für Software-Deployment als auch für Aufgaben wie Netzwerk- und Cluster-Management fungiert. Außerdem wurden erweiterte Funktionen integriert, die beispielsweise die Konfiguration vereinfachen soll.

Fazit: Weniger Administrations- und Betriebskosten

Unterm Strich resultieren alle Features für Anwender der Eternus CD10000 in einem wesentlich einfacheren Lifecycle-Management. Implementierung, Inbetriebnahme sowie Abstimmung der Komponenten und Tests nebst dem eigentlichen Betrieb erfordern deutlich weniger Zeit, als dies Administratoren von anderen Systemen her kennen. Das bedeutet sowohl niedrige Administrations- als auch Betriebskosten. Die Betriebskosten (TCO – Total Cost of Ownership) dürften definitiv günstiger sein als bei anderen herkömmlichen hochkapazitiven Speichersystemen.

- Mehr Infos über Fujitsu-»ETERNUS CD«-Serie

- »ETERNUS CD10000« ist eines der Highlights auf dem »Fujitsu Forum 2014« nächste Woche

- Fujitsu stellt Failover-Lösung »ETERNUS Storage Cluster« vor

- Fujitsu bringt LTO-6-Bandsystem »Eternus LT260« speziell für KMUs

- Fujitsu sucht den ältesten Primergy-Server im Einsatz

- 50 PByte? Ihr könnt kommen!

- Openstack und Ceph bahnen sich ihre Wege

- Ceph und Fujitsu: eine sich bestens ergänzende Kombination

- Ceph schlägt RAID

- Die Hardware – optimiert und aufeinander abgestimmt

- Datenkommunikation in Hochgeschwindigkeit

- Und was ist mit der Konkurrenz?

- Open-Source plus Fujitsu-Management

- Fazit: Weniger Administrations- und Betriebskosten