IDC: Technology-Refresh treibt Datacenter-Verantwortliche um

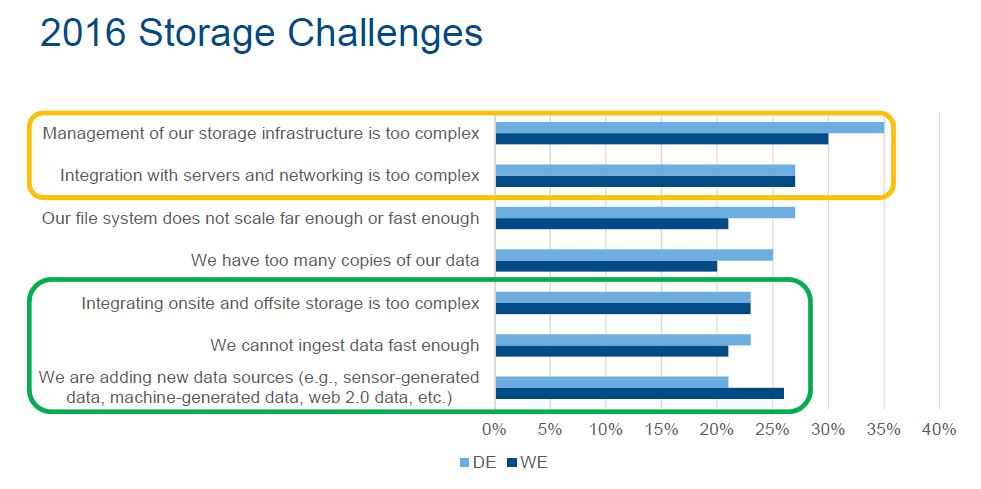

IT-Verantwortliche und Storage-Administratoren kämpfen gerade an neuen Fronten. Ungezähmtes Datenwachstum ist eines der Probleme, das allerdings durch neue Storage-Ansätze wie Software-defined Storage und Object-Storage gebremst werden oder zumindest kostengünstiger gestaltet werden könnte. Ein Nachbericht von der »IDC Directions: Storage Transformation 2016« letzte Woche in Frankfurt.

»Und wenn man sich für Public-Cloud-Services oder Hybrid-Cloud entscheidet, sollte man Information-Governance miteinbeziehen«, erläuterte IDC-Analystin Carla Arendt auf der »IDC Directions: Storage Transformation 2016« letzte Woche in Frankfurt. »Wobei allerdings die Entscheidung für Private-Cloud eher die Wahl zwischen Do-it-yourself-Integration, integrierten Systemen oder Hyperconverged-Systemen beinhaltet.«

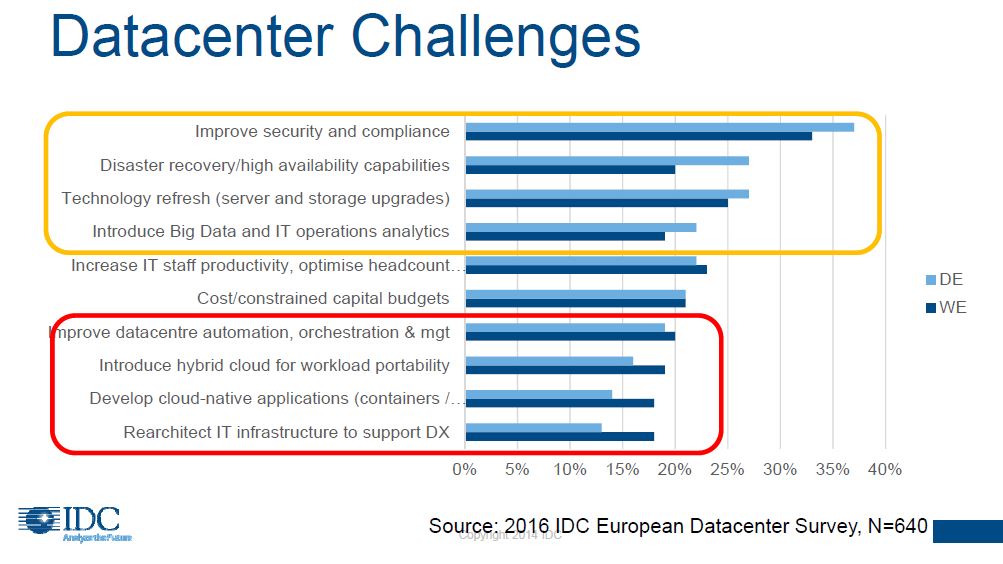

Arendt hatte mit der »2016 IDC European Datacenter Survey« eine aktuelle Studie mit im Gepäck. Für die Untersuchung konnten teilweise über 900 Antworten ausgewertet werden, die Studie gilt also als sehr repräsentativ für Europa. »Security ist eine konstante starke Herausforderung fürs Datacenter«, bekundete Arendt. »Aber was jetzt die Verantwortlichen zusätzlich umtreibt, ist dieser enorme Technology-Refresh.«

Deutschland investiert noch etwas zögerlich bei Flash – aber vermutlich nicht mehr lange

Cloud-Storage scheint wohl bald ein intensiveres Thema mit dem deutlich anziehenden Anfall von Datenmengen aus dem Internet der Dinge (IoT, Internet of Things) zu werden. »IoT-Daten sind regelrecht prädestiniert für die Cloud, und mit Object-Storage können sie kostengünstig gleich in der Cloud abgelegt werden«, meinte Arendt. Auch für die Daten aus Big-Data-Applikationen sei Object-Storage und die Cloud eine in Betracht zu ziehende Technologie: »Big-Data-Leute löschen nur sehr sehr ungern – denn vielleicht braucht man die Daten ja noch.«

EU-Datenschutz-Grundverordnung (DSGVO) bringt ILM und Information-Governance zurück

Von den Besuchern sehr interessiert verfolgt wurden auch Arendts Ausführungen über die neue EU-Datenschutz-Grundverordnung (EU-DSGVO, oder auch »General Data Protection Regulation«, GDPR). da diese erst im Mai Gesetz wurde. Es ist das erste EU-Gesetz, das sich mit Datenschutz befasst. Die Strafen bei Verstößen sind drakonisch: bis zu vier Prozent eines Unternehmensjahresumsatzes.

»Früher waren die Strafen eher kleinere Strafzettel, da lohnte es sich nicht, deswegen in neue Technologien zu investieren«, meinte Arendt. Aber das sei nun anders: Vier Prozent vom Umsatz – da lohne sich ein Investment in neue Technologien. »Es ist auch für Unternehmen die Chance, sich nun endlich strategisch neu aufzustellen«, erklärte Arendt. In diesem Zusammenhang erwartet sie eine Renaissance von Disziplinen wir Information-Lifecycle-Management (ILM) und Information-Governance.

Über alle diese Themen sprachen wir auch im Vorfeld der Veranstaltung in Frankfurt mit Carla Arendt in einem Podcast. Hören Sie sich hier den sehr informativen speicherguide.de-Podcast mit IDC-Analystin Carla Arend über die durch die Digitale Transformation ausgelösten Veränderungen im Datacenter an.

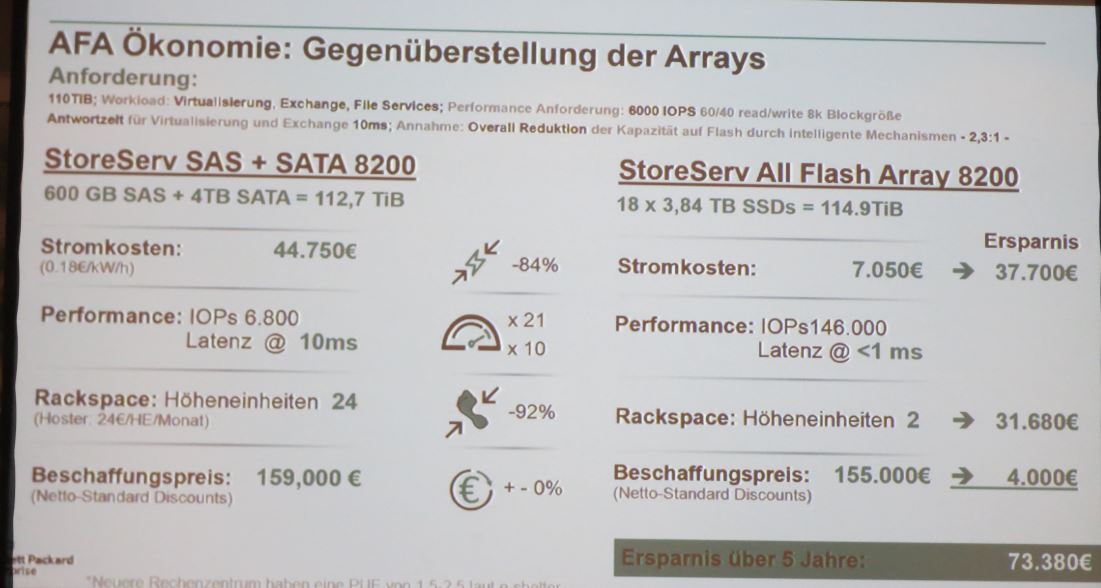

HPE: All-Flash ist Kernstück einer Digitalen Transformation

Der HPE-Manager hält All-Flash-Lösungen als Kernstück einer Digitalen Transformation: »All-Flash-Arrays haben 21 mal mehr Performance als Festplatten-Arrays, und eine zehnmal bessere Latenz – das ist Performance im Überfluss.« Klenner führte aus, dass All-Flash-Arrays kaum noch teurer sind als vergleichbare Festplattensysteme. Und wenn ein Administrator in die TCO-Kostenbetrachtung einsteige, dann seien die »Einsparungen bei den Stromkosten und beim Platzbedarf über einen Zeitraum von fünf Jahren beträchtlich.«

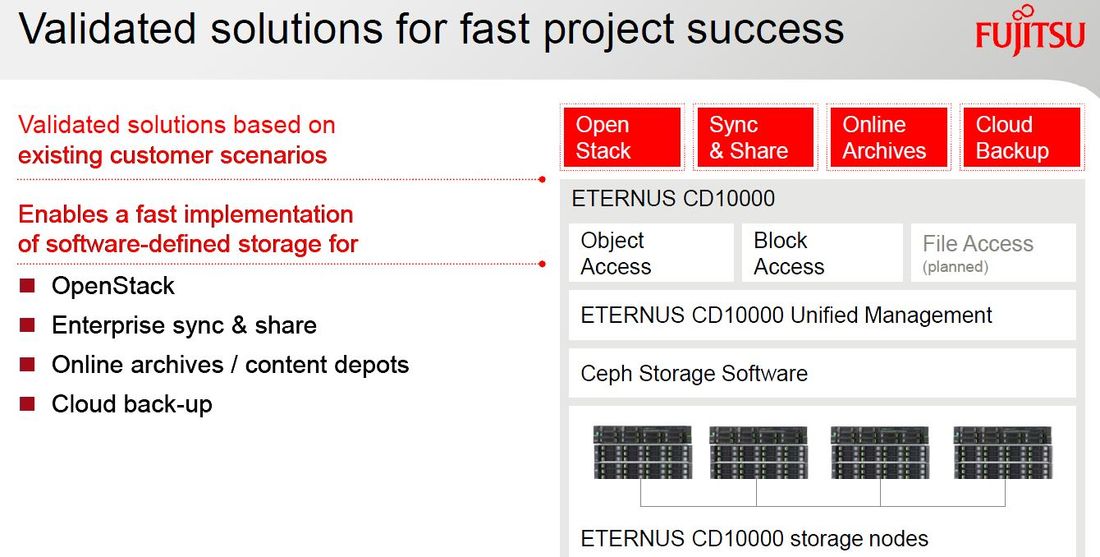

Fujitsu: Digitale Transformation wirkt sich aufs Backup aus

Schneider rät Unternehmen, sich unter anderem mit Object-Storage zu befassen: »Alleine wegen der Hyperskalierbarkeit werden hier viele einsteigen müssen.« Und das Thema effizientes Copy-Data-Management werde nun drängender. »Viele Unternehmen haben von einer Datei bestimmt fünf Kopieren, evtl. sogar zehn oder 15«, erläuterte Schneider. Beim Copy-Data-Management arbeitet Fujitsu mit CommVault zusammen, beim Snapshot-Management pocht man auf die eigene Lösung »Fujitsu ESM« (Enterprise Snapshot Management).

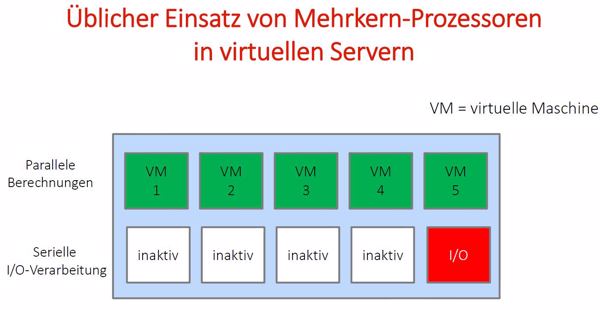

Datacore: Parallel-I/O-Technologie lässt Server abheben

Mit der Parallel-I/O-Technologie lässt sich der I/O-Durchsatz von Server endlich richtig beschleunigen. Hintergrund ist, dass bisher bei vielen Servern mit beispielsweise zehn VMs (Virtuelle Maschinen) nur eine VM für das I/O-Handling zuständig war, den sich die anderen VMs teilen mussten. »Dieses serielle I/O war der Flaschenhals«, erläuterte Best. »Viele Unternehmen umgingen dies, in dem sie mehr ESX-Server installierten, um die I/O-Last zu verteilen.« Doch letztendlich ist es eine Notlösung, die überdies ziemlich teuer ist. Mit der Parallel-I/O-Technologie wird nun das I/O-Handling parallelisiert. Best zeigte anhand von Benchmarks auf, dass bereits Midrange-Server zusammen mit dem Datacore-Paket sogar deutlich teurere Systeme locker übertrumpften.

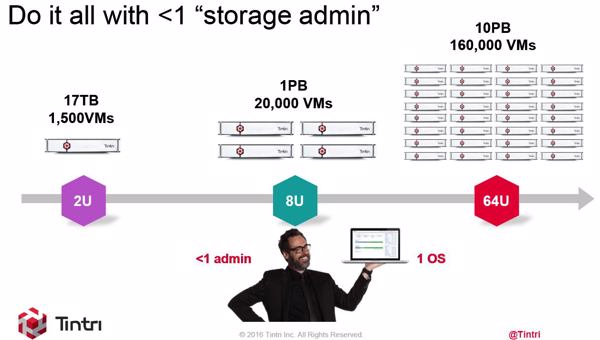

Tintri: so spricht Storage die Virtualisierungs-Sprache

Wesentlicher Effekt dabei ist laut Münzner, dass sich Administratoren nur noch um ihre VMs kümmern müssen, das klassische Storage-Management falle bei Tintri komplett weg: »VM-Administratoren sind automatisch dann auch die Storage-Administratoren, aber ohne die Komplexität. Wir brauchen keine LUNs mehr als Abstraktonsschicht, sondern kümmern uns nur noch um die VMs.« Tintri-Storage-Systeme seien aus VM-Sicht nur ein großer Data-Store.

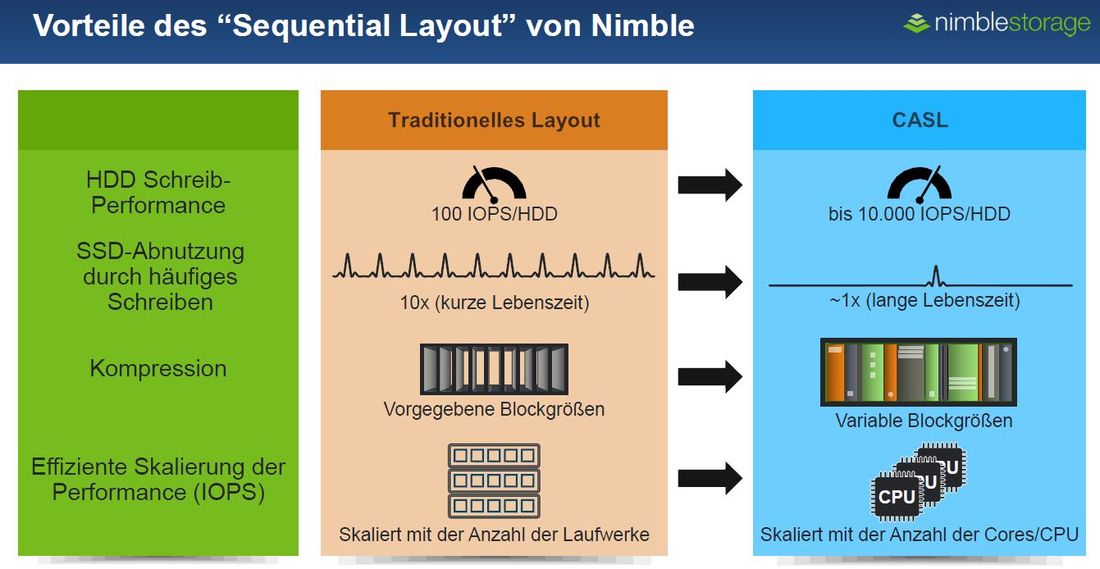

Nimble schwört auf Flash-optimiertes File-System CASL

Eine weitere Besonderheit von Nimble ist die Predictive-Flash-Plattform »InfoSight«. Dieses Analyse-Tool beherrscht neue Überwachungsfähigkeiten auf VM-Ebene, wodurch das proaktive Lösen von Ressourcenkonflikten ermöglicht wird. Infosight sammelt von allen Nimble-Systemen draußen im Feld Sensordaten, und erkennt mit diesem Big-Data-Datenanfall zeitnah, wo sich ein Problem ergeben könnte. »Wir brauchen deshalb keinen Level-1- und -2-Support mehr«, betonte Becker. In den USA würden erste Kunden kein Backup mehr machen, sondern sich mit Nimble voll auf die Snapshots verlassen.

- IDC

- Datacore Software

- Storage von Fujitsu

- Hewlett Packard Enterprise Deutschland (HPE)

- Nimble Storage

- Tintri

- speicherguide.de-Video-Interview mit IDC-Consultant Matthias Zacher über die zurückgehenden Sicherheitsbedenken gegenüber der Cloud

- Studie von Fujitsu über Digitale Transformation: Ein Drahtseilakt steht bevor

- White-Paper von Kroll Ontrack beleuchtet EU-Datenschutz-Grundverordnung

- Mehr Infos über Rechenzentren und Datacenter im speicherguide.de-Schwerpunkt

- IDC: Technology-Refresh treibt Datacenter-Verantwortliche um

- Deutschland investiert noch etwas zögerlich bei Flash – aber vermutlich nicht mehr lange

- EU-Datenschutz-Grundverordnung (DSGVO) bringt ILM und Information-Governance zurück

- HPE: All-Flash ist Kernstück einer Digitalen Transformation

- Fujitsu: Digitale Transformation wirkt sich aufs Backup aus

- Datacore: Parallel-I/O-Technologie lässt Server abheben

- Tintri: so spricht Storage die Virtualisierungs-Sprache

- Nimble schwört auf Flash-optimiertes File-System CASL