Storage: Gründe für Hyperkonvergenz und HCI-Lösungen

Bei einer hyperkonvergenten Infrastruktur (HCI) sind Rechen- und Speicher-Ressourcen in einen Appliance-ähnlichen Knoten kombiniert. Das ist ein Standard-x86-Server, der als Baustein für die gesamte Infrastruktur dient. Im Vergleich zu spezialisierten Storage-Arrays, Servern und anderer Hardware sind diese Bausteine günstiger. Um eine HCI zu erweitern, reicht es zudem, weitere Knoten hinzuzufügen. Dadurch kommen gleichzeitig mehr Rechenleistung und mehr Speicherplatz hinzu.

Das war zunächst in Szenarien beliebt, bei denen Rechenleistung und Speicherplatz relativ linear zunehmen. Paradebeispiel ist eine virtuelle Desktop-Infrastruktur (VDI). Hier feierten die Anbieter hyperkonvergenter Infrastruktur, etwa Nutanix und das 2017 von HPE übernommene SimpliVity daher auch ihre ersten großen Erfolge. Solche Projekte sind für sie nach wie vor ein wichtiges Standbein, aber eben nur noch eines von vielen. Zunehmend setzen sie sich auch in Bereichen durch, die früher Storage-Spezialisten vorbehalten waren.

Das klassische HCI-Konzept auf einen Blick übersichtlich dargestellt (Grafik: Vmware).

Das klassische HCI-Konzept auf einen Blick übersichtlich dargestellt (Grafik: Vmware).

Was HCI von klassischer IT-Infrastruktur unterscheidet

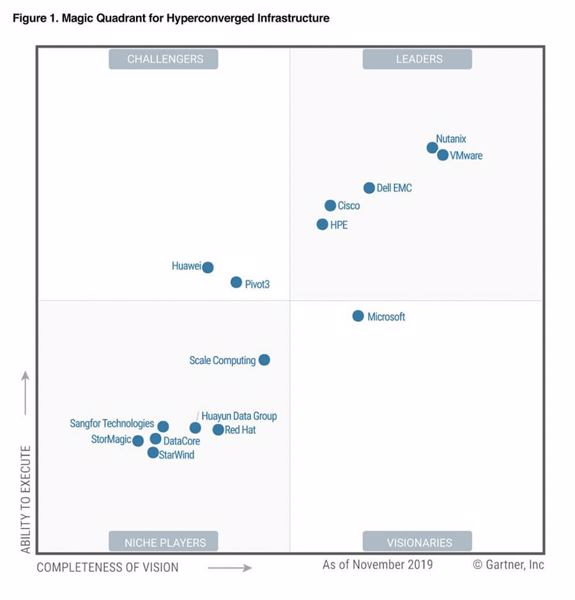

Gartner sieht die Software-Experten Nutanix und Vmware als führende HCI-Anbieter (Grafik: Gartner).Beim herkömmlichen Infrastrukturansatz widmet sich jeder Prozessor zusammen mit dem angeschlossenen Arbeitsspeicher, der Storage-Kapazität und der Netzwerkanbindung einer bestimmten Anwendung. Die klassische Virtualisierung sorgt dafür, dass sich auf einem Prozessor mehrere virtuelle Maschinen ausführen lassen. Für jede virtuelle Maschine ist dabei jeweils ein Teil des verfügbaren Arbeitsspeichers und des Netzwerks reserviert. Der Zugriff auf die zentral vorgehaltenen Storage-Ressourcen erfolgt über das normale Netzwerk oder ein speziell für die Speicheranbindung entwickeltes Netzwerk.

Gartner sieht die Software-Experten Nutanix und Vmware als führende HCI-Anbieter (Grafik: Gartner).Beim herkömmlichen Infrastrukturansatz widmet sich jeder Prozessor zusammen mit dem angeschlossenen Arbeitsspeicher, der Storage-Kapazität und der Netzwerkanbindung einer bestimmten Anwendung. Die klassische Virtualisierung sorgt dafür, dass sich auf einem Prozessor mehrere virtuelle Maschinen ausführen lassen. Für jede virtuelle Maschine ist dabei jeweils ein Teil des verfügbaren Arbeitsspeichers und des Netzwerks reserviert. Der Zugriff auf die zentral vorgehaltenen Storage-Ressourcen erfolgt über das normale Netzwerk oder ein speziell für die Speicheranbindung entwickeltes Netzwerk.

Konvergente und hyperkonvergente Systeme bieten Speicherplatz wieder lokal an – also im selben Gerät wie den Prozessor. Virtuelle Maschinen erhalten in einer HCI neben Memory und Netzwerk-Ressourcen auch eine gewisse Kapazität an lokalem Speicher. Gleichzeitig wird im hyperkonvergenten Modell der lokal angebundene Speicher aller HCI-Nodes aber zu einem Storage-Pool zusammengefasst. Er stellt sich daher auch als zentrale, für alle virtuellen Maschinen verfügbare Ressource dar.

Hyperkonvergenz brachte damit eine tiefgreifende Veränderung für den Umgang mit Storage. Bei zentralisierten Speicherkonzepten sind die einzelnen Storage-Systeme skalierbar. Bei Hyperkonvergenz ist dagegen der Speicherplatz über alle Komponenten hinweg skalierbar. Der virtuelle Speichermanager erkennt den mit jedem neuen Knoten hinzugekommenen, zusätzlichen Speicherplatz und integriert ihn in den gemeinsam genutzten Pool. Dadurch sind hyperkonvergente Systeme bei Konfiguration und Skalierung flexibler, oft günstiger und die Abhängigkeit von einem spezialisierten Hardware-Hersteller ist geringer.

Außerdem biete HCI einfache Scale-out-Möglichkeiten. Bei zusätzlichem Bedarf lassen sich in einer HCI weitere Appliances hinzufügen, um dadurch die Systemleistung insgesamt zu erhöhen. Die verfügbaren Ressourcen bilden einen Gesamt-Pool, aus dem sie den einzelnen Anwendungen und Aufgaben zugewiesen werden. Dieses Workload-Management übernimmt die HCI-Software. Sie ist deshalb schon immer wichtiger gewesen als die Hardware-Appliance, die recht austauschbar ist.

Allerdings haben unterschiedliche Hersteller sich mit dieser Austauschbarkeit der Hardware unterschiedlich schnell abgefunden. Die Herangehensweise hatte nur zum Teil etwas mit technischer Überzeugung zu tun, zum großen Teil wurde sie auch davon beeinflusst, wie viel der jeweilige Anbieter durch diesen Schritt zu verlieren hatte. Für Newcomer wie Nutanix, oder Pivot3 spielte es zum Beispiel eine geringere Rolle, ob Umsätze mit Hard- oder Software oder mit Appliances erzielt wurden. Alteingesessene Server- und Storage-Lieferanten wie Dell, EMC, Fujitsu, HPE, IBM und Lenovo profitierten dagegen durchaus vom Status Quo, bei dem Kauf, Implementierung und Nutzung eher eine Geheimwissenschaft als Allgemeinwissen waren. Dell und Lenovo gaben den Widerstand schnell auf, Fujitsu und HPE etwas später. Cisco blieb bisher bei seinem Credo, nur durch die Bündelung in seinen Produkten die maximalen Leistungsvorteile bieten zu können.

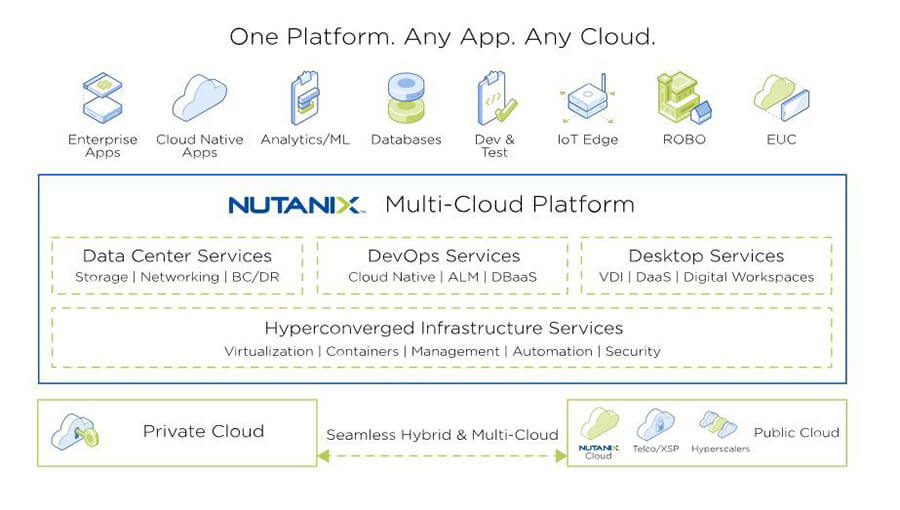

Mit den jüngsten Erweiterungen seiner SAP-Zertifizierungen ist Nutanix seinem Plattformanspruch wieder ein Stück nähergekommen (Grafik: Nutanix).

Mit den jüngsten Erweiterungen seiner SAP-Zertifizierungen ist Nutanix seinem Plattformanspruch wieder ein Stück nähergekommen (Grafik: Nutanix).

Kann Hyperkonvergenz Storage einfacher machen?

Das technische Ziel bei Hyperkonvergenz ist es, alle Ressourcen zusammenzuführen, die erforderlich sind, um Anwendungen auszuführen. Dadurch brauchen Unternehmen auch beim Personal nicht mehr einzelne Spezialisten für Storage, Netzwerk und Server. Dafür benötigen sie Virtualisierungs-Spezialisten. Die Hersteller liefern bereits einen kompletten Hard- und Software-Stack. Darum müssen sich die Anwenderunternehmen nicht mehr kümmern. Ihnen kann es egal sein, welcher Prozessor und welche Laufwerke verbaut sind und wie die Datenübertragung konzipiert ist: Die Plattform läuft, sie jonglieren darauf mit den Anwendungen.

Damit ist auch das organisatorische Ziel aller HCI-Angebote beschrieben: die radikale Vereinfachung des Umgangs mit der Infrastruktur. Eigene Infrastruktur soll genauso einfach zu verwalten sein, wie die gängigen Public-Cloud-Angebote. Ein weiterer wichtiger Vorteil von Hyperkonvergenz ist dann, dass Unternehmen Anwendungen schnell bereitstellen können, ohne sie langwierig konzipieren, erstellen und testen zu müssen. Unternehmen kümmern sich nicht mehr um die einzelnen Infrastruktur-Silos, sondern können sich auf eine sehr skalierbare Infrastrukturplattformen verlassen, auf der sie ihre Anwendungen ausführen. Und vielfach lässt sich diese Plattform in die Cloud verlängern oder mit Cloud-Angeboten kombinieren. Nicht umsonst ist VMware in den Markt für HCI-Software eingestiegen und wirbt Nutanix um Cloud-Anbieter.

HCI ist also nicht nur eine Sichtweise, in welchem Formfaktor Rechenleistung und Speicherkapazität ausgeliefert werden sollen. HCI ist auch ein Umdenken was die Bedeutung von Hard- und Software anbelangt. Software und Anwendungen rücken in den Vordergrund. Die Hardware wird als selbstverständlich verfügbar, standardisiert und erweiterbar vorausgesetzt. Leistung und Zuverlässigkeit hängt nicht mehr von der meisterhaft konstruierten Hardware ab, sie werden bei HCI durch elegante Lösungen in der Software und bei Bedarf durch mehr Standard-Hardware gewährleistet.

Unterschiede zwischen HCI und SDDC

Allerdings ist HCI nicht mit einem Software-defined Datacenter (SDDC) gleichzusetzen. Dessen Ideal ist es, Systeme immer unmittelbar an die Anforderungen der Workloads anzupassen. Die Funktionsweise der Infrastruktur wird im SDDC nicht mehr von der Hardware vorgegeben, sondern von den Anforderungen der genutzten Software.

Hyperkonvergenz ist dagegen eher eine Strategie auf dem Weg zu einem SDDC, ein Ansatz, um aus den hochspezialisierten Systemen im Rechenzentrum hochflexible, leicht verwaltbare und einfach skalierbare Bausteine zu machen. HCI-Software sorgt zusätzlich dafür, deren Verwaltung unter einem neuen, gemeinsamen Dach zu konsolidieren, die Arbeitslast über alle Bausteine zu verteilen und die Zuverlässigkeit des Gesamtsystems sicherzustellen. HCI-Software löst so das bisher auf die Verwaltung der Infrastruktur ausgerichteten Betriebsmodell für Rechenzentren ab. Dafür rückt das Management von Anwendungen in den Vordergrund.

Kein Wunder daher, dass neben dem HCI-Pionier Nutanix, der sich inzwischen weitgehend auf die Bereitstellung von Software konzentriert und die Hardware Technologiepartnern wie Dell EMC, Fujitsu, HPE und Lenovo überlässt, sich aus Sicht der Marktforscher auch Software-Spezialist Vmware schon kurz nach seinem Einstieg in den Markt eine führende Position sichern konnte. Red Hat, das 2017 auf den Zug aufgesprungen ist, hat diesen Weg noch vor sich. Es positioniert sich – wie bei seinen anderen Produkten – auch hier als offene, kostengünstigere Alternative und Möglichkeit, einen Vendor-Lock-in zu vermeiden.

Adaption von HCI und Hyperkonvergenz im Storage-Umfeld

Den 2018 von Datacore veröffentlichten Ergebnisse einer Umfrage unter 400 IT-Verantwortlichen nutzte damals bereits die Hälfte HCI-Technologie in irgendeiner Form. Allerdings hatten sich nur 21 Prozent dafür entschieden, bei Storage-Projekten auf HCI zu setzen. Deutlich mehr (37 Prozent) setzten auf Software-defined-Storage als Standardtechnologie. Für die kommenden Monate plante jeweils rund ein Fünftel, stark in einen dieser Ansätze zu investieren. Die hohe Akzeptanz mag auch durch die Auswahl der Befragten bedingt sein. Einer ebenfalls 2018 von Spiceworks durchgeführte Umfrage zufolge setzten erst 23 Prozent der Befragten in irgendeiner Form HCI ein, weitere 22 Prozent planten, dies im Lauf des Jahres 2019 zu tun.

In seinem Ausblick für 2020 gab sich Datacore in Bezug auf Hyperkonvergenz etwas zurückhaltender: »HCI ist im Wesentlichen eine Einheitslösung«, laute das Fazit vieler Firmen nach mehrjähriger Erfahrung damit. Zum Beispiel zeigten Big-Data-Analysen HCI die Grenzen auf. Außerdem würden auch bei den ursprünglichen HCI-Konzepten Ressourcen über- oder unterprovisioniert, da Speicher-, Rechen- und Netzwerkleistung zusammen skaliert werden – unabhängig davon, ob die Workloads vor allem mehr Rechenleistung oder mehr Speicher benötigen. Daher erwartet Datacore, dass HCI-Varianten wie disaggregierte HCI (dHCI), bei denen Storage-Kapazitäten und Rechenleistung unabhängig voneinander skalierbar sind, populärer werden. HPE hat diese Erwartung bereits eingelöst und auf Grundlage von Nimble Storage eine DHCI-Lösung im Angebot.

Bei einer disaggregierten HCI (dHCI) wie sie HPE anbietet, sind Storage-Kapazitäten und Rechenleistung unabhängig voneinander skalierbar (Bild: HPE).

Bei einer disaggregierten HCI (dHCI) wie sie HPE anbietet, sind Storage-Kapazitäten und Rechenleistung unabhängig voneinander skalierbar (Bild: HPE).

HCI-Anbieter könnte jedoch 2021 zu denen gehören, die von der Neuausrichtung der IT-Budgets als Reaktion auf die Corona-Pandemie gehören. Das legen zumindest die aktuellen Zahlen von Spiceworks zu den geplanten IT-Investitionen für 2021 nahe. Dem Bericht zufolge feiert VDI, lange das Vorzeigeszenario für den HCI-Einsatz, ein grandioses Comeback: 46 Prozent der Firmen planen hier zu investieren. Außerdem liegt das Interesse an Converged- oder Hyperconverged-Infrastructure, dass 2020 im Vergleich zu 2019 einen großen Sprung nach oben machte, auch 2021 deutlich höher (41 Prozent der Firmen) als 2019 (35 Prozent der Firmen). Allerdings sind diese Zahlen etwas US-lastig: 58 Prozent der untersuchten Firmen stammen von dort, nur 42 Prozent aus Europa.

Probleme bei Hyperkonvergenz und Storage

Die Nutzung hyperkonvergenter Infrastrukturen als SAN-Alternative hat zudem auch gezeigt, dass der Netzwerk-Aspekt nicht zu vernachlässigen ist. Da in einer HCI alle Knoten Daten vorhalten ist es wahrscheinlich, dass für den Zugriff auf die verteilt liegenden Daten der Netzwerk-Traffic zunimmt. Daher ist hier ein leistungsfähiges Netzwerk Voraussetzung für anspruchsvolle Storage-Aufgaben.

Das wiederum lässt den Bedarf nach leistungsfähigen Produkten für Software-defined Networking steigen. Es erfordert aber gerade in größere Unternehmen auch eine engere Zusammenarbeit zwischen den Netzwerk- und den Storage-Verantwortlichen. Ein weiteres Problem beim Zugriff auf Daten auf unterschiedlichen Knoten über das Netzwerk sind Latenzzeiten. NVMe-over-Fabrics (NVMe-oF) bietet hier eine Möglichkeit, die Reaktionszeit von Anwendungen gering zu halten.

Eine weitere Kardinalsfrage bei HCI-Projekten mit Storage-bezug ist die, ob eine konvergente Infrastruktur die im Rechenzentrum bereits vorhandenen Storage-Arrays mit einbeziehen sollte beziehungswiese kann, oder ob es sie ganz ersetzen sollte. Nutanix spricht sich diesbezüglich für einen toleranten Ansatz aus und plädiert für die Einführung einer so genannten Distributed Storage Fabric (DSF). Bei diesem Ansatz ist eine der VMs, die in jedem HCI-Knoten ausgeführt werden, eine Controller-VM, die sich der Speicherverwaltung annimmt. Gemeinsam überwachen sie alle zusammen einen virtualisierten Speicher-Pool, der sowohl vorhandene HDDs als auch Flash-Arrays umfasst. Innerhalb dieses Pools implementiert Nutanix ein eigenes System von Redundanzen und Zuverlässigkeitsprüfungen, das ohne ein herkömmliches RAID auskommt.

Dell EMC bleibt seinen SAN- und NAS-Serien treu

Zum Beispiel Dell EMC kann es sich dagegen nicht leisten, die bewährten SAN- und NAS-Produktreihen von heute auf morgen zum alten Eisen zu werfen. In seiner zusammen mit Vmware konzipierten, VxRail genannten Variante eines HCI-Knotens setzt Dell EMC daher auf eine Abstraktionsschicht für Software-defined Storage (SDS). Parallel, aber in letzter Zeit etwas zurückhaltender, bietet der Konzern mit der Produktreihe Dell EMC XC aber auch Appliances auf Basis von Dell EMC Poweredge-Servern und Nutanix-Software an.

Cisco partnert mit Vmware

Cisco nutzt bei seinem, HyperFlex (HX) genannten HCI-Konzept, dagegen auch eine Controller-VM auf jedem Node, sorgt dabei aber für eine dauerhafte Verbindung zum ESXi-Hypervisor von Vmware. Naturgemäß betont Cisco die Vorteile seines strategischen Ansatzes in Bezug auf Networking. Darüber hinaus legt es aber auch auf die Möglichkeiten Wert, die sich durch das Einziehen unterschiedlicher Abstraktionsschichten ergeben – etwa in Bezug auf die Multi-Cloud-Unterstützung. Doch auch Cisco sieht Grenzen des HCI-Konzeptes da, wo es um sehr spezielle Anwendungen geht.

Big-Data und HCI

Beispiele dafür waren lange Zeit etwa Big-Data-Anwendungen mit Hadoop, Spark oder SAP HANA. Aber auch hier hat sich etwas getan. SAP hat 2018 die Möglichkeiten von HCI erkannt und zuerst AHV von Nutanix und dann auch Vmware auf Lenovo-Hardware für SAP HANA zertifiziert. Erst kürzlich hat zudem Nutanix durch die erweiterte Zertifizierung für Scale-out für SAP HANA sein Einsatzspektrum noch einmal deutlich erweitert. Auch für Hortonworks auf Nutanix oder andere Big-Data-Anwendungen auf Nutanix gibt es inzwischen Erfahrungen und Best-Practices.

HCI bedrängt Legacy-Speicher

Wie wir alle wissen, verdrängen in der IT neue, erfolgreiche Ansätze zwar oft schnell bewährte Technologien aus dem Vordergrund. Dennoch versehen auch die abfällig als »Legacy« bezeichneten Produkte und Technologien noch Jahre oder sogar Jahrzehnte zuverlässig und erfolgreich ihren Dienst. Der Markt für Enterprise-Storage ist hierfür besonders prädestiniert – schließlich geht es dabei in vielen Fällen per Definition um die langfristig sichere Speicherung von Daten. Dennoch deutet inzwischen alles darauf hin, dass bei neuen Storage-Projekten oder zur Erweiterung der Storage-Umgebung die Möglichkeiten von HCI zumindest mit in Betracht gezogen werden sollten. Argumente dagegen gibt es immer weniger.

- IDC: Auch der Markt für konvergente Systeme lässt im Q2/20 nach

- Für und Wider von Hyperkonvergenz

- Hyper-Konvergenz kontra Besitzstandswahrung

- Podcast: Was ist Hyperkonvergenz?

- Linzmeier mit Hyperkonvergenz in neue Leistungsliga

- Hyperkonvergenz – SAN zweiter Klasse?

- Unterschied zwischen Unified- und Converged-Storage

- Mythen rund um Hyper-Konvergenz