Symantec flanscht mit Hortonworks an Hadoop an

Das Unternehmen Hortonworks ist anerkannter der Spezialist für das Apache-Framework Hadoop – und Hortonworks ist dank Big-Data-Trend regelrecht umworben. Nun hat Symantec die Hilfe in Anspruch genommen, um endlich an Hadoop anzuflanschen und auf Big Data richtig fokussieren zu können. Gemeinsam entwickelt haben die Firmen nun das Modul »Symantec Enterprise Solution for Hadoop«, das eine Zusatzfunktion für Symantecs Cluster-File-System darstellt. So können Kunden von Symantec ihre Analysen von Big Data nun auf bereits bestehender IT-Infrastruktur durchführen.

Unternehmen haben Zeit und Ressourcen investiert, um ihre Rechenzentren mit Virtualisierungstechnik zu konsolidieren und so den Schritt zu Cloud-Computing vorzubereiten. Nun sind sie gefragt, auf dieser Infrastruktur Big-Data-Konzepte umzusetzen, mit denen sie bestehende Daten auswerten und neue geschäftsrelevante Einsichten finden wollen. Diese zusätzliche Aufgabe sollte die erreichten Ziele bei der Konsolidierung von Rechenzentren und Speicherressourcen berücksichtigen.

Symantec Enterprise Solution for Hadoop skaliert bis 16 PByte

Mit dem neuen Modul können Unternehmen nun Apache Hadoop firmenweit einsetzen und Big-Data-Analysen einführen, ohne groß in eine parallele IT-Infrastruktur investieren zu müssen. Die gemeinsame Lösung von Symantec und Hortonworks skaliert bis zu 16 PByte, und bindet sowohl strukturierte als auch unstrukturierte Daten ein. Das Add-on sorgt laut Symantec zudem dafür, dass nicht zu viele Speicher- als auch Rechenressourcen für die Analye von Big Data geblockt werden.

Bei der Implementierung werden im ersten Schritt die zu analysierenden Daten in die Infrastruktur von Hadoop geleitet. Durch das neue Modul können Firmen ihre bestehende Speicherinfrastruktur nun an die Hadoop-Installation koppeln, und so zeitaufwändige und teure Datenbewegungen vermeiden. Das Add-on erlaubt Symantec-Angaben zufolge Administratoren, die Daten an ihrem üblichen Ort zu belassen und dort Analysen zu starten, ohne die Daten extrahieren, transformieren oder in ein separates Cluster laden zu müssen.

Neues Add-on steht ohne Aufpreis zur Verfügung

In einer Apache-Hadoop-Umgebung sind die Daten über verschiedene Knotenpunkte verteilt, und nur ein Metadaten-Server kennt ihren genauen Speicherort. Dadurch entsteht ein möglicher Leistungsengpass, der zu einem Single-Point-of-Failure werden kann. Fällt der zentrale Server aus, könnte die gesamte Anwendung still stehen.

Symantec Enterprise Solution for Hadoop liefert Hochverfügbarkeit für das Dateisystem auf dem Metadaten-Server und sorgt zusätzlich dafür, dass die Analyseapplikationen weiterläuft, solange mindestens ein Knotenpunkt im Cluster funktioniert. Symantec ersetzt hierzu das Hadoop-File-System mit seinem eigenen Cluster-File-System, wodurch jeder Knotenpunkt simultan auf die Daten zugreifen darf. Dadurch sollen sowohl der Leistungsengpass als auch der Single-Point-of-Failure aufgehoben werden.

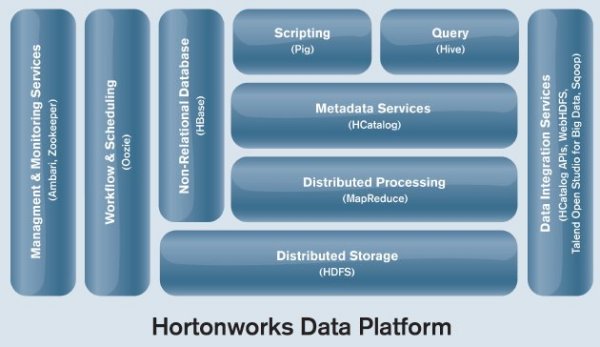

Das neue Add-on steht Anwendern von Symantecs Cluster-File-System ab sofort ohne Aufpreis zur Verfügung. Es unterstützt die Hortonworks Data Platform (HDP), Version 1.0 sowie Apache Hadoop, Version 1.0.2.

- Symantec

- Hortonworks

- Targosoft startet Sommeraktion mit Symantec-Backup-Appliance

- speicherguide.de-Interview mit Symantec-Manager Andreas Bechter über neue Anforderungen an Administratoren von KMUs in virtualisierten Rechenzentren

- Symantec wechselt CEO aus: Steve Bennett kommt, Enrique Salem geht

- Symantec und Red Hat partnern bei Disaster-Recovery

- Dr. tec. Storage erklärt, welchen Einfluss Hadoop auf die Speicherlandschaft hat