Das ist Big Data: Facebook wächst täglich um 500 TByte

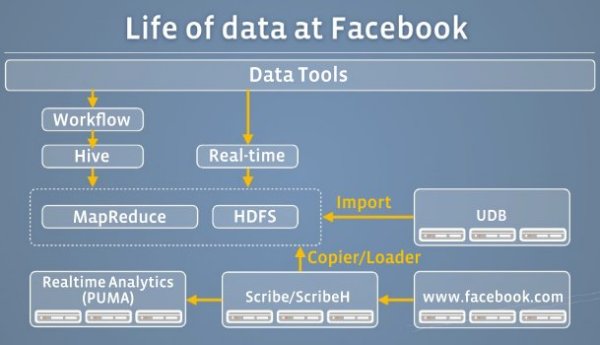

Gespeichert wird alles in einem Hadoop-Disk-Cluster, von dem Parikh ausgeht, dass er derzeit der größte der Welt ist. Hadoop ist ein Open-Source-Projekt der Apache Software Foundation. Erst kürzlich meldeten Symantec und Syncsort, ihre Softwarepakete mit Hadoop zu verknüpfen. Auch Storage-Systemehersteller wie EMC, Hewlett-Packard oder IBM nehmen sich Hadoop an. Nicht nur Branchenanalysten wie IDC sind deshalb der Meinung, dass Hadoop zum Überflieger wird. Hadopp scheint die Storage-Branche umzukrempeln.

Facebook bedeutet: 300 Millionen neue Fotos täglich

Interessant auch, wie sich die tägliche 500-TByte-Daten zusammensetzt. Verursacht wird sie unter anderem durch mehr als 2,5 Milliarden Postings, 2,7 Milliarden Likes sowie 300 Millionen neu hochgeladenen Bildern.

Hadoop ist hier insofern bedeutend, da sich aus diesen Big-Data-Volumina Nutzerreaktionen in Minutenschnelle herausfiltern lassen. Facebook könne dadurch laut Parikh ein neues Produkt innerhalb von Minuten aufsetzen, Nutzerreaktionen schneller und besser verstehen, und ein Design möglicherweise in Echtzeit modifizieren. »In wenigen Monaten sind Data-Warehouses mit 100 PByte nichts besonderes mehr«, unkte Parikh. Bedeutender sei vielmehr, die richtigen und wertvollen Informationen daraus zu ziehen. »Die Welt wird hungriger und hungriger nach Daten.«

Der Facebook-Technikchef gab auch erste Einblicke in das Projekt »Prism«. Facebook ist hierbei dabei, den bislang monolithischen Datenblock auf fünf Datacenter aufzusplitten. Und zwar auf die vier US-Bundesstaaten Kalifornien, Virginia, Oregon und North Carolina sowie auf ein neues Datacenter in Schweden. Von außen soll alles wie ein einziges Datacenter aussehen.

.