HPE demonstriert ersten Prototyp des The-Machine-Projekts

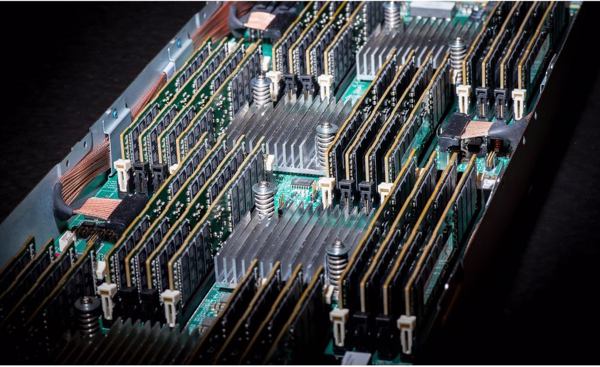

»The Machine«-Projekt: der Speicher ist im Zentrum, nicht der Prozessor (Bild: HPE)Seit über fünf Jahren arbeitet Hewlett Packard Enterprise (HPE) an einer vollkommen neuen Computing-Architektur namens »The Machine«. Das Ziel des IT-Konzern ist ehrgeizig: The Machine soll die »weltweit erste Arbeitsspeicher-zentrische Computer-Architektur« werden, und damit die seit rund 60 Jahren gebräuchlichen Rechnerarchitekturen ablösen. Auf der derzeit tagenden Hausmesse »Discover« in London wurde nun der erste Prototyp des The-Machine-Projekts demonstriert.

»The Machine«-Projekt: der Speicher ist im Zentrum, nicht der Prozessor (Bild: HPE)Seit über fünf Jahren arbeitet Hewlett Packard Enterprise (HPE) an einer vollkommen neuen Computing-Architektur namens »The Machine«. Das Ziel des IT-Konzern ist ehrgeizig: The Machine soll die »weltweit erste Arbeitsspeicher-zentrische Computer-Architektur« werden, und damit die seit rund 60 Jahren gebräuchlichen Rechnerarchitekturen ablösen. Auf der derzeit tagenden Hausmesse »Discover« in London wurde nun der erste Prototyp des The-Machine-Projekts demonstriert.

Der Hintergrund des Entwicklungsprojekts klingt relativ simpel: Nach Ansicht von HPE sind aktuelle IT-Architekturen nicht geeignet, die künftigen Aufgaben, die durch Cloud-Computing und das Internet der Dinge (IoT) sowie mobile Netzwerke, Machine-Learning und Machine-to-Machine-Computing auf sie zukommen, überhaupt noch vernünftig zu bewältigen. Bei der Architektur von HPE gibt es nämlich einen fundamentalen Unterschied: nicht mehr der Prozessor, sondern der Arbeitsspeicher steht im Zentrum. Die neue Architektur steht denn auch für »Memory-Driven Computing«. Und damit soll sich eine bisher nicht erreichte Leistung und Effizienz erzielen lassen.

»Wir haben einen großen Meilenstein mit unserem Forschungsprojekt The Machine erreicht - einem der größten und komplexesten Forschungsprojekte in unserer Firmengeschichte«, sagt Antonio Neri, Executive Vice President und General Manager der Enterprise Group bei HPE. »Mit diesem Prototyp haben wir das Potenzial des Memory-Driven Computings demonstriert und gleichzeitig die Tür für sofortige Innovationen geöffnet. Unsere Kunden und die gesamte Industrie werden von diesen Fortschritten profitieren, indem wir unser Streben nach wegweisenden Technologien fortsetzen.«

»The Machine«-Projekt: das wurde demonstriert

Antonio Neri, Executive Vice President und General Manager, Enterprise Group, HPEDer Prototyp ist seit Oktober in Betrieb und zeigt, wie die Bausteine der neuen Architektur zusammenarbeiten. HPE hat in London damit Folgendes demonstriert:

Antonio Neri, Executive Vice President und General Manager, Enterprise Group, HPEDer Prototyp ist seit Oktober in Betrieb und zeigt, wie die Bausteine der neuen Architektur zusammenarbeiten. HPE hat in London damit Folgendes demonstriert:

► Rechner-Knoten greifen auf einen gemeinsamen Pool von Fabric-Attached-Memory zu;

► ein optimiertes Linux-Betriebssystem läuft auf einem maßgeschneiderten System-on-a-Chip (SOC);

► Photonik/Optische Datenübertragung, einschließlich der neuen X1-Photonics-Module, ist online und funktionsfähig; und

► neue Entwicklungs-Werkzeuge, die eine Fülle an nicht-flüchtigem Arbeitsspeicher nutzen können.

Während der Entwicklungsphase des Prototyps wurde mithilfe von Simulationen errechnet, dass die neue Architektur im Vergleich zu heutigen Computern eine bis zu 8.000-mal schnellere Verarbeitungsgeschwindigkeit bei zahlreichen Workloads erzielen soll. HPE erwartet ähnliche Resultate, wenn die Kapazität des Prototyps um weitere Knoten und weiteren Arbeitsspeicher erweitert wird.

Das Machine-Forschungsprojekt soll zudem den Fokus auf das so genannte »Exascale Computing« legen – dabei handelt es sich um Hochleistungsrechner, die künftig eine Trillion Rechenoperationen in der Sekunde ausführen sollen. HPEs Memory-Driven-Computing-Architektur ist hoch skalierbar, von winzigen IoT-Geräten bis Exascale. Damit wird sie von HPE als eine ideale Grundlage für eine große Bandbreite an rechen- und datenintensiven Workloads positioniert, einschließlich Big-Data-Analytics.

Was erblickt das Licht der Welt von »The Machine«?

Wird »The Machine« als Ganzes einmal in ein Produkt überführt? Wohl eher kaum. Es dürfte wohl eher daraus hinauslaufen, einzelne Technologien des Memory-Driven-Computing in neuen und in bereits existierenden Produkten auf den Markt bringen. Diese Technologien, so war auf der Discovery zu vernehmen, lassen sich in vier Kategorien einteilen: Nichtflüchtiger Speicher, Netzwerk (Fabric, einschließlich Photonik), Ökosystem-Aktivierung und Sicherheit.

So arbeitet HPE eigenen Angaben zufolge daran, Byte-adressierbaren nichtflüchtigen Speicher auf den Markt zu bringen. Plan ist, diesen bereits 2018/19 vorzustellen. Mit Technologien aus dem The-Machine-Projekt wurde auch »HPE Persistent Memory« entwickelt – ein Schritt auf dem Weg zu Byte-adressierbarem, nichtflüchtigem Speicher, der darauf abzielt, die Leistung von DRAM und gleichzeitig die Kapazität und Beständigkeit von traditionellem Speicher zu bieten. Persistent Memory ist also eine Art DRAM mit integriertem Flash. Es wurde vor rund einem halbem Jahr in den HPE-Servern ProLiant DL360 und DL380 Gen9 eingeführt.

Fabric-Attached-Storage mit neuem Hochleistungs-Interconnect-Protokoll

Im Rahmen der Photonik-Forschung sollen beispielsweise die HPE-Synergy-Systeme, die im kommenden Jahr verfügbar sein werden, in Zukunft mit Photonik/optischen Technologien arbeiten können. Bereits 2018/19 plant HPE, Photonik in weitere Produktlinien, einschließlich des Storage-Portfolios, zu integrieren.

Das Unternehmen plant weiterhin, Fabric-Attached-Storage auf den Markt zu bringen, basierend auf dem Hochleistungs-Interconnect-Protokoll; dieses Protokoll wird von dem kürzlich gegründeten Gen-Z-Konsortium entwickelt, bei dem HPE Mitglied ist.

HPE baut am Ökosystem für Software rund um Memory-Driven Systems

In Sachen Software für Memory-Driven Systems betont HPE, bereits einiges auf den Weg gebracht zu haben. Dieses Jahr hat HPE eine Zusammenarbeit mit Hortonworks/Spark gestartet, um Software für Memory-Driven-Computing auf den Markt zu bringen. Seit Juni 2016 hat das Unternehmen außerdem Code-Pakete auf Github zur Verfügung gestellt, um Programmierer mit der neuen Memory-Driven Architecture vertraut zu machen.

HPE plant, den Code innerhalb des nächsten Jahres in bereits existierende Systeme zu integrieren und wird die nächste Generation von Analytics-Lösungen und -Anwendungen 2018/19 herausbringen. Als Mitglied des Gen-Z-Konsortiums wird HPE zudem Ökosystem-Technologien und Spezifikationen dieses Konsortiums in den nächsten Jahren in eine Reihe von Produkten integrieren.

Sicherheit wird essentiell, aber vieles noch im Entwicklungsstadium

Mit dem Prototyp demonstriert HPE eine neue, sichere Hauptspeicher-Vernetzung. HPE ist dabei der Überzeugung, dass Sicherheit in sämtlichen Hardware- und Software-Schichten integriert sein muss. HPE plant, diese Strategie nächstes Jahr mit weiteren Hardware-Sicherheitsfunktionen weiterzuverfolgen, gefolgt von neuen Software-Sicherheitsfunktionen in den nächsten drei Jahren. Ab 2020 plant das Unternehmen, diese Lösungen zusammen mit weiteren Sicherheitstechnologien zu kombinieren, die sich derzeit im Entwicklungsstadium befinden.

Behind »The Machine« Project

- Das ist das »The Machine«-Projekt von HPE

- Hewlett Packard Enterprise Deutschland (HPE)

- Präsentationen von der »Discover«, u.a. zum »The Machine«-Projekt

- HPE kündigt SDS- und Flash-Speicher zum Einstiegspreis an

- HPE bringt Hyperkonvergenz-System für den Mittelstand

- HPE fokussiert auf »CeBIT 2016« auf hybride Infrastrukturen und Cloud

- HPE Hewlett Packard Enterprise will Flash-Markt aufrollen