Secondary-Storage entscheidend für Erfolg von Speicherkonzepten

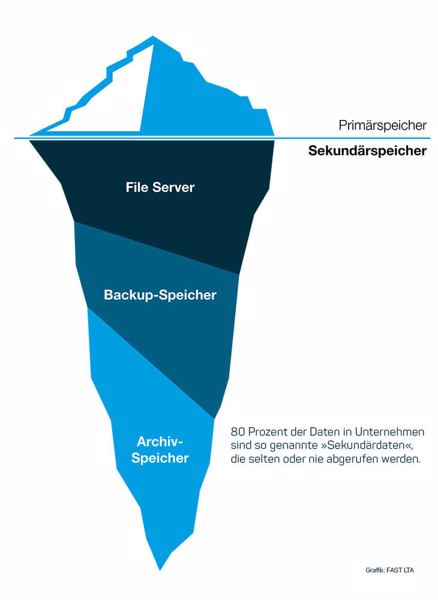

Der Großteil der erzeugten Daten sind Sekundärdaten, die selten benötigt werden (Grafik: Fast LTA). Die Unterteilung in »Primärdaten« und »Sekundärdaten« stammt aus der Zeit, in der die großen, monolithischen Systeme das Denken der Firmen-IT bestimmten. Ausgehend vom ERP-System wurde die gesamte IT drumherum organisiert. Schließlich war es als zentrale Instanz für Planung, Betrieb und Steuerung aller wichtigen Bereiche konzipiert. Was nicht in den Datenbanken dieser Systeme lag, konnte gar nicht wichtig sein – so die unterschwellige Annahme.

Der Großteil der erzeugten Daten sind Sekundärdaten, die selten benötigt werden (Grafik: Fast LTA). Die Unterteilung in »Primärdaten« und »Sekundärdaten« stammt aus der Zeit, in der die großen, monolithischen Systeme das Denken der Firmen-IT bestimmten. Ausgehend vom ERP-System wurde die gesamte IT drumherum organisiert. Schließlich war es als zentrale Instanz für Planung, Betrieb und Steuerung aller wichtigen Bereiche konzipiert. Was nicht in den Datenbanken dieser Systeme lag, konnte gar nicht wichtig sein – so die unterschwellige Annahme.

Sie war damals schon falsch. Seitdem hat aber die Bedeutung von unstrukturierten Daten außerhalb der wohlgeordneten und sorgsam behüteten Datenbanken der großen Software-Suiten noch stark zugenommen. Einerseits tragen dazu Richtlinien zu Aufbewahrung und Archivierung bei. Andererseits der Wunsch und die technischen Möglichkeiten, einmal gesammelte Daten später auszuwerten, um daraus Erkenntnisse zu gewinnen, mit denen sich geschäftliche Entscheidungen fällen und begründen lassen.

Sekundärdaten werden immer häufiger genutzt

Nach einer 2021 von IDC abgegebenen Schätzung wird die weltweite Datenmenge bis 2024 auf 143 ZByte anwachsen. Knapp ein Drittel der im Frühjahr 2021 von IDC in Deutschland befragten Unternehmen berichtete damals von einem jährlichen Datenwachstum zwischen 31 und 60 Prozent. Bei sechs Prozent der Befragten war es sogar noch deutlich mehr.

Dieses dynamische und heterogene Datenumfeld erfordert nach Ansicht von IDC neue Lösungsansätze. »Das große geschäftliche Potenzial der Daten lässt sich mit den vorhandenen Lösungen und Prozessen kaum erschließen und datengetriebene Geschäftsmodelle rücken damit hierzulande in weite Ferne«, sagt Matthias Zacher, Senior Consulting Manager bei IDC.

Für 37 Prozent der von IDC-Befragten ist die mangelnde Datenqualität das Problem. Sie wissen nicht, ob alle relevante Daten und der erforderliche Datenkontext erfasst werden und machen sich Sorgen um Daten-Governance und Datensicherheit. Weil es so viele Baustellen gibt, zögern laut IDC viele Unternehmen, »ihre Daten End-to-End und für alle Geschäftsbereiche in der erforderlichen Qualität aufzubereiten und zu analysieren.«

Der Nutzen liege allerdings gerade im Abbau von Funktions- und Prozesssilos innerhalb des eigenen Fachbereichs und über Fachbereichsgrenzen hinweg. »Automatisierung und Integration werden zwar von Entscheidern immer wieder beschworen, die Umsetzung hingegen lässt auf sich warten«, so das trübe Fazit von IDC.

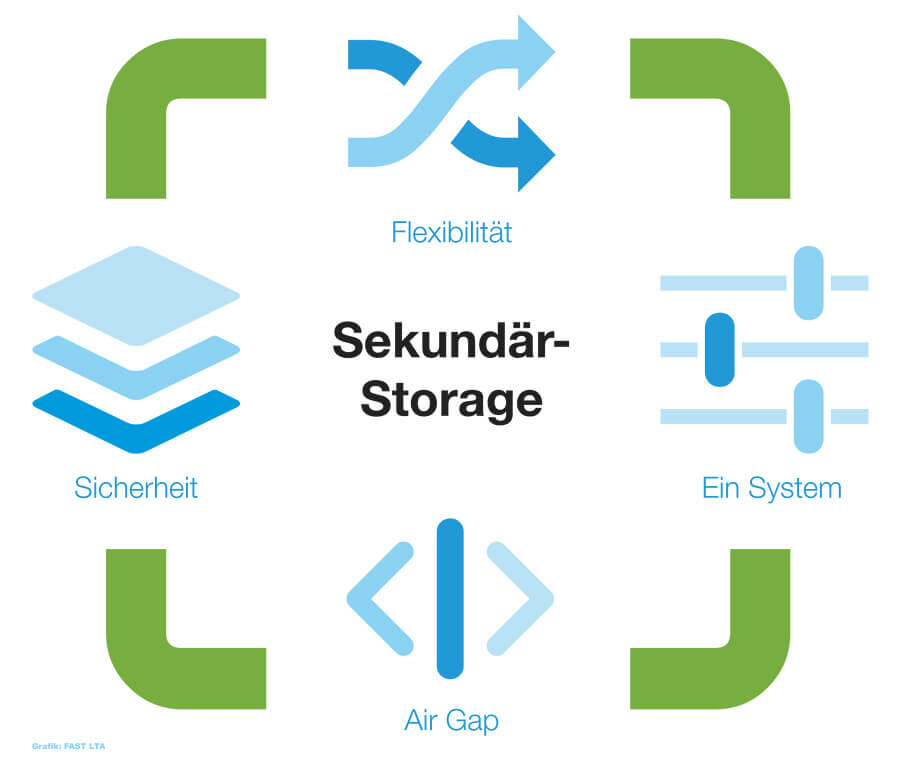

Die physische Trennung von Speichersystemen »Air-Gap« verhindert auch die Ausbreitung von Ransomware (Grafik: Fast LTA).

Die physische Trennung von Speichersystemen »Air-Gap« verhindert auch die Ausbreitung von Ransomware (Grafik: Fast LTA).

Schnelle Analysen und schnelles Disaster-Recovery

Jörg Karpinski, HuaweiJörg Karpinski, Sales Director bei Huawei in Deutschland, hat da andere Erfahrungen gemacht. »Bei vielen Projekten in Deutschland geht es nicht darum, wie man Daten speichert, sondern wie man Daten nutzt«, erklärte er am Rande einer Huawei-Veranstaltung bei München im Mai 2022. Das mag noch mit der Kundenstruktur des Unternehmens zu tun haben. Wenn sich die Einstellig aber durchsetzt, ist bald auch der Begriff »Sekundärspeicher« überholt.

Jörg Karpinski, HuaweiJörg Karpinski, Sales Director bei Huawei in Deutschland, hat da andere Erfahrungen gemacht. »Bei vielen Projekten in Deutschland geht es nicht darum, wie man Daten speichert, sondern wie man Daten nutzt«, erklärte er am Rande einer Huawei-Veranstaltung bei München im Mai 2022. Das mag noch mit der Kundenstruktur des Unternehmens zu tun haben. Wenn sich die Einstellig aber durchsetzt, ist bald auch der Begriff »Sekundärspeicher« überholt.

Schon jetzt wirbt Huawei für das All-Flash-Datacenter. Die Preise zwischen HDD und Flash-Speicher glichen sich ohnehin bald an. Und auch die Einsparungen beim Energieverbrauch, die besseren Kompressionsmöglichkeiten sowie die Vorteile durch nahezu ständige Verfügbarkeit aller Daten – ganz ohne aufwändige, langwierige und teure ETL-Prozesse – trügen dazu bei.

Hannes Heckel, Fast LTA Hannes Heckel, Director Marketing bei FAST LTA, gibt noch einen anderen Aspekt zu bedenken: »Das Thema Data-Protection hat einen grundsätzlichen Paradigmenwechsel durchlaufen: Vom einfachen Backup als Archiv, das man hoffentlich nie wieder benötigt, hin zum unternehmenskritischen Disaster-Recovery, um Daten zu jeder Zeit in unterschiedlicher Tiefe und Geschwindigkeit zuverlässig wiederherzustellen.« Seine Empfehlung lautet deshalb: »Wir halten den Einsatz von Flash-basiertem Speicher als primäres Sicherungs-Target, etwa für inkrementelle Backups und das Instant-Recovery, heute für unverzichtbar.«

Hannes Heckel, Fast LTA Hannes Heckel, Director Marketing bei FAST LTA, gibt noch einen anderen Aspekt zu bedenken: »Das Thema Data-Protection hat einen grundsätzlichen Paradigmenwechsel durchlaufen: Vom einfachen Backup als Archiv, das man hoffentlich nie wieder benötigt, hin zum unternehmenskritischen Disaster-Recovery, um Daten zu jeder Zeit in unterschiedlicher Tiefe und Geschwindigkeit zuverlässig wiederherzustellen.« Seine Empfehlung lautet deshalb: »Wir halten den Einsatz von Flash-basiertem Speicher als primäres Sicherungs-Target, etwa für inkrementelle Backups und das Instant-Recovery, heute für unverzichtbar.«

Die Festplatte wehrt sich

Die von IDC 2021 vorgelegten Marktzahlen für die weltweite Entwicklung bei HDDs und SSDs dämpfen die von Huawei verbreitete Euphorie allerdings etwas. Demnach ist die HDD auch im Rechenzentrum noch lange nicht am Ende. Für den Bedarf von Cloud Service Providern und den Kunden der Hyperscaler zum Beispiel prognostiziert IDC bis 2025 weltweit ein jährliches Wachstum der verkauften HDD-Speicherkapazitäten von 31 Prozent.

Im europäischen Enterprise-Markt erwartet IDC aber dennoch eine zunehmend schnellere Flash-Adaption von SSDs. All-Flash Arrays haben gemessen am Umsatz hier Hybrid Flash Arrays bereits 2020 überholt. Für ganz auf HDDs aufgebaute Enterprise-Storage-Systeme sagt IDC bis 2025 einen jährlichen Rückgang von 7,4 Prozent vorher. Sie kämen dann nur noch auf einen Marktanteil (gemessen am Umsatz) von knapp zwölf Prozent.

Wer sich von den Anbietern der All-Flash-Bewegung noch nicht so vorbehaltlos anschließen will wie Huawei, setzt daher auf Optimierung. Dazu gehört NetApp, das dabei auf Objektspeicher setzt. HPE stellt »intelligente Datenverwaltung« in den Vordergrund und betont dazu die Breite seines Portfolios, die für jeden Anwendungsfall etwas biete. Auch Dell setzt auf intelligentes Datenmanagement, um Kosten für sekundären Speicher zu reduzieren.

Frank Reichart, Fujitsu: »Ein hybrides Storage-System ist für Mittelständler meistens die beste Lösung.« »Bei Sekundärdaten ist das Ziel, große Datenmengen kostengünstig zu speichern, während die Zugriffszeiten keine große Bedeutung haben«, hält Frank Reichart, Senior Director Product Marketing Storage Solutions bei Fujitsu fest. »Hier eignen sich Festplatten mit einer hohen Kapazität und niedrigen Kosten pro TByte. Ein hybrides Storage-System, das es erlaubt, SSDs und Festplatten in einem System zu kombinieren, ist daher für Mittelständler meistens die beste Lösung«, empfiehlt Reichart.

Frank Reichart, Fujitsu: »Ein hybrides Storage-System ist für Mittelständler meistens die beste Lösung.« »Bei Sekundärdaten ist das Ziel, große Datenmengen kostengünstig zu speichern, während die Zugriffszeiten keine große Bedeutung haben«, hält Frank Reichart, Senior Director Product Marketing Storage Solutions bei Fujitsu fest. »Hier eignen sich Festplatten mit einer hohen Kapazität und niedrigen Kosten pro TByte. Ein hybrides Storage-System, das es erlaubt, SSDs und Festplatten in einem System zu kombinieren, ist daher für Mittelständler meistens die beste Lösung«, empfiehlt Reichart.

Weil Software in Rechenzentren inzwischen ziemlich gut dabei ist, »Hot Data« und »Cold Data« – also regelmäßig und selten oder gar nicht mehr genutzte Daten – zu identifizieren und auf die jeweils geeignete Plattform zu migrieren, empfehlen unabhängige Experten weiterhin unterschiedliche Speichermedien.

Festplatten bleiben für Sekundärspeicher auch deshalb noch eine Weile konkurrenzfähig, weil es weiterhin Fortschritte in der HDD-Entwicklung gibt. Dazu gehören etwa die Helium-Füllung der Laufwerke und neue Speicherverfahren wie Heat-assisted Magnetic Recording, Microwave-assisted Recording, Shingled Magnetic Recording (SMR) oder bei Western Digital neuerdings UltraSMR, die die Festplattenkapazität weiter erhöhen.

Datenmanagement statt Speichermanagement

»Es ist nicht ungewöhnlich, dass Datenverwaltungssoftware pro Kapazität mehr kostet als das Speichermedium, sodass aktuelle Lösungen die Kosten eher multiplizieren, als sie zu senken«, erklärt Betsy Doughty, Vizepräsidentin bei Spectra Logic. Sie geht daher davon aus, dass sich 2021 Unternehmen intensiver mit Storage Lifecycle Management und aktiven Archivierungslösungen beschäftigen, die die Storage-Gesamtkosten senken und dennoch für die erforderliche Verfügbarkeit der Daten sorgen.

Laut Doughty müssen Unternehmen ihre Speicherinfrastruktur nicht mehr vollständig neugestalten, um eine Software-Lösung für das Storage-Lifecycle-Management zu implementieren. Die Managerin geht, ebenso wie viele andere Experten und Marktbeobachter, davon aus, dass die Rolle der Hybrid-Cloud zunimmt.

Die zunehmende Cloud-Nutzung sorgt aber auch für erhöhten Bedarf an Sekundärspeicher bei den Unternehmen. Denn Firmen wie Google, Microsoft oder auch Salesforce überlassen die komplett oder weitgehend der Verantwortung der Anwenderunternehmen. Insbesondere für Microsoft 365 gibt es hier schon eine ganze Reihe von direkt darauf zugeschnittenen Angeboten, etwa von Acronis, Altaro, Arcserve, Barracuda MSP, Commvault, SEP und Storagecraft.

Von diesen Überlegungen ist es nur noch ein kleiner Schritt zu Themen wie Speicher-Virtualisierung, Software-Defined Storage (SDS) oder der Nutzung eines Storage Hypervisors. Um Storage-Ressourcen optimal zu nutzen, streben Firmen die richtlinien-basierte Bereitstellung und Verwaltung der Speicherkapazitäten unabhängig von der zugrundeliegenden Hardware an. Das hilft auch, einmal angeschaffte Hardware länger zu nutzen. Abstraktion und Pool-Bildung brechen die physischen Begrenzungen von Storage-Hardware auf. Der verfügbare Speicherplatz muss dann nicht mehr in Silos unterteilt werden. Von da ist es nur ein weiterer Schritt zur zentralen Analyse all dieser Daten.

Object-Storage und Sekundärdaten

Allerdings scheitert die oft noch an der Datenstruktur. »File- und Block-Storage-Varianten haben den Nachteil, dass sie zum einen recht statisch, zum anderen recht ortsbezogen sind«, fasst Siegfried Betke von treeConsult. zusammen. Das heißt, die Anwender oder das System müssen wissen, unter welchem Pfad oder in welchem Block die Daten liegen.

»Das verbessert sich bei Objekt-Storage: Er ist nicht hierarchisch und nicht ortsgebunden. Das erlaubt die Nutzung sehr verteilter Storage-Infrastruktur – und genau da geht der Trend hin.« Ein Nachteil ist heute noch, das Object-Storage hohe Anforderungen an die Leistung stellt. Für unstrukturierte Daten die immer wieder in ihrer Gesamtheit sehr punktuell nach bestimmten Informationen durchsucht werden sollen, bietet sich Object-Storage aber an.

Sicherheitskonzepte für Sekundärdaten

Kurt Gerecke, Storage-Experte für Tech Data: »Immer eine bis zwei Backup-Kopien auf einem Offline-Datenträger« Hersteller, Sicherheitsexperten und Branchenbeobachter werden zudem nicht müde darauf hinzuweisen, dass einerseits reine Backups keine geeignete Form der Speicherung von Sekundärdaten sind, andererseits auch Sekundärdaten ein Backup benötigen. Dabei kommt dann auch Tape-Technologie noch zum Tragen. »Jede moderne Datenschutzlösung sollte eine bis zwei Backup-Kopien auf einem Offline-Datenträger vorhalten«, empfiehlt zum Beispiel Kurt Gerecke, Storage-Experte für Tech Data. Eine Begründung: Tape ist abgekoppelt vom Netzwerk und damit nur sehr schwer für Cyberangriffe erreichbar.

Kurt Gerecke, Storage-Experte für Tech Data: »Immer eine bis zwei Backup-Kopien auf einem Offline-Datenträger« Hersteller, Sicherheitsexperten und Branchenbeobachter werden zudem nicht müde darauf hinzuweisen, dass einerseits reine Backups keine geeignete Form der Speicherung von Sekundärdaten sind, andererseits auch Sekundärdaten ein Backup benötigen. Dabei kommt dann auch Tape-Technologie noch zum Tragen. »Jede moderne Datenschutzlösung sollte eine bis zwei Backup-Kopien auf einem Offline-Datenträger vorhalten«, empfiehlt zum Beispiel Kurt Gerecke, Storage-Experte für Tech Data. Eine Begründung: Tape ist abgekoppelt vom Netzwerk und damit nur sehr schwer für Cyberangriffe erreichbar.

Quantum hat daher Ende 2021 seine Datenspeicher-Plattform ActiveScale um ActiveScale Cold Storage und Object Storage Services um das Angebot Objekt-Speicher für kalte Daten auf Tape erweitert. Damit will Quantum die Langzeitarchivierung und gleichzeitig den günstigen Zugriff bei geringen Transferkosten auf kalte Daten sicherstellen, beispielsweise für Analyse-Zwecke. Die neuen Angebote sollen die Kosten für kalte Archivdaten um 80 Prozent reduzieren und es Unternehmen erlauben, sie bei Bedarf über Jahre oder sogar Jahrzehnte dennoch schnell zu nutzen.

Mit dem Tape-Archiv-Speichersystem Scalar i6H hat Quantum den zusammen mit Hyperscalern und für Hyperscaler entwickelten Ansatz auch für Firmen verfügbar gemacht, die ein Private-Cloud aufbauen wollen. Für sie kann die Bandautomatisierungs-Lösung komplett montiert in einem Rack geliefert werden. Ziel ist es laut Anbieter, die Lösung in weniger als einer Stunde nach Anlieferung zu installieren und in Betrieb zu nehmen. Die anschließende Verwaltung soll auch in größeren Umgebungen mit mehreren Systemen keine spezifische Tape-Erfahrung erfordern.

Auch gesetzliche oder versicherungsrechtliche Auflagen, die häufig eine sehr langfristige Aufbewahrung von Daten notwendig machen, sind Argumente für Tape. Nicht zuletzt spielt Tape laut Tech-Data-Manager Gerecke bei KI-Projekten eine wichtige Rolle. Das mag überraschen. Aber erstens sind hier immer große Datenmengen involviert. Zweitens müsse auch, wenn ein neuronales Netz für Deep- und Machine-Learning-Projekte trainiert ist, die Rückverfolgbarkeit der verwendeten Daten langfristig sichergestellt werden. Schließlich könnte der Algorithmus Fehler enthalten, die erst sehr viel später bemerkt werden.