IBM Studie: Auch Mittelstand packt endlich Big Data an

Der Mittelstand will mit Big Data vor allem seine Kunden besser verstehen und gezielter auf deren Wünsche eingehen – so das zentrale Ergebnis der weltweiten IBM-Studie »Analytics: The real-world use of big data«. Demnach haben etwa drei Viertel der befragten Mittelständler bereits mit Big-Data-Projekten begonnen oder planen solche.

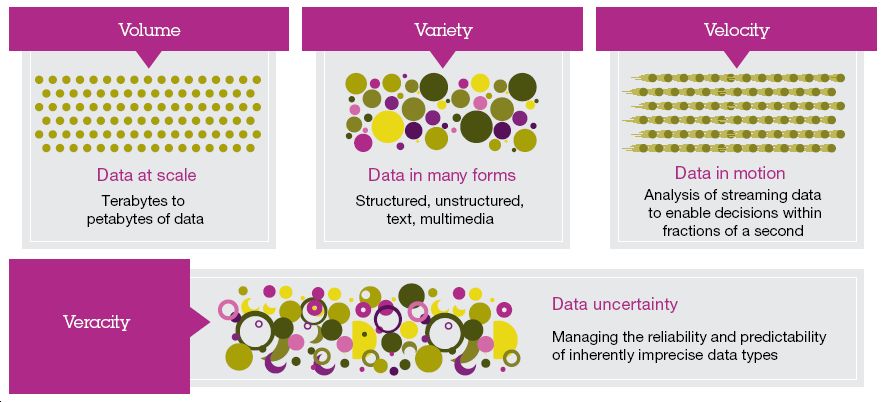

Ein Vergleich mit Großunternehmen zeigt dabei einen interessanten Unterscheid: Im Mittelstand beginnt Big Data deutlich früher, nämlich bereits bei einem Datenvolumen von einem TByte – bei großen Unternehmen erst bei 100 TByte. Doch nicht nur die Datenmenge macht Big Data aus, sondern die vier Vs: Außer Volume sind dies Variety, Velocity und Veracity, also Menge, Form, Geschwindigkeit und Verlässlichkeit der Daten.

Big Data weiß, was der Kunde morgen wünscht

»Unsere aktuelle Studie zu Big Data zeigt, dass sich im Mittelstand bereits drei von vier Unternehmen intensiv mit dem Thema Big Data beschäftigen – jedes vierte Unternehmen hat sogar bereits konkrete Projekte in Angriff genommen«, sagt Martina Fiddrich, Leiterin des Geschäftsbereichs Mittelstand und Partnership Solution Center, DACH bei IBM. »Auch was sich der Mittelstand konkret von Big Data erhofft, zeigt unsere Studienauswertung – er will seine Kunden, deren Bedürfnisse und Verhalten besser verstehen und schneller auf deren Wünsche eingehen.«

Die Wünsche der Kunden von den Daten – statt den Augen – ablesen, das ist das große Ziel, das der Mittelstand laut der IBM-Studie weltweit mit Big Data Analytics erreichen will. Zudem wollen die Unternehmen mit ihrer Datenanalyse schneller neue Chancen im Markt erkennen und auf veränderte Geschäftsanforderungen reagieren.

Von Volume, Variety, Velocity und Veracity

Laut IBM Studie sind sich beim Thema Velocity große und mittelständische Unternehmen einig: Gut 20 Prozent der Befragten wollen ihre analysierten Daten sofort in Echtzeit zur Verfügung haben, ein weiteres Viertel innerhalb von einem Tag. Nur einem Drittel genügt es, wenn die Datenauswertung am nächsten Geschäftstag für die Entscheidungsfindung genutzt werden kann. Jedes sechste Unternehmen akzeptiert es, dass zwischen Datengewinnung, Analyse und Verfügbarkeit eine Woche liegt.

Beim dritten V – der Variety – dreht sich alles um die Form der Daten: Sie liegen entweder strukturiert oder unstrukturiert als Text, Audio- oder Videoformat vor und stammen aus unterschiedlichen Quellen wie Transaktionen, Messungen oder auch sozialen Netzen. Insgesamt zeigt sich, dass der Mittelstand vor allem interne Daten für Big Data Analytics nutzt.

Laut IBM Studie stehen mit 88 Prozent die Daten aus Transaktionen ganz oben auf der Big-Data-Liste, 81 Prozent der Informationen stammen aus dem Datalogging – also Prozessen, wo ein Maschine-Sensor-System die Daten erfasst. Zudem nutzt der Mittelstand weiteres Wissen, das aus E-Mails (58 Prozent) und Events (56 Prozent) generiert wird.

43 Prozent nutzen bereits Facebook- oder Twitter-Daten

Interne Daten sind vor allem deshalb die erste Wahl für Big Data Analytics, weil Unternehmen sie bereits seit Jahren über ERP (Enterprise Resource Planning) oder Business-Intelligence sammeln, strukturieren und standardisieren. Externe Daten aus sozialen Netzen wie Facebook oder Twitter nutzen bisher 43 Prozent der befragten Mittelständler für Big Data.

Übergeordnet für das gesamte Thema Big Data ist das vierte V – Veracity. Also wie gut ist die Verlässlichkeit und Qualität der Daten? Analyse und Auswertung der Daten muss stets im Blick haben, ob und in welchem Ausmaß Informationen unsicher sind. Während Unternehmen den internen Daten meist großes Vertrauen entgegenbringen, sind externe Daten mit weitaus mehr Unsicherheit behaftet wie Wetter- oder Börsendaten. Big-Data-Systeme müssen diese Unsicherheiten bewerten und in die Analyse einbeziehen.

- Download der IBM-Studie über Big Data

- Mittelstands-Lösungen von IBM

- IBM forciert mit Trusteer-Kauf sein Cybersecurity-Engagement

- IBM lädt zum fünften »SVC & Storwize User Day« am 24. September 2013 nach Mainz

- IBM legt auf »CeBIT 2013« großen Fokus auf Big Data

- IBM positioniert »Smarter Storage« als Motor für Big Data

- Experton Group: Big Data ist in Deutschland angekommen

- Mehr Infos über Big Data im speicherguide.de-Schwerpunkt